Notre ReX du Devfest Nantes 2025 24 Oct 7:01 AM (yesterday, 7:01 am)

L’édition 2025 du DevFest Nantes, qui a réuni plus de 3500 passionnés à la Cité des Congrès sur deux jours intenses, restera un millésime à part pour l’équipe Ippon. Cette année, nous étions une vingtaine de Nantais, mobilisés et enthousiastes, accompagnés de nos speakers bordelais Vivien Malèze et Sébastien Oddo, venus partager leur expertise sur Open Telemetry et de Thomas Boutin venu de Tours pour échanger sur les impacts sociaux et environnementaux de nos smartphones. Notre stand n’a pas désempli, suscitant de nombreux échanges et rencontres tout au long de l’événement, entre deux conférences.

Dans la suite de cet article, nous vous proposons un retour détaillé sur les talks qui ont particulièrement retenu notre attention lors de cette nouvelle édition du DevFest. Plongez avec nous dans ces éclairages techniques qui ont nourri nos échanges et permis d’enrichir notre savoir-faire collectif.

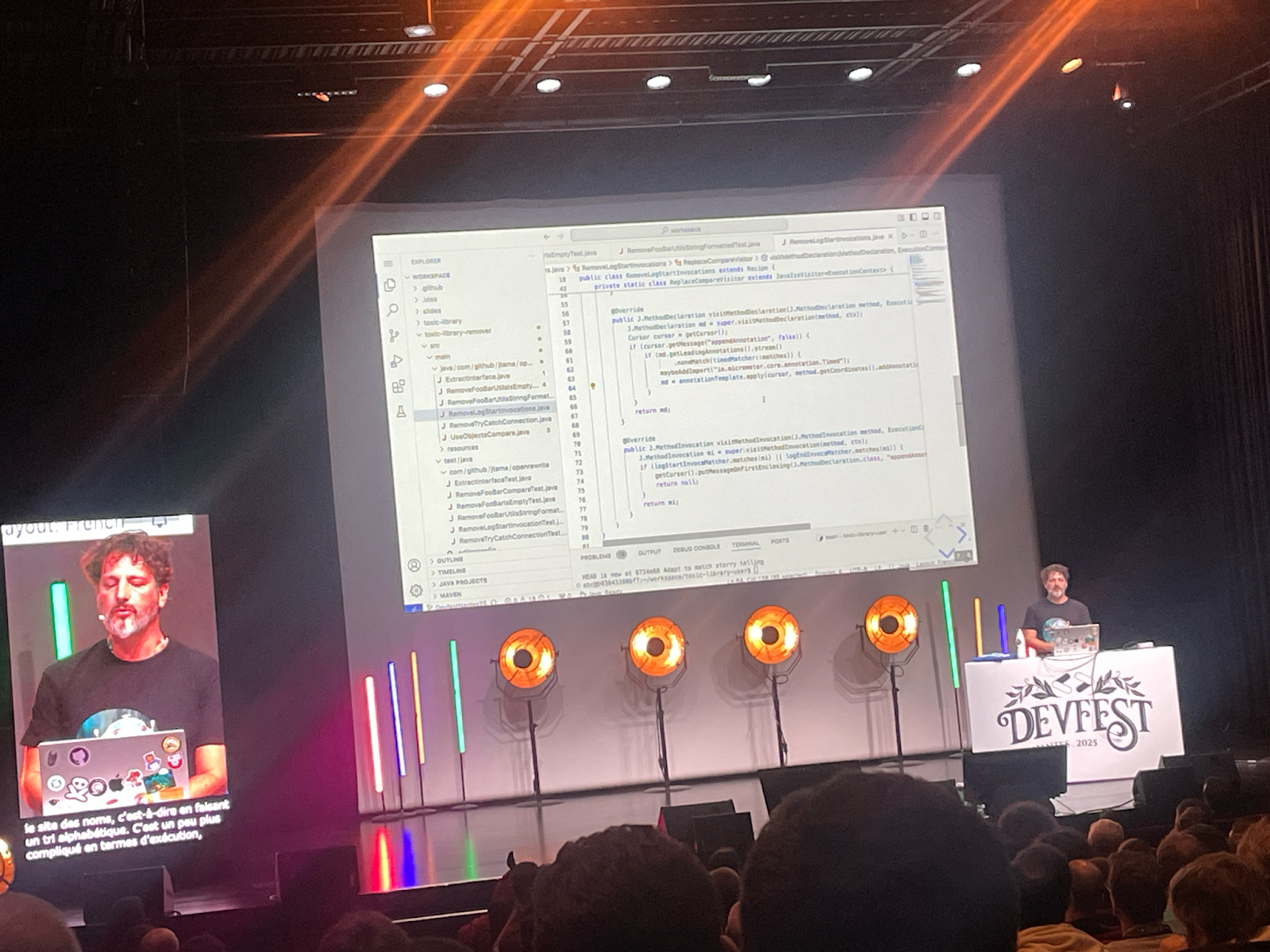

OpenRewrite: Refactor as code

Présenté par Jérôme Tama – Onepoint Bordeaux

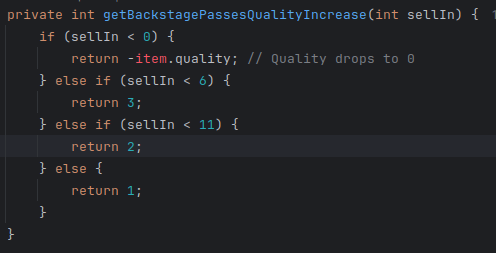

Jérôme débute en comparant le code à une maison : tout y est présent, mais pas toujours à sa place. Cette métaphore illustre parfaitement les difficultés de lecture et de maintenance rencontrées par les développeurs. Son objectif est clair : montrer comment réécrire le code de manière plus efficace, maîtrisée et automatisée.

Pour cela, il présente OpenRewrite, un framework open source conçu pour automatiser la réécriture de code. Testable, distribuable et multi-langage, il supporte Java, Kotlin, Groovy, YAML, et plus récemment TypeScript. Le cœur du framework repose sur le concept de “recipes”, de petites unités atomiques capables de parcourir et transformer le code. Ces recettes peuvent se composer entre elles pour réaliser des modifications plus complexes.

OpenRewrite s’appuie sur le Lossless Syntax Tree (LST), un arbre syntaxique préservant la mise en forme et les commentaires, garantissant ainsi que la structure du code reste intacte après transformation. Les recettes peuvent être exécutées de différentes façons, que ce soit via la CLI ou des plugins comme ceux de Maven.

Pour illustrer la puissance de l’outil, Jérôme montre la migration d’un projet de JUnit 4 vers JUnit 5 : une tâche habituellement longue de trois semaines, réalisée en quelques secondes grâce à une recette existante. Il précise qu’il existe des centaines de recettes gratuites, et qu’il est même possible d’en créer sans écrire de code, via une approche déclarative.

Cependant, Jérôme met en garde : un outil aussi puissant doit être utilisé avec discernement, notamment pour la maintenance de bibliothèques internes ou open source. En conclusion, OpenRewrite incarne une approche “refactor-as-code” à la fois pragmatique, testable et reproductible, offrant un véritable gain de temps et une amélioration durable de la qualité du code.

Unconf - Paroles de dev' : la conférence où vous avez la parole !

Par Benoit Martin et Damien Raude-Morvan

Cette Unconference, un des formats inédits pour l’édition 2025 du DevFest, était une réelle découverte. Et pour cause : il n’y a pas de sujet choisi au préalable. Après un rappel des règles de bonnes conduites pour les 2h que nous allions passer ensemble (écoute, empathie, bienveillance), Benoit et Damien nous ont invité à faire un brainstorming. Nous devions réfléchir aux sujets que nous souhaitions aborder avec les participants. Nous les avons noté sur des post-its, puis nous les avons mis sur un tableau. Ensuite, nous avons voté pour nos sujets préférés. Finalement, nous avons séparé la table en deux groupes en fonction des thématiques : une sur l’ubérisation des métiers du développement et la place des invisibles dans nos métiers. L’autre sur les problématiques liées au refactoring et à la gestion de la dette à grande échelle, avec ensuite un sujet sur l’avenir du TDD avec l’avènement de l’agentique. Sur toute la durée du créneau, il était possible de changer de table comme nous le voulions, voire de quitter l’assemblée pour retourner sur le salon. La loi des deux pieds était bien en place 🙂. De manière analogue, il n’y avait pas de temps imparti pour aborder un sujet : il pouvait aussi bien être traité en 10mn qu’en 1h30.

Comme nos deux animateurs le stipulaient en préambule, nous sommes aussi nombreux et nombreuses à venir en conférence pour les discussions qui se déroulent entre les présentations. Et c’est vrai que ce format présentait ce côté rafraîchissant, et comblait les manques que nous pouvons parfois ressentir en sortie d’une présentation : manque de retour concret du terrain, débat sur les limites d’une approche ou encore l’impossibilité de poser des questions parce que le temps imparti était dépassé.

Au final, on peut en ressortir avec des outils à tester comme vibe-flow et des certitudes qui se retrouvent infirmées ou confirmées.

En conclusion, merci ! Et si le format vous intéresse, les software crafters de Nantes ont l’habitude de fonctionner de cette manière. Jetez-y un oeil !

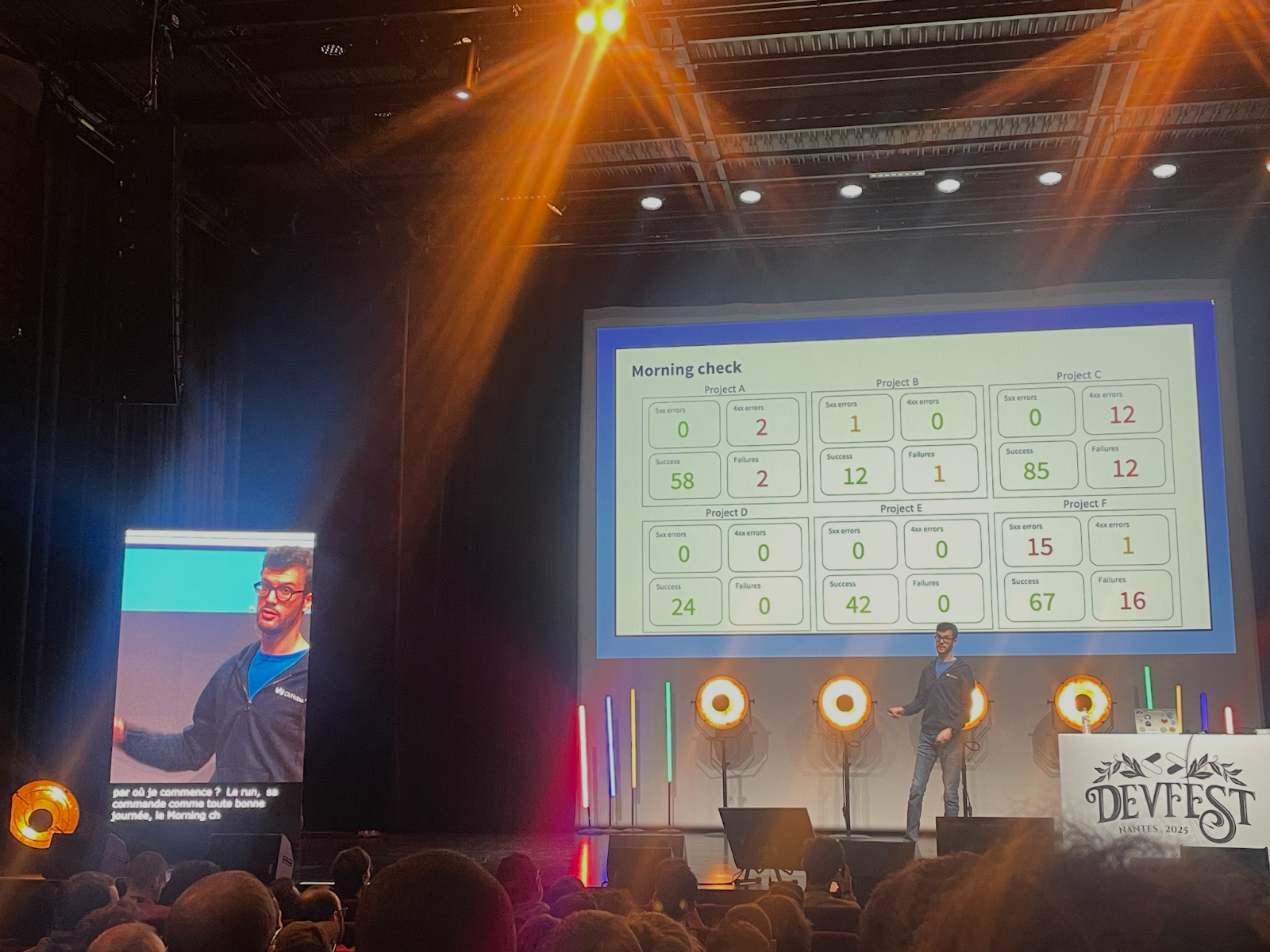

Détective de la prod: résoudre l’enquête avant le crash

Présenté par Sébastien Ferrer – OVHCloud Nantes

Sébastien ouvre son talk en opposant les deux grandes phases du cycle de vie logiciel : le build (développement) et le run (exploitation).Fort de son expérience d’astreinte, il décrit la difficulté de gérer plusieurs projets sans toujours les connaître en profondeur.

Être “de run”, explique-t-il, signifie assurer le suivi des incidents, des tickets et des indicateurs clés comme le TTA et le TTR, tout en restant le principal point de contact en cas de problème.Pour diagnostiquer efficacement, il faut adopter une posture de détective, en s’appuyant sur la Root Cause Analysis (RCA).

Différentes méthodes existent : le drill down, rigoureux mais long, et le bottom up, plus adapté aux couches basses comme le réseau.

Dans tous les cas, la priorité reste de restaurer le service avant de chercher la cause profonde.Une fois la situation stabilisée, vient le temps du cadrage, de la reproduction et du post-mortem.La méthode des Five Whys aide alors à remonter à l’origine du problème.

Cette logique s’inscrit dans une philosophie claire : “Développe ton application comme si tu allais la maintenir.”

Sébastien insiste ensuite sur l’importance des logs : anticiper les informations utiles, structurer les niveaux, et surtout adopter un format standardisé pour faciliter leur exploitation.Le monitoring complète cette visibilité, en offrant des métriques, des alertes et une meilleure réactivité face aux incidents.

Enfin, il relie ces bonnes pratiques à une démarche LEAN : uniformiser les projets grâce à des librairies communes, utiliser un linter pour garantir la cohérence du code, et continuer à progresser, notamment via son blog blog.kimi.ovh.

Angular Signal - Monde asynchrone, état dépendant

Workshop (lab de 2h) présenté par Modeste Assiongbon et Camille Pillot

Le DevFest, ce n’est pas que des conférences, mais aussi des “labs” ! Il s’agit d’ateliers de 2h, avec une trentaine de participants, où l’animateur anime une sorte de TD au travers de slides et petits exercices que les participants réalisent sur leur ordinateur.

J’ai assisté à un lab autour des signal et rxResource Angular, fraîchement matures depuis Angular 19. Ces nouveaux outils permettent de gérer des Observable de manière bien plus concise, tant dans le code TS que HTML. Elles permettent un affichage de l’état d’erreur ou de chargement simplifié. Les exercices se poursuivent sur des notions similaires avec les httpResource (qui simplifient la syntaxe d’appels serveur simples) et les LinkedSignal (qui rendent une computed modifiable au lieu de lecture seule).

Pourtant fervent utilisateur d’Angular au quotidien, j’ai appris plein de choses au travers de cet atelier, que je pourrai désormais appliquer sur mes projets !

Les exercices étaient très bien décrits et les slides très claires. La présentation est disponible sur SlideShare. Le dépôt avec les exercices est disponible sur GitHub.

Mobiles en Perspective: quels impacts sociaux et environnementaux ont nos smartphones ?

Présenté par Thomas Boutin (Ippon Technologies) et Robin Caroff (U Tech)

En 2007, le smartphone entrait dans nos vies. Depuis il est devenu notre réveil, notre appareil photo, notre carnet d’adresses, notre GPS, etc et les usages évoluent constamment au fur et à mesure des nouveautés proposées par les constructeurs et les éditeurs logiciels. Mais à quel prix ?

« Mobiles en Perspective », c’est une session un peu à part au DevFest Nantes 2025 : un format unconf, participatif, inspiré de la Fresque du Climat. Pas de slides ni de monologue : ici, on échange, on réfléchit ensemble et on explore les coulisses du numérique. On va donc essayer de ne pas tout dévoiler, parce que c’est avant-tout un format où le participant est acteur de l’atelier.

Thomas et Robin nous font redécouvrir le mobile étapes par étapes, avec une série de cartes prédéfinies : de sa fabrication à nos usages quotidiens, en passant par les infrastructures qui le font fonctionner. On parle beaucoup environnement aussi dans cet atelier. L’utilisation de ressources comme l’eau et les minerais lourds nécéssaires à la construction du matériel qu’il faut extraire (souvent dans des pays exploitant le travail des enfants.). La difficulté à recycler un smartphone, et son manque de rentabilité (moins de 5€ de matière première à récupérer) ainsi que le décyclage (perte de valeur des matériaux lors du recyclage) sont les sujets qui m’ont le plus choqués.

Enfin, les animateurs nous sensibilisent sur les impacts humains qui en découlent. Parfois positifs (accessibilité, changement des méthodes de travail), et trop souvent négatifs (santé mentale, isolement, fracture numérique), le smartphone a complètement changé nos modes de vie et nos habitudes.

Le tout, dans une ambiance conviviale, ouverte à toutes et tous, sans prérequis techniques. L’objectif n’est pas de culpabiliser, mais de comprendre ensemble et d’imaginer un numérique plus soutenable. Et pour celles et ceux qui voudraient prolonger la réflexion : tout le contenu de l’atelier est open source et libre d’accès sur GitHub.

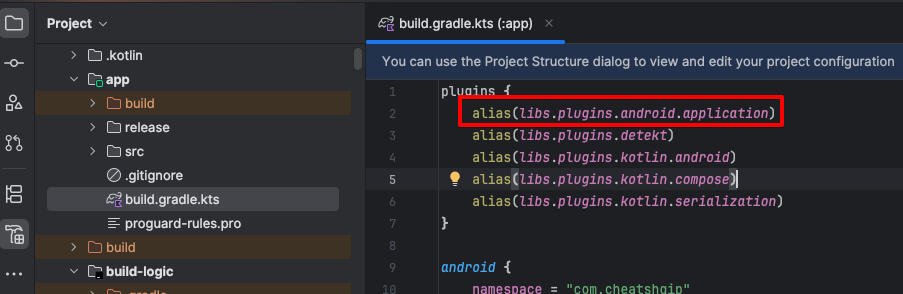

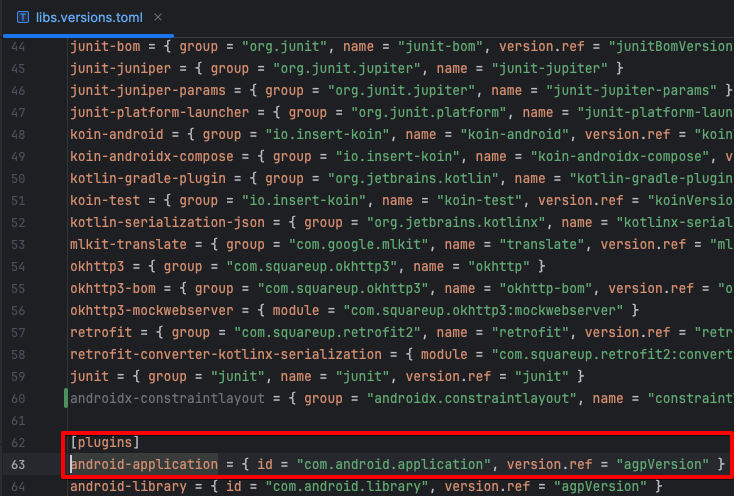

L'aspirant chevalier LynxJS peut-il détrôner monseigneur React Native et le duc de Flutter ?

Présenté par Simon Bernardin - Mobiapps

Il existe déjà un grand nombre de frameworks multiplateformes promettant le Saint Graal : pouvoir déployer nos applications sur toutes les plateformes disponibles (android/ios/web/desktop) à partir d’une seule codebase.

Simon Bernardin, vêtu de son adorable armure et son heaume de guerre, vient alors nous présenter LynxJS, un nouveau framework cross-platform développé par ByteDance (le studio derrière TikTok), sorti le 5 mars 2025, qui cible Android, iOS, HarmonyOS et prochainement le web. Malgré son jeune âge, il est apparemment déjà utilisé par ByteDance en interne.

L'atout principal de LynxJS est son architecture à double thread automatique : le thread principal gère uniquement l'affichage tandis qu'un thread secondaire traite tous les calculs et interactions par défaut. Le framework utilise un moteur JavaScript développé spécifiquement pour le framework (Prim.js), écrit en Rust, et qui serait nettement plus rapide que ses concurrents (environ 28% plus rapide que QuickJS).

Simon termine sa présentation en définissant ses axes d’amélioration et ses points forts. En premier lieu, l’expérience développeur reste quasi inexistante sur la partie mobile avec beaucoup de choses manquantes : absence de gestion automatisée de la publication (tout doit être configuré manuellement par plateforme) et impossibilité d'utiliser des modules natifs existants, obligeant les développeurs à coder eux-mêmes les fonctionnalités natives.

Néanmoins, Il tenait à souligner les performances fluides "out of the box", la documentation qui est de qualité, ainsi que la compatibilité avec l'écosystème React permettant l'utilisation d'assistants/agents IA pour faciliter le développement.

C’est un aperçu intéressant que nous offre Simon ici bien que LynxJS reste très jeune et immature avec un écosystème limité, il mérite d'être surveillé grâce à ses promesses de performances tenues et l'écoute active de ByteDance vis-à-vis de la communauté.

SELECT 'amazing_features' FROM "postgresql"

Présenté par Kevin Davin - Gradle

Dans son talk, Kevin a mis en avant des fonctionnalités utiles, pratiques et souvent méconnues de SQL et de Postgres. L’objectif était de nous faire connaître ces features pour nous éviter de tout recoder “from scratch”.

Voici une liste non exhaustive de ces fonctionnalités:

- Les CTE (Common Table Expressions)

Leur usage améliore la lisibilité des requêtes en fragmentant les étapes. Dans certains cas, le plan d’exécution peut bénéficier d’une exécution parallèle et donc optimiser le temps d’exécution de la requête.

- Fonctions de fenêtrage (Window Functions)

Les window functions sont un outil SQL standard, qui permettent d’effectuer des calculs sur un ensemble de lignes liées à la ligne courante, sans regrouper les données comme avec GROUP BY. Un exemple courant est la déduplication via ROW_NUMBER().

Le mot-clé LATERAL permet de faire référence à des colonnes de la requête “parente” dans une sous-requête du FROM, ce qui ouvre beaucoup de possibilités (agrégations, appels de fonctions, filtrages dépendants).

Cela peut améliorer les performances en évitant des sous-requêtes coûteuses ou des jointures redondantes

L’ancienne pratique du SERIAL (auto-increment) continue d’exister, mais l’usage de UUID est recommandé pour certaines tables (notamment dans des environnements distribués ou microservices) pour éviter les attaques par énumération (si les identifiants sont séquentiels, un attaquant pourrait “deviner” des IDs).

PostgreSQL supporte nativement le type uuid et peut en générer via des fonctions intégrées comme gen_random_uuid() ou uuidv4().

Les contraintes (clé primaire, clé étrangère, contraintes de CHECK, contraintes d’unicité) sont essentielles pour protéger la cohérence et éviter la corruption de données.

Il vaut mieux s’appuyer sur les contraintes déclaratives du SGBD que sur du code applicatif pour valider la logique métier.

La commande NOTIFY permet de notifier d’un événement survenu dans la base de données. Il peut être accompagné du contenu de cet événement (le contenu d’un item qui vient d’être inséré en base par exemple). Il envoie cet événement à l’application qui a exécuté un LISTEN sur ce channel.

Les Foreign Data Wrappers permettent à PostgreSQL de consulter des sources externes comme s’il s’agissait de tables locales. Une table externe est créée et pointe sur la source externe. Cela permet d’exécuter facilement des opérations depuis Postgresql.

D’autres fonctionnalités peuvent permettre d’optimiser l’utilisation de votre moteur Postgresql (ltree, les types, jsonb pour stocker des données non structurées, … )

Let’s play Factorio - Ou “Comment j'ai appris à refactor mon code en jouant à Factorio”

Conférence présentée par Julien Wittouck

Julien utilise Factorio, un jeu d'automatisation industrielle, pour illustrer des concepts d'architecture logicielle. Dans ce jeu, le joueur doit construire des chaînes de production complexes pour transformer des ressources brutes en produits sophistiqués.

L'étape du PoC

Au départ, le joueur crée rapidement des usines reliées entre elles pour obtenir un résultat fonctionnel. On obtient vite du "code spaghetti" : un enchevêtrement chaotique difficile à comprendre et à faire évoluer.

Modularisation et isolation

En regroupant les usines par type de transformation, on crée des modules spécialisés qui alimentent les autres. Cette approche fait émerger des "couches" de responsabilités, comparable à une architecture en lasagne. Julien présente également les microservices via des drones autonomes qui transportent les ressources : excellente scalabilité (copier-coller de modules), mais problèmes d'observabilité avec des flux difficiles à suivre.

Urbanisation

Pour passer à l'échelle, on utilise des bus partagés auxquels se connectent les modules, permettant de déployer facilement des "quartiers" entiers (parallèle avec l'IaC). Julien illustre aussi les problématiques de sécurité (attaques aliens = cyberattaques) avec son "firewall" de tourelles lance-flammes, et l'importance de l'alerting via des sondes surveillant les débits et ressources.

On se rend bien compte dans cette conférence que le jeu vidéo permet d'expérimenter et visualiser des concepts architecturaux abstraits de manière ludique. Comme le dit Julien : "Je ne joue pas quand je fais du Factorio, je travaille" – les leçons tirées du jeu sont directement applicables à l'architecture logicielle.

Conclusion

Cette édition 2025 du DevFest Nantes aura été riche, inspirante et fédératrice pour nos Ippons. Ces deux jours nous ont permis d’explorer de nouvelles approches, de confronter nos pratiques et d’alimenter nos réflexions, autant sur les sujets techniques que sur l’impact de notre secteur. Nous repartons avec des idées concrètes à mettre en œuvre, des échanges qui continueront d’alimenter nos projets, et l’envie de faire grandir ces apprentissages au sein de nos équipes.Un grand merci à toutes celles et ceux rencontrés sur place pour leur énergie et leur curiosité. Nous avons déjà hâte de vivre la prochaine édition et de poursuivre ces discussions qui étaient, pour la plupart, légendaires !

Une journée à la première PlatformCon de Paris 24 Oct 12:30 AM (yesterday, 12:30 am)

Le Jeudi 16 Octobre 2025 avait lieu la très attendue première édition de la PlatformCon Live à Paris, premier événement organisé par l’Organisation Platform Engineering et nos collègues de chez WeScale, dédié au Platform Engineering en France. Ce sujet étant une de nos priorités depuis cette année, nous nous devions d’être de la partie, l’occasion de retrouver les amoureux du Platform Engineering. Chez Ippon Technologies, ce vaste sujet concerne tout nos corps de métier et ce faisant nous avions constitué une équipe de choc pour y participer, tous adeptes de la philosophie DevSecOps et une vision produit autour du Platform Engineering (Architecte Cloud & DevOps, ML Ops, Tech Lead Software Engineering, Coach Craftsmanship et notre Strategy Lead Platform Engineering). Le sujet de Platform Engineering ne se cantonne pas à nos collègues Ops (ou SRE, infra, DevOps Chapter, selon vos noms chez vous) mais bien à toute personne gravitant au sein d’une DSI pour construire les produits digitaux d'aujourd'hui et demain.

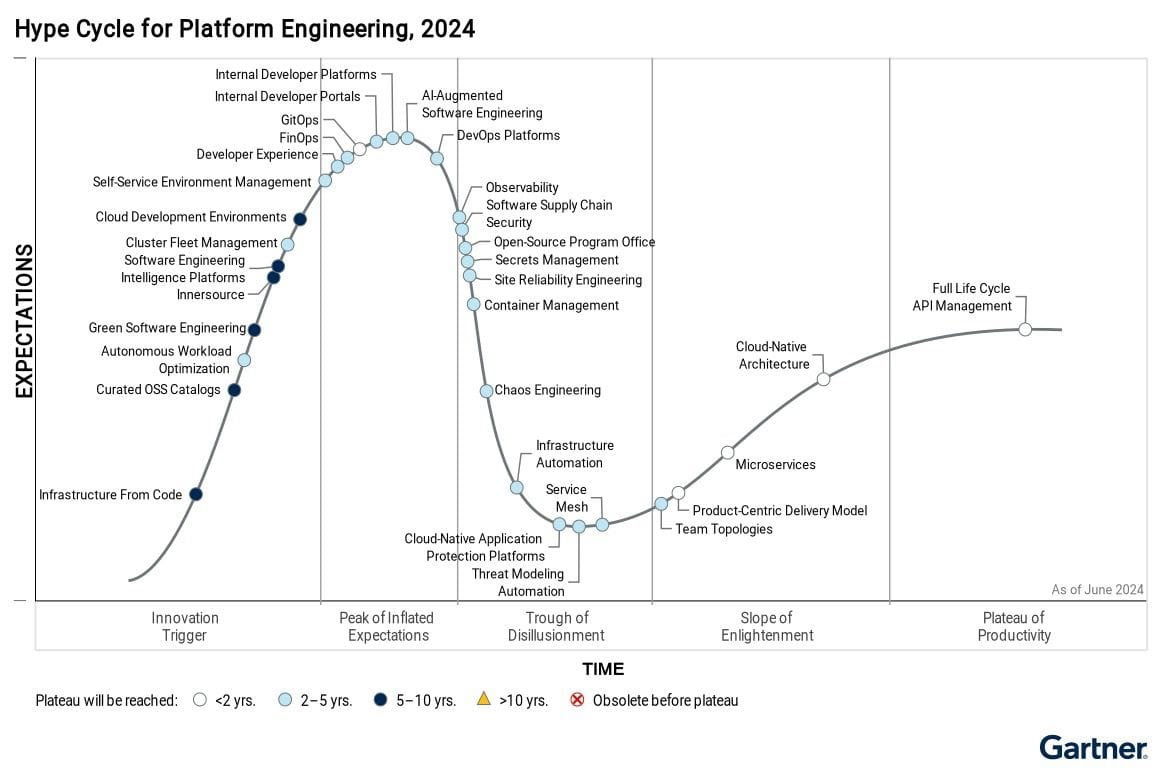

Le Platform Engineering, comme nous l’a présenté Luca Galante, contributeur principal de l’Organisation Platform Engineering, lors de la Keynote d’ouverture, a fortement progressé et s’est ancré de plus en plus dans la vie des entreprises tech, passant d’une composante dans les Hype Cycles (cycle des tendances) du Software Engineering d’après Gartner, à une évolution clefs de l’IT qui a son propre cycle de vie. Une statistique plus concrète: Gartner prévoyait une adoption du Platform Engineering chez 80% des entreprises tech d’ici 2026 et en fin de compte en 2025, 90% des entreprises ont entamé des démarches pour adopter ses pratiques d’après l’institut DORA (DevOps Research and Assessment).

Si le Platform Engineering était d’abord une notion dédiée au développement logiciel, son impact avait l’air de s’étendre à d’autres horizons et de s’appliquer dernièrement à l’infrastructure, la data et encore l’IA. Le sujet de l’IA a forcément été abordé lors de cette Keynote et Luca Galante n’a d’ailleurs pas manqué de rappeler l’importance du Platform Engineering et de ses principes pour adopter correctement l’IA. La deuxième partie de la Keynote était présentée par Kelsey Hightower, ingénieur logiciel et conférencier. À travers son intervention, il a précisé un point que beaucoup de personnes se posent: non, le Platform Engineering n’est pas une invention de ces dernières années, c’est un nom qui a été apposé à une tendance qui existe depuis longtemps, la Plateformisation, mais qui n’avait jamais été correctement définie avant.

Ce que n’est pas la PlatformCon

Tout d’abord, ce n’est pas un rassemblement d’experts Unix, de mangeurs de hardware ou fanatiques de bare metal (même si une majorité en est passionnée). Il s’agit d’un rassemblement autour d’une vision partagée sur comment faire mieux dès demain en termes d’organisation de votre DSI.

Si vous attendiez d’avoir à PlatformCon la recette magique parfaite pour monter une Plateforme de développement interne ou de connaître la stack technique idéale pour la mettre en place alors vous serez déçu.

Une plateforme IT, la majorité des entreprises en possède une qui s’est construite au fil des 10 voir 20 dernières années avec ses évolutions majeures (l’arrivée de l’agilité, l’émergence de la virtualisation puis de la conteneurisation, l’avènement de la philosophie Cloud & DevOps qui s'orna du préfix Sec quelques années plus tard).

Ce qu’est la PlatformCon

C’est avant tout une journée où nous pouvons échanger sur nos expériences (réussites comme échecs) autour de la mise en place d’une plateforme. Peut-on considérer que la PlatformCon est aux DevOps ce qu’est DDD Europe au craftsmanship ?

Bien sûr, on va parler solution technique sur table pour accélérer la Plateformisation. Vous n’aurez jamais autant entendu le terme Kubernetes à une conférence … ou alors peut-être à la KubeCon 😀! Mais toujours avec un énorme panneau “warning”, vous indiquant d’être vigilant sur les technologies présentées car bien souvent, elles sont amenées dans un contexte particulier pour des besoins propres à l’entreprise (ne faites pas de Kubernetes si vous êtes au début de votre chemin pour la Plateformisation, baby step first).

Cette année, le focus a été sur des retours d’expérience de mise en place de Platform Engineering pour diverses entreprises avec chacune leur modèle (de la société offrant des service numériques, en passant par la banque, la plateforme data mais aussi la startup boostée par des investisseurs, etc…). Grâce à ce panel d’entreprises avec chacune leur stratégie d’évolution, leur budget, leur philosophie organisationnelle, on peut arriver à trouver des idées / similarités à notre entreprise et s’en inspirer pour à son tour se challenger et grandir.

Que faut-il retenir ? En bref

KISS: Keep it simple, stupid

Cet acronyme n’a jamais été aussi vrai. Tous les speakers qui sont intervenus sont alignés sur cette vision. Vouloir aller trop vite et trop complexe, dans le cadre de la mise en place d’une plateforme, est un échec assuré.

Tout d’abord, on commence par mettre à disposition des API Rest pour consommer les solutions et services. Même si pour certains cette étape est évidente, pour une majorité d’entre nous c’est un travail à mener (définir les bons contrats, identifier les services à exposer, prévoir de l’extension, adapter les outils aux usages des équipes, etc…). Si vous avez déjà un ensemble de services exposés par API au travers d’un point d’entrée unique (bien souvent une API Gateway), alors vous avez déjà acquis l’expérience pour avoir une vision produit de vos services, définir une organisation pour porter ces services et surtout acculturer et communiquer avec vos équipes pour l’usage et l’évolution de ce premier layer de votre plateforme.

Ensuite, on peut se poser la question de monter une IHM (Interface Homme Machine) pour améliorer la DevX (developer experience). Encore une étape pour faire grandir votre SI avec des questions comme:

- Ai-je un Design System pour accélérer sa mise en place ?

De nombreux Design Systems existent en opensource et peuvent être des accélérateurs avant même de construire le vôtre.

- Quelle structure d’équipe pour ce type de projet ?

Un product owner (celui de votre plateforme), 2 à 3 développeurs est un bon début pour monter ce produit.

- Comment mesurer la satisfaction et l’amélioration de la DevX ?

On évite de se lancer à corps perdu dans les métriques DORA dès le début (de nombreux REX en parlent). On peut commencer KISS (Keep It Simple and Stupid) avec le Squad Health Check de Spotify. On rencontre les équipes une fois par mois par exemple (pas trop souvent) et on leur demande leurs pain points concernant la Plateforme, leurs besoins, etc…

Créer une plateforme sans jamais échanger avec les équipes qui l'utilisent, sans leur proposer d’y participer (contribution interne, ouverture des dépôts de code) est un échec assuré. Profitez de vos équipes d’expertise technique (DevEx team, enabler team, coach interne) pour évangéliser les équipes à l’usage de votre Plateforme.

Eat your own food

Encore merci Mirakl pour cette citation qui est forte en sens. Il est important que vos équipes en charge de la plateforme soient les premières à s’en servir. Ils sont les mieux placés pour critiquer les produits proposés. Et on en revient à l’idée de l’inner sourcing avec la facilitation des évolutions par la contribution interne sur les bases de vos standards à vous. Votre plateforme reflète vos standards techniques.

L’expérimentation ne s’arrête jamais

Il ne faut pas craindre les échecs car ils sont toujours instructifs et la courbe d’apprentissage de la Plateformisation n’est pas linéaire. La Plateformisation est un excellent moyen d'expérimenter au sein de votre SI de nouvelles méthodologies, pratiques (ex: mise en place de feature flipping, rollout gateway, fine-tuning kafka), outils etc …

Vigilance sur l’usage de l’IA

Mais alors, le big boss final de la plateforme, c’est la mise en place d’un chatbot sur notre plateforme ou d’un agent de Plateformisation ? La réponse est claire et concise: NON.

On en revient à notre KISS, mais il est impératif de savoir faire une Plateforme avec votre vision et qui apporte de la valeur à vos équipes avant de vouloir l’enrichir avec de l’IA. On n’investit pas sur un agent IA plateforme avant même d’avoir créé sa plateforme. La plateforme se veut être un accélérateur fournissant un ensemble de guidelines, golden path, documentation avant tout. Il ne doit en aucun cas être un enjeu pour faire de l’IA. L’IA peut enrichir votre produit si vous êtes mature sur le sujet et des speakers ont indiqué se lancer sur ce sujet avec des use cases identifiés chez eux.

Comme disait Kelsey Hightower lors de la Keynote, si c’est pour faire un agent IA qui reset votre mot de passe, alors qu’un simple clique sur un reset est possible et que derrière cela vous demande une usine à gaz pour rattraper l’aspect non déterministe de l’IA, alors vous allez dans le mur.

Un alignement existe tout de même sur l’idée d’utiliser l’IA afin d'accélérer l'accès à de la documentation et simplifier la rédaction de documentation. C’est là où est la force de l’IA (et surtout du NLP), grâce à elle, il est possible de répondre rapidement aux besoins d’un développeur concernant la plateforme sur la base d’un agent conversationnel. Mais soyez conscient qu’il faut garder un système de débrayage avec des équipes de supports accessibles par divers canaux (ticketing via Jira, thread via Slack ou Teams, etc…).

Un aperçu de nos conférences préférées

Pour ceux d’entre vous qui souhaiteraient avoir un petit résumé des conférences que nous sommes allés voir, nous y consacrons cette section.

Platform Engineering à but non lucratif : leçons des Restos du Cœur - Julien Briault - Deezer

Julien Briault est un des speakers ayant été présent sur de nombreuses conférences en France en cette année 2025, nous avions déjà pu le voir présenter son magnifique sujet à des conférences comme Touraine Tech en février de cette année.

Ce premier talk de la journée a été une leçon d’humilité pour nous face à l’implication de Julien Briault, SRE chez Deezer mais aussi bénévole chez les Restos du Coeur. Julien est venu présenter son projet Cloud du Coeur, le Cloud privé des Restos du Coeur qu’il met en place depuis 4 ans afin de permettre à l’association et ses 78 000 bénévoles d’accéder aux outils numériques indispensables pour assurer leur mission tout en permettant à l’association d’économiser de précieuses ressources financières afin de fournir plus de repas au plus démunis. Un très beau projet qui allie technologie et social, merci Julien pour ce talk et bravo à toute ton équipe.

Platform as a product: Il faut savoir (parfois) réinventer la roue - Romain Broussard - Mirakl

Dans cette présentation, Romain Broussard, VP Platform Engineering (un intitulé de poste pas commun en France) chez Mirakl (éditeur de logiciel français) nous présente l’approche qu'il a eu lors de la mise en place de son équipe Plateforme et pose notamment l’accent sur l’approche produit qu'il faut avoir dans cette situation. En effet, de nombreuses entreprises font l’erreur de ne se concentrer que sur l’aspect technique du Platform Engineering sans aborder les vrais problèmes des structures. L’équipe Plateforme de Mirakl a mis en place une portail interne de développement mais Romain nous met en garde: nous pouvons avoir tendance à vouloir mettre en place un IdP(Internal Development Portal) directement en utilisant des projets comme Backstage de Spotify par exemple mais ceux-ci sont très complexes à mettre en place et il est préférable de d’abord exposer les services que l’on souhaite via des API par exemple, les mettre à disposition des développeurs avant de vouloir forcément une interface graphique. Si je devais retenir 2 leçons de cette conférence très intéressante : APIser d’abord et être soi même client de sa Plateforme pour pouvoir l’améliorer.

Construire une Plateforme d’ingénierie dans un groupe en pleine transformation : retour d’expérience - Florian Gasnier, Michaël Fery - Meilleurtaux

Chez Meilleurtaux, acteur du courtage en placement, assurance et crédit, l’hétérogénéité des équipes et l’absence de standards Dev, Sec et Ops freinaient l’innovation. Pour y remédier, l’entreprise a créé une équipe plateforme from scratch, combinant prestataires et recrutements internes, et impliquant l’ensemble des équipes infra, Ops, Sec et Dev.

Chaque squad dispose d’un champion DevSecOps, un Golden Path guide les développeurs, et l’architecture Hub & Spoke sécurise les environnements via des Landing Zones. L’objectif : réduire le Time to Cloud tout en garantissant sécurité et qualité.

Les bénéfices sont tangibles : autonomie accrue, déploiements plus rapides et sécurisés, meilleure visibilité sur les coûts et accès aux nouvelles fonctionnalités. Les défis restent la résistance au changement et la dette technique héritée.

Pour l’avenir, Meilleurtaux prévoit extension vers le cloud et la data, sandbox d’expérimentation, standardisation et suivi des métriques DORA et FinOps, tout en continuant l’onboarding de nouvelles squads.

Cloud Pi Native : Le Platform Engineering construit en OpenSource pour les ministères publics - Akram Blouza, Brice Trinel, Mathieu Laude - Ministère de l’intérieur

Conçue au sein du ministère de l’Intérieur, Cloud Pi Native illustre la montée en puissance du Platform Engineering dans le secteur public. Née d’un simple besoin de simplifier le déploiement d’applications, la Plateforme est devenue un produit stratégique, capable d’héberger des projets critiques tels que le Système d’Immatriculation des Véhicules (SIV) ou des applications interministérielles (Intérieur, Armées, Justice).

Dans la continuité de la stratégie cloud de l’État (2021), Cloud Pi Native s’inscrit dans une logique de souveraineté numérique et de maîtrise des infrastructures. Elle repose uniquement sur des briques open source et s’intègre dans l’écosystème des clouds souverains internes (Cloud Pi, Nubo) et des clouds de confiance (S3NS, Scaleway).L’objectif : conjuguer agilité, sécurité et indépendance tout en respectant les exigences réglementaires et les niveaux de confidentialité (jusqu’au niveau Diffusion Restreinte).

Cloud Pi Native offre un ensemble de services pour accélérer le time-to-market, mutualiser les ressources et améliorer la satisfaction des utilisateurs. Selon le degré d’intégration, les équipes ministérielles peuvent déployer leurs applications plus rapidement et en toute autonomie, tout en conservant un haut niveau de gouvernance et de sécurité.

Les prochaines évolutions incluent :

- Un catalogue de services (“Golden Path”) pour guider les équipes projets.

- Le soutien aux projets d’intelligence artificielle (gestion de GPU).

- Des plugins spécialisés, comme OpenCDS pour l’automatisation DNS.

Avec déjà 30 projets en production et plus de 100 agents formés, Cloud Pi Native s’impose comme un levier de modernisation et un vecteur de souveraineté numérique.Abstraction, standardisation, self-service, observabilité et sécurité by design : cette Plateforme open source incarne une nouvelle génération d’infrastructures publiques, pensées pour l’efficacité et la confiance.

“Platform Engineering is not about saving money, it is about making money" : Vers une Plateforme interne rentable chez Bpifrance - Hela Ben Farhat - BPI France

Hela Ben Farhat, Product Manager chez BPIfrance, aborde un sujet incontournable lorsqu’on met en place une équipe plateforme, c’est sa rentabilité par rapport aux équipes métier. Chez Bpifrance Digital, le Platform Engineering est désormais perçu comme un levier économique majeur, surpassant le statut de simple centre de coût. S'inspirant de l'impact de la machine à laver sur l'économie du 20e siècle, qui a libéré du temps pour l'innovation, la plateforme a pour mission de libérer les développeurs pour l'accélération et la créativité. Architecturalement, la plateforme est le cœur numérique, positionné entre les fondations (infrastructure Cloud, services internes) et les Produits Digitaux Métiers (parcours clients, demandes de financement). Conçue pour être générique, réutilisable et exposée via API, elle remplit une double fonction: elle est une couche d'abstraction masquant la complexité des fondations, et une couche d'accélération pour les équipes de développement.

Pour prouver cette valeur stratégique et répondre aux doutes initiaux des décideurs, Bpifrance s'appuie sur le calcul du ROI. Actuellement, la Plateforme affiche une rentabilité de 300 %, soit 3 € gagnés pour chaque euro investi. L'ambition est d'atteindre 5 € pour 1 € d’ici deux ans. Ce gain se décompose en trois familles : les économies de réutilisation, les gains de productivité, et les gains business (réduisant le time-to-market pour certains produits d’un an à trois mois). Au-delà de ces métriques quantifiables, la démarche intègre l'impact des gains invisibles, tels que la fidélisation client et l'amélioration de l’expérience développeur, qui ne figurent pas dans les calculs mais renforcent la performance globale de l’entreprise.

La pérennisation de ces bénéfices repose sur trois piliers fondamentaux. Le premier est le maintien d'un modèle économique lisible ; le second est une approche produit proactive qui se concentre sur le consommateur (le développeur) via le continuous discovery, visant à abandonner la "feature factory" pour prioriser les sujets alignés sur les enjeux business. Le troisième pilier est l’excellence opérationnelle, essentielle pour garantir la robustesse, la performance et la sécurité de la Plateforme.

Malgré ces succès, des défis persistent, notamment la nécessité d'une transformation culturelle vers un état d’esprit "produit" au sein des équipes, et la fiabilisation des mesures (acceptant l'imprécision des gains de productivité). À l'avenir, Bpifrance mise sur l'intégration de l'IA et des Plateformes "Agentic" pour orchestrer des agents, automatiser des chaînes de valeur entières et démultiplier l'innovation.

Conclusion

Cette journée à la PlatformCon aura été riche en informations et retours d’expériences. Nous avons déjà hâte d'assister à la prochaine édition.

Une journée au salon de la data et de l'IA de Nantes 2025 22 Oct 3:44 AM (3 days ago)

Mardi 16 septembre dernier, notre équipe Ippon était de retour pour les 10 ans du Salon de la Data et de L’IA de Nantes. Cet événement phare de la place nantaise nous permet de nous informer sur les dernières tendances et de renforcer nos liens avec la communauté tech.

Voici un résumé de quelques conférences auxquelles nous avons assisté.

Datawalk : voyage aux sources de la donnée !

Chose étonnante, Zazie Casimir-Favrot et Matthieu Chatry nous ont donné rendez-vous non pas dans une salle, mais sur l'esplanade de la Cité des Congrès. Au programme de cet atelier : une promenade dans le quartier.

La Datawalk, ou promenade de données, est un concept venu de Belgique. Il s'agit d'une visite guidée qui vise à nous faire (re)découvrir le mobilier urbain devenu invisible dans notre quotidien, mais dont la composante numérique améliore notre vie de tous les jours.

Le premier arrêt nous a conduits devant une station de vélos en libre-service Naolib. Un employé de JCDecaux, la société exploitante, nous a expliqué son fonctionnement et les données collectées. Ils sont capables de savoir si un vélo est amarré à une station ou s'il est en cours d'utilisation. Cela leur permet de connaître la fréquentation des stations pour optimiser la redistribution des vélos, améliorer le maillage des stations et rendre des comptes à la Métropole. Mais n'ayez crainte, les vélos ne sont pas géolocalisés et JCDecaux prend la RGPD au sérieux : les trajets non facturés (d'une durée inférieure à 30 minutes) sont anonymisés, et ceux qui sont facturés sont purgés au bout de 3 ans.

La balade nous a ensuite menés devant un guichet automatique de banque (GAB) du CIC, où une employée du groupe Société Générale nous a livré quelques anecdotes. Une employée de la Société Générale devant un CIC, n'y a-t-il pas là un problème ? Pas quand on sait que les GAB des banques BNP Paribas, Crédit Mutuel, CIC et Société Générale seront tous regroupés sous la marque Cash Services.

Prochain arrêt : une station d'autopartage Marguerite. Ces voitures sont truffées de capteurs et, à la différence des vélos, elles sont géolocalisées, mais pas en temps réel.

Le quatrième arrêt nous a conduits dans une pharmacie. La pharmacienne nous a fait une démonstration de son robot préparateur. En plus de préparer les commandes, cette énorme machine, constituée d'un grand couloir bordé de deux étagères, range et indexe automatiquement les médicaments. Ainsi, les médicaments souvent prescrits ensemble sont colocalisés pour optimiser les déplacements. De plus, il gère seul les dates de péremption afin de limiter les pertes.

Nous avons terminé cette DataWalk par une touche culturelle, devant le Grenier du Siècle. Ce lieu est une gigantesque capsule temporelle où les Nantais ont déposé des objets en 1999, à destination de leurs descendants de 2100.

Cet atelier était une bouffée d’air (pur ?) parmi toutes les conférences sur l’IA générative et ses agents.

Shadow AI: Le paradoxe de la Reine rouge

Dans ce quickie Angéline Perennes et Mourad Bouallak nous parlent de l’utilisation de l’IA générative en entreprise.

Le «Shadow AI» désigne l’utilisation de l’intelligence artificielle en dehors du cadre autorisé ou défini par l’entreprise. Un phénomène de plus en plus fréquent, porté par la curiosité, le besoin de productivité et l’accessibilité des outils d’IA générative.

Ce constat fait écho au paradoxe de la Reine Rouge, tiré d’Alice au pays des merveilles : dans un monde où tout évolue très vite, rester immobile revient à reculer. Pour les entreprises, interdire purement et simplement l’usage de l’IA reviendrait à se mettre en retrait, au risque d’être dépassées par les concurrents.

Il devient donc essentiel de proposer un cadre clair, qui permette de profiter des avantages de l’IA (gain de temps, automatisation, assistance à la création, etc.) tout en limitant les risques. Ces risques sont bien réels : près d’un prompt sur douze contient des données sensibles, exposant les organisations à des violations du RGPD ou à des pertes de propriété intellectuelle.

Refuser l’usage de l’IA sans alternative crée souvent de la frustration chez les employés, qui chercheront à contourner les interdictions. La réponse n’est donc pas l’interdiction, mais la formation.

Des programmes comme Objectif IA (OpenClassrooms) permettent de sensibiliser les collaborateurs à un usage responsable et maîtrisé de ces outils, tout en accompagnant l’évolution rapide des pratiques professionnelles.

Table Ronde : L’IA au féminin en 2025

En début d’après-midi s’est tenue une table ronde d’une trentaine de minutes sur un sujet encore peu abordé lors du salon : la place des femmes dans le domaine de la data et de l’IA. Trois intervenantes aux parcours inspirants ont échangé sur leurs expériences, leurs visions du secteur et les défis, techniques comme moraux, auxquels elles ont fait et font toujours face en tant que femmes dans la tech.

Andrea Leylavergne, data scientist et directrice de l’association Women in Big Data, a ouvert le débat. Engagée depuis plusieurs années dans la promotion des carrières féminines dans la tech, elle milite pour une meilleure visibilité des femmes dans la data. Pour elle, la représentation est le premier levier de transformation pour que les choses évoluent dans le bon sens. Son action au sein de l’association vise justement à présenter des modèles auxquels les jeunes femmes peuvent s’identifier, en mettant en avant des parcours variés et ambitieux.

Parmi ces modèles, certaines femmes se montrent plutôt optimistes quant à l’avenir du féminin dans la tech, convaincues que les choses progressent. C’est le cas de Camille Marini, docteure en océanographie dynamique et aujourd’hui Director of Machine Learning chez Sonos. Pour elle, l’enjeu est avant tout d’encourager les étudiantes à se faire confiance et à oser les carrières techniques.

Plus tranchée dans ses propos, Fransceca Iannuzzi, Head of Data chez iAdvize, a évoqué sans détour les obstacles quotidiens rencontrés dans un milieu encore largement masculin. Elle raconte même, avec une pointe d’ironie, un épisode de mansplaining qu’elle a vécu à peine trente minutes avant le début de la table ronde. Il s’agit de ces situations dans lesquelles un homme explique à une femme quelque chose qu’elle sait déjà, voire dont elle est experte, souvent sur un ton paternaliste ou condescendant.

De ces échanges, un message clair ressort : les femmes ont toute leur place dans la data et l’IA, mais la bataille n’est pas que technique. La compétence n’a pas de genre, mais la confiance, elle, se construit. Comme le souligne Fransceca, il faut « redistribuer les cartes dès la crèche » : donner aux petites filles des modèles inspirants et apprendre aux petits garçons à écouter, à collaborer, à co-construire. Le débat s’est conclu sur une note d’espoir pour tous : quel que soit le genre ou le milieu social, l’essentiel est d’oser et d’y croire.

Lien vers les articles des années passées:

Une journée au salon de la data 2022

Une journée au salon de la data et de l'IA 2023

Une journée au salon de la data et de l'IA 2024

L’IA au cœur de la Data Cloud : Révolution et Simplicité au Snowflake World Tour 2025 20 Oct 4:05 AM (5 days ago)

Keynote : L’IA, fil rouge d’une plateforme en mouvement

L’édition 2025 du Snowflake World Tour a placé l’intelligence artificielle au centre de toutes les discussions. Mais au-delà du simple buzzword, c’est une vision stratégique et opérationnelle qui s’est dessinée, une déclaration d'une ambition dévorante : transformer Snowflake d'une Data Cloud Platform en une "AI Data Cloud Platform". Cette refonte se concrétise par une plateforme unifiée, conçue pour simplifier radicalement l’accès à la data et à l’IA, tout en renforçant la confiance dans les résultats. La keynote, animée par des figures telles que Cecil Bove, Regional Vice President de Snowflake et Sridhar Ramaswamy, CEO de Snowflake, a posé les fondations d’un écosystème où la complexité technique s’efface au profit de la puissance et de l’accessibilité.

La simplicité a été érigée en différenciateur majeur face à la concurrence. Là où d’autres acteurs multiplient les fonctionnalités au risque de fragmenter l’expérience utilisateur, Snowflake mise sur une intégration native et fluide entre le cloud, la data et l’IA. Cette philosophie a été illustrée par un partenariat stratégique mis en scène avec le CEO d’Azure, Satya Nadella. Si les détails opérationnels de cette collaboration restent à préciser, elle symbolise une alliance forte dans un paysage cloud où les frontières, entre partenariat et concurrence, deviennent poreuses.

Une démonstration captivante est venue d’Hugo Barret, Solution Engineering Manager chez Snowflake, qui a présenté les nouvelles fonctionnalités avec un leitmotiv : faire de Snowflake une plateforme autonome et fiable. La gouvernance de l’IA a été placée au premier plan, comme un pilier essentiel pour garantir la transparence et la fiabilité des modèles génératifs. Pour soutenir cette ambition, la couche sémantique a été présentée comme le socle de l’IA générative, structurant les données de manière intelligible et ouvrant la voie à des outils comme Horizon Agent, dédiés aux Data Stewards. L’annonce d’un format généralisé, Open Semantic Interchange marque concrètement les intentions de Snowflake.

L’annonce la plus marquante restera sans doute Snowflake Intelligence : un chatbot métier capable d’interroger les bases de données en langage naturel, sans requête SQL. Une révolution pour les utilisateurs non techniques, qui pourront désormais exploiter la data via de simples prompts. Cette démonstration, enrichie par l’intervention d’Elizabeth den Dulk, Enterprise Solution Engineer chez Snowflake, a montré comment l’IA s’intègre désormais directement dans les pipelines, permettant de traiter aussi bien des données structurées que non structurées, comme des transcriptions audio ou des analyses d’images.

La keynote s'est conclue par un retour d'expérience concret de TF1, représenté par son Chief Data Officer, François-Xavier Pierrel. Il a détaillé le virage data du groupe pour soutenir sa transition vers le streaming (TF1+), gérant des volumes de données importants pour personnaliser l'expérience de millions d'utilisateurs. Son mot de la fin, à la fois drôle et décalé, a offert un moment de légèreté : « Ce n’est pas grave de rater, il faut juste que cela arrive une fois ». Une conclusion qui, à contre-courant du "fail fast" habituel, a rappelé avec humour que l'innovation, si elle comporte des risques, doit avant tout mener à un succès durable.

Conférences : Retours d’expérience et visions d’avenir

Au-delà de la keynote, plusieurs retours d’expérience ont illustré la maturité croissante de la plateforme.

L’intervention de Saint Jean, groupe agroalimentaire historique, a illustré comment une migration vers Snowflake, facilitée par l’outil Coalesce et son interface no-code, a permis de transformer une culture data encore émergente en une véritable capacité industrielle. En passant de plus de 30 rapports statiques à seulement deux rapports dynamiques, l’entreprise a non seulement regagné la confiance des métiers, mais aussi accéléré son time-to-value. Le choix de Coalesce, pour son interface visuelle et son intégration native, a été crucial pour une équipe initialement dépourvue de data engineers experts.

Le cas Stellantis a, quant à lui, impressionné par son ampleur. Face à un héritage technique complexe – 16 plateformes data distinctes – le constructeur automobile a su unifier son paysage autour de Snowflake, en s’appuyant sur une stack moderne intégrant dltHub et dbt. Leur framework open source, couplé à un monitoring maison basé sur Elastic, leur permet de gérer des milliers de pipelines et une centaine de développeurs avec une rigueur remarquable. L’utilisation des Data Metric Functions (DMF) de Snowflake pour piloter la qualité des données à grande échelle témoigne d’une vision résolument industrielle.

Enfin, la conférence dédiée à l’interopérabilité avec le format Apache Iceberg a confirmé la volonté d’ouverture de Snowflake et sa stratégie pour éviter le vendor lock-in. Grâce à des innovations comme l’intégration de catalogues externes (tel que Polaris, le catalogue open source de Snowflake) et la possibilité d’écrire directement dans des tables Iceberg, la plateforme permet de séparer le stockage des données du moteur de calcul, tout en conservant la scalabilité et la performance du compute Snowflake.

Conclusion : Vers une plateforme data auto-suffisante ?

Cette édition du Snowflake World Tour a confirmé une ambition claire : faire de Snowflake une plateforme tout-en-un, où l’IA, la data et le cloud s’intègrent de manière fluide et accessible. Les annonces vont toutes dans le même sens : réduire la complexité pour les utilisateurs métiers, automatiser les tâches techniques et intégrer l’IA non comme une couche supplémentaire, mais comme un levier de productivité native.

Cette évolution interroge néanmoins les rôles traditionnels. L’émergence d’outils comme Snowflake Intelligence et la couche sémantique pourrait bien redistribuer les cartes, faisant évoluer le métier de Data Analyst vers des profils plus spécialisés, comme le Data Steward, garant de la qualité et de la cohérence sémantique.

Si la vision de Snowflake se concrétise, la plateforme pourrait bien s’imposer comme la référence incontournable pour les entreprises cherchant à unifier leur stack data, sans pour autant renoncer à la puissance et à l’expertise technique offerte par des écosystèmes ouverts et interopérables.

GraphRAG - Augmenter la puissance de votre RAG avec L’intégration Neo4J 17 Oct 12:51 AM (8 days ago)

Introduction & Motivation

Cela fait plusieurs semaines que j’ai booké une session “lab / discovery” sur le sujet des RAG mais abordé par le prisme d’une technologie particulière : Neo4J.

Neo4J, c’est le leader de la base graphe. C'est un outil particulièrement adapté aux nouveaux enjeux technologiques dans lesquels on manipule des données pas forcément structurées. Ayant déjà utilisé Neo4J plusieurs années auparavant, je me souvenais d’un outil abouti et vraiment performant. Et c’est donc tout naturellement que j’ai voulu participer à ce Lab pour voir où se situait Neo4J dans la galaxie des outils qui gravitent dans l'écosystème LLM / IA.

En voici une synthèse.

Présentation & Déploiement moteur Neo4J

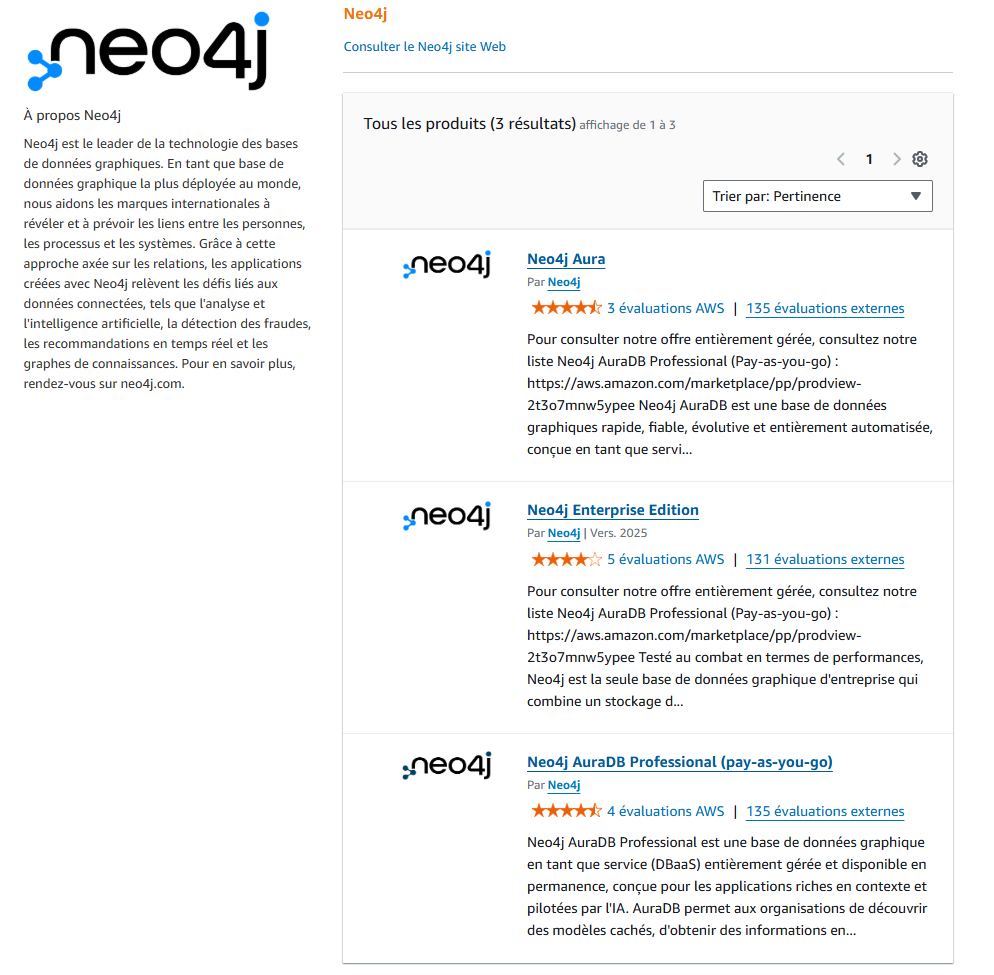

Après la classique présentation de la société Neo4J, du principe des bases graphes, et pourquoi c’est bien de l’utiliser, on nous présente “Neo4j Aura Professionnal” qui est la solution SaaS de Neo4J et qui se décline en plusieurs briques :

- Neo4J Aura DB qui est le moteur de la base graphe

- Neo4j Aura Graph Analytics

Evidemment, Neo4j Aura Professionnal est indépendant du cloudProvider : on va donc pouvoir l’installer sur les grands fournisseurs de cloud, et ce, en quelques clics. Mais il est également possible de faire du self managed.

Le Lab (et tout ce qui est nécessaire) est accessible depuis le github de Neo4J :

https://github.com/neo4j-partners/hands-on-lab-neo4j-and-bedrock/tree/main

La formation se déroulant dans les locaux d’AWS, il était normal que le choix du cloudProvider soit AWS. Les premières étapes consistent à déployer sur un compte AWS de “bac à sable” une instance du moteur neo4j. Comme c’est une solution SaaS, complètement intégrée dans l’AWS Marketplace, cela se fait très facilement :

Notez qu’il faudra sélectionner à minima “Neo4J AuraDB Professionnal (pay as you go)” pour bénéficier des fonctionnalités IA.

Notez également que le système de Licensing Neo4J n’autorise pas à déployer en production la version communautaire, qui est de toute façon bridée.

Pour vos productions, il faudra sélectionner “Neo4J Enterprise Edition”.

Une fois déployée, nous nous connectons sur l’interface via la console d’administration :

Puis nous enchaînons sur une étape de création de la base graphe à l’intérieur de notre instance. Et enfin, nous la remplissons.

L’ensemble de ces étapes sont très bien décrites dans le repo github.

L’IA rentre en jeu

Un SA AWS nous présente le service AWS BedRock et les différents modèles qu’il supporte.

Ce n’est pas l’objet de ce billet mais voici quelques notes :

Amazon BedRock est une surcouche au-dessus des modèles que vous aurez sélectionnés. Je citerai juste ce que le SA AWS nous a conseillé : “Dans votre phase exploratoire, n’hésitez pas à tester les différents modèles : entre pertinence et coûts associés, trouvez le modèle qui correspond le plus à vos besoins.”

Ici, nous utilisons Anthropic et le modèle claude-sonnet-4-20250514-v1 comme LLM.

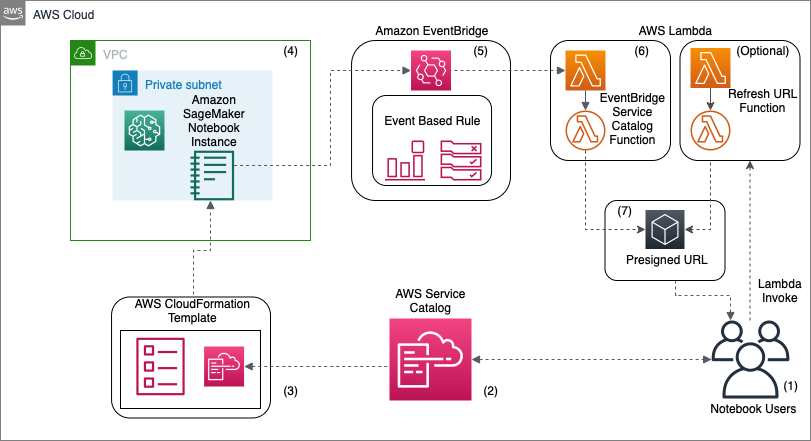

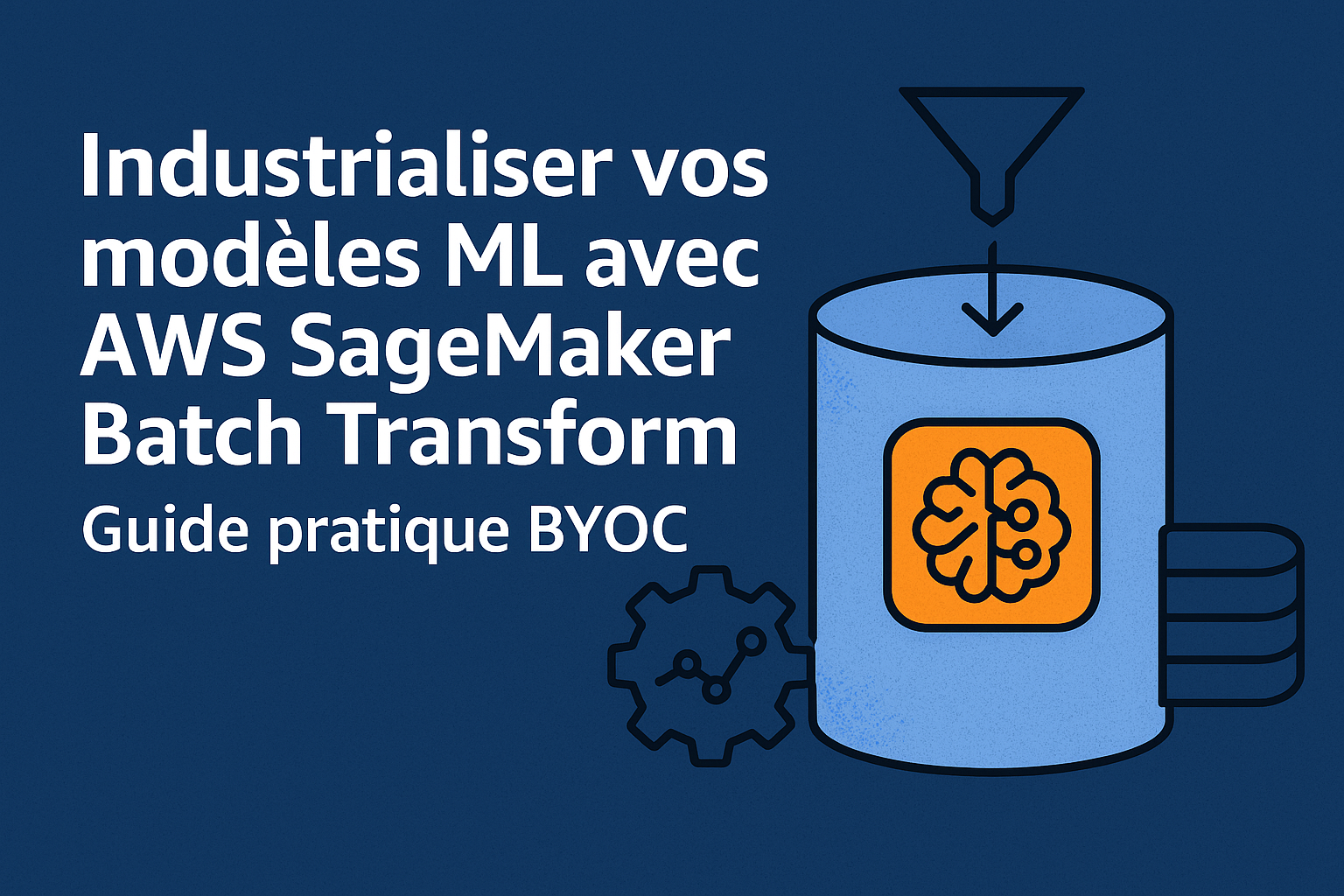

Pour terminer notre environnement, nous déployons, côté AWS, un domaine “SageMaker” pour dérouler les notebooks Jupyter fournis dans le repository git.

Le 1er notebook Jupyter : chargement des données

Voici les grandes lignes du notebook :

Objectif : Utiliser le LLM claude sonnet pour parser automatiquement des données semi-structurées (mélange de texte et XML) issues d’un fichier initial.

Le notebook permet de montrer comment générer des requêtes Cypher (langage natif neo4j pour interagir avec la base graphe) pour charger les données extraites dans notre base neo4J. Notez qu’à aucun moment on écrit un parser spécifique : c’est le LLM qui se charge de tout.

Le notebook utilise des prompts spécifiques pour guider le LLM dans l’extraction des informations. Dans notre cas particulier, nous manipulons des “managers” et des informations sur des “investments”. Voici les prompts (que vous pouvez retrouver directement dans le notebook).

Prompt pour guider le LLM pour extraire les informations “manager”

mgr_info_tpl = """From the text below, extract the following as json. Do not miss any of these information.

* The tags mentioned below may or may not namespaced. So extract accordingly. Eg: <ns1:tag> is equal to <tag>

* "managerName" - The name from the <name> tag under <filingManager> tag

* "street1" - The manager's street1 address from the <com:street1> tag under <address> tag

* "street2" - The manager's street2 address from the <com:street2> tag under <address> tag

* "city" - The manager's city address from the <com:city> tag under <address> tag

* "stateOrCounty" - The manager's stateOrCounty address from the <com:stateOrCountry> tag under <address> tag

* "zipCode" - The manager's zipCode from the <com:zipCode> tag under <address> tag

* "reportCalendarOrQuarter" - The reportCalendarOrQuarter from the <reportCalendarOrQuarter> tag under <address> tag

* Just return me the JSON enclosed by 3 backticks. No other text in the response

Text:

$ctext

"""

Prompt pour guider le LLM pour récupérer les infos “investments”

filing_info_tpl = """The text below contains a list of investments. Each instance of <infoTable> tag represents a unique investment.

For each investment, please extract the below variables into json then combine into a list enclosed by 3 backticks. Please use the quoted names below while doing this

* "cusip" - The cusip from the <cusip> tag under <infoTable> tag

* "companyName" - The name under the <nameOfIssuer> tag.

* "value" - The value from the <value> tag under <infoTable> tag. Return as a number.

* "shares" - The sshPrnamt from the <sshPrnamt> tag under <infoTable> tag. Return as a number.

* "sshPrnamtType" - The sshPrnamtType from the <sshPrnamtType> tag under <infoTable> tag

* "investmentDiscretion" - The investmentDiscretion from the <investmentDiscretion> tag under <infoTable> tag

* "votingSole" - The votingSole from the <votingSole> tag under <infoTable> tag

* "votingShared" - The votingShared from the <votingShared> tag under <infoTable> tag

* "votingNone" - The votingNone from the <votingNone> tag under <infoTable> tag

Output format:

* DO NOT output XML tags in the response. The output should be a valid JSON list enclosed by 3 backticks

Text:

$ctext

"""

La variable $ctext sera remplacée par chaque ligne récupérée du fichier initial.

Le notebook fournit des fonctions spécifiques permettant d’interagir avec le LLM, comme par exemple le moyen de découper (chunk) les données pour éviter de dépasser les limites de tokens du LLM.

Le LLM est utilisé pour générer des requêtes Cypher à partir des données extraites, afin de les charger dans Neo4j.

Conclusion

Même si ce n’est pas une révolution, on sent bien toute la puissance du LLM : à partir d’un fichier non structuré (le fichier de départ contient des données XML et des données en vrac), le LLM arrive à ne pas se perdre et à extraire les 2 listes d’informations relatives à des entités métier : le manager et le “investment”.

Mise en place d’une “fenêtre conversationnelle”

La session continue sur le lab 6 “ChatBot”. Il se base sur la librairie python “gradio” pour mettre en place cette fenêtre conversationnelle.

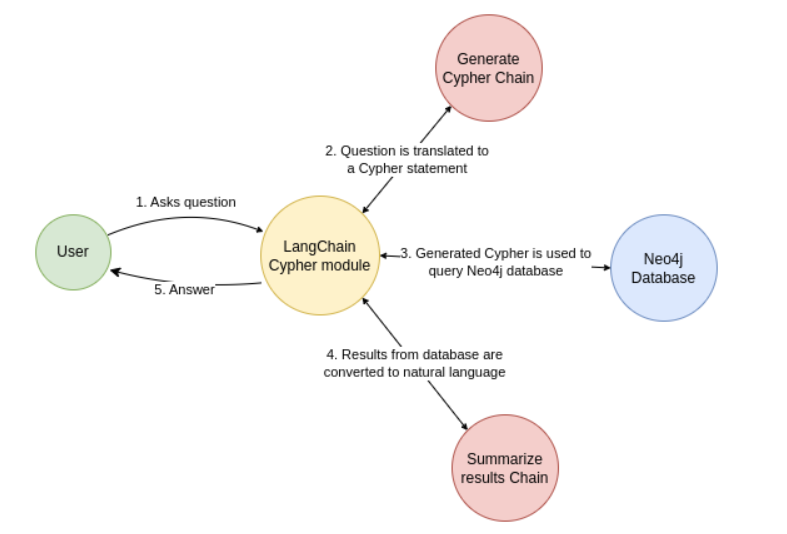

Le fonctionnement qui est proposé par ce nouveau notebook est le suivant :

- L’utilisateur pose une question en langage naturel.

- L’IA générative convertit cette question en requête Cypher (langage de requête pour Neo4j).

- La requête Cypher interroge la base Neo4j pour obtenir des faits contextuels.

- L’IA générative convertit la réponse de la base en langage naturel.

- La réponse est présentée à l’utilisateur.

Dans ce notebook, on nous présente l’avantage de l’utilisation de Neo4J. Sans précision particulière, une question du style : “Which managers own FAANG stocks?” ne permet pas d’avoir une réponse pertinente.

En effet, un modèle de langage (comme ceux utilisés dans les chatbots) peut reconnaître des termes courants comme FAANG (Facebook, Apple, Amazon, Netflix, Google ), mais il ne donnera que des réponses générales et limitées.

Or, dans un environnement professionnel, les questions portent souvent sur des données spécifiques : des noms de projets, des relations entre entités, ou des règles internes. Un LLM seul ne connaît pas ces détails. Neo4j résout ce problème en stockant ces informations dans un graphe de connaissances, où chaque élément est relié de manière structurée.

Grâce à LangChain, on peut alors :

- Traduire la question en une requête précise (en langage Cypher pour Neo4j).

- Interroger la base pour obtenir des réponses exactes et contextualisées.

- Restituer le résultat en langage naturel, comme le ferait un expert du domaine.

C’est cette combinaison — LLM + Neo4j — qui permet de passer d’une réponse vague à quelquechose de beaucoup plus pertinent pour notre contexte.

Voici le schéma présenté dans le notebook :

Pour permettre au LLM de traduire la question de l’utilisateur en “Cypher Chain”, encore une fois, nous allons fournir un “prompt” qui va le guider. Il est disponible dans le notebook et est plutôt assez gros. Ci-joint un extrait de ce prompt :

CYPHER_GENERATION_TEMPLATE = """You are an expert Neo4j Cypher translator who understands the question in english and convert to Cypher strictly based on the Neo4j Schema provided and following the instructions below:

<instructions>

* Use aliases to refer the node or relationship in the generated Cypher query

* Generate Cypher query compatible ONLY for Neo4j Version 5

* Do not use EXISTS, SIZE keywords in the cypher. Use alias when using the WITH keyword

* Use only Nodes and relationships mentioned in the schema

* Always enclose the Cypher output inside 3 backticks (```)

* Always do a case-insensitive and fuzzy search for any properties related search. Eg: to search for a Company name use `toLower(c.name) contains 'neo4j'`

* Use the relationship variable `o` to access the `shares` and `value` properties of the `OWNS` relationship when calculating the sums.

* Cypher is NOT SQL. So, do not mix and match the syntaxes

* Use the elementId() function instead of id() to compare node identifiers

</instructions>

Strictly use this Schema for Cypher generation:

<schema>

{schema}

</schema>

The samples below follow the instructions and the schema mentioned above. So, please follow the same when you generate the cypher:

<samples>

Human: Which fund manager owns most shares? What is the total portfolio value?

Assistant: ```MATCH (m:Manager) -[o:OWNS]-> (c:Company) RETURN m.managerName as manager, sum(distinct o.shares) as ownedShares, sum(o.value) as portfolioValue ORDER BY ownedShares DESC LIMIT 10```

Human: Which fund manager owns most companies? How many shares?

Assistant: ```MATCH (m:Manager) -[o:OWNS]-> (c:Company) RETURN m.managerName as manager, count(distinct c) as ownedCompanies, sum(distinct o.shares) as ownedShares ORDER BY ownedCompanies DESC LIMIT 10```

Human: What are the top 10 investments for Vanguard?

Assistant: ```MATCH (m:Manager) -[o:OWNS]-> (c:Company) WHERE toLower(m.managerName) contains "vanguard" RETURN c.companyName as Investment, sum(DISTINCT o.shares) as totalShares, sum(DISTINCT o.value) as investmentValue order by investmentValue desc limit 10```

Human: What other fund managers are investing in same companies as Vanguard?

Assistant: ```MATCH (m1:Manager) -[o1:OWNS]-> (c1:Company) <-[o2:OWNS]- (m2:Manager) WHERE toLower(m1.managerName) contains "vanguard" AND elementId(m1) <> elementId(m2) RETURN m2.managerName as manager, sum(DISTINCT o2.shares) as investedShares, sum(DISTINCT o2.value) as investmentValue ORDER BY investmentValue LIMIT 10```

Human: What are the top 10 investments for rempart?

Assistant: ```MATCH (m:Manager) -[o:OWNS]-> (c:Company) WHERE toLower(m.managerName) contains "rempart" RETURN c.companyName as Investment, sum(DISTINCT o.shares) as totalShares, sum(DISTINCT o.value) as investmentValue order by investmentValue desc limit 10```

...

Human: {question}

Assistant:

"""

Maintenant qu’on a guidé notre LLM avec suffisamment de contexte dans notre prompt, il nous reste plus qu’à exploiter la puissance de Neo4J avec notre LLM.

Le notebook montre comment utiliser LangChain pour "ancrer" le LLM avec Neo4j, c’est-à-dire :

- Lier le LLM à la structure du graphe (schéma, relations, propriétés).

- Générer des requêtes Cypher précises à partir des questions utilisateurs.

- Exécuter ces requêtes sur Neo4j et restituer les résultats.

LangChain agit comme un pont entre le LLM (générique) et Neo4j (spécifique).

Il permet de structurer les interactions pour obtenir des réponses précises et contextualisées.

L’utilisation de GraphCypherQAChain automatise la conversion question → Cypher → réponse, pil poil ce dont on a besoin pour un “chatbot métier”.

Si maintenant on repose notre question “Which managers own FAANG stocks?”, la réponse devient complètement pertinente.

Conclusion [point de vue neo4j]

Pourquoi "Ancrer" un LLM avec Neo4j ?

"Ancrer" un LLM (Large Language Model) avec Neo4j signifie connecter le modèle à une base de données de graphes pour améliorer ses réponses. Voici 3 raisons :

Gestion de Questions Complexes (Multi-Hop Knowledge Retrieval)

Les questions complexes nécessitent souvent de relier plusieurs informations entre elles (ex : "Quels gestionnaires de fonds basés à New York détiennent des actions dans des entreprises technologiques cotées après 2020, et qui ont un rendement supérieur à 10% ?").

Dans une base de données relationnelle classique, cela implique des jointures multiples, qui peuvent être lentes et difficiles à optimiser.

Solution avec Neo4j :

Neo4j stocke les relations entre les données (ex : Gestionnaire → DÉTIENT → Action → COTÉE_DANS → Secteur). Ces relations sont pré-calculées et optimisées avant même que la question ne soit posée.

Pour une question nécessitant 4 "sauts" (hops) (ex : Gestionnaire → Action → Entreprise → Secteur), Neo4j traverse ces relations instantanément, sans calculs lourds.

Résultat : Nous obtenons des réponses rapides et précises, même pour des questions complexes.

Fiabilité et Sécurité d’Entreprise

Neo4j permet de limiter l’accès aux données en fonction des permissions de l’utilisateur (ex : un chatbot ne verra que les données autorisées pour le rôle de l’utilisateur). C’est une fonctionnalité qui n’est pas accessible dans la version communautaire.

Performance

Neo4j est optimisé pour les requêtes complexes sur des graphes, avec une latence faible même avec un grand nombre d’utilisateurs simultanés. C’est idéal pour des applications comme un chatbot utilisé par des centaines d’utilisateurs en parallèle.

Ma Conclusion

À première vue, l’impact est indéniable : sans l’appui d’un LLM, l’extraction de données à partir de fichiers non structurés aurait été un défi de taille. L’envie d’ajouter une couche conversationnelle pour interroger ces données devient rapidement évidente. Le Lab, centré sur les atouts d’une base graphe comme Neo4j, met en lumière ces avantages. Une fois les données chargées dans Neo4j, la précision des réponses de l’agent s’en trouve décuplée.

Un aspect important qui n’est pas montré dans le Lab, est que Neo4j a intégré dès sa conception une approche pragmatique de la sécurité, notamment à travers la gestion de la visibilité des données. Par exemple, il est possible d’attribuer des niveaux de confidentialité (comme une échelle de C1 à C4, où C4 représente le niveau le plus restreint). Ainsi, selon les droits de l’utilisateur, la base graphe filtre automatiquement les informations accessibles : un profil autorisé uniquement pour le niveau C2 ignorera les nœuds classés C3 ou C4. Une fonctionnalité qui renforce la sécurité tout en restant transparente pour l’utilisateur.

Si les LLM sont impressionnants, ils ne remplacent pas l’expérience humaine. Leur efficacité dépend largement de la qualité des prompts qui les guident. Dans le cadre du Lab, ces prompts ont été soigneusement testés pour garantir des résultats pertinents. Cependant, en dehors de ce contexte, leur élaboration reste un exercice exploratoire, profondément lié au projet en cours, aux données et aux usecases. Impossible, donc, d’établir un guide universel pour rédiger des prompts efficaces.

Cette réalité rappelle les protocoles de recherche en laboratoire : en IT, comme en science, il est impératif de tester, d'ajuster et d'itérer, à la manière des laboratoires pharmaceutiques, jusqu'à obtenir la pertinence et l'efficacité souhaitées.

Durant cette semaine, j'ai pu rencontrer bon nombre de collègues et amis, jeunes étudiants et professionnels expérimentés, avec qui j'ai eu le plaisir d'échanger sur l'avenir de nos métiers dans l'IT, la place de l’IA qu’elle va prendre, et comment la “dompter”. Le temps que la frénésie autour de l’IA se stabilise, gageons que maîtriser le “prompt” soit le défi de demain, toute génération confondue.

Pour ceux qui sont dans le Sud de la France et qui souhaitent découvrir l'autre révolution en cours dans l'IA (i.e les MCP Servers), Venez nous rencontrer au meetup IA "Piloter votre infra AWS en langage naturel avec LangFuse le 23 Octobre pour une démonstration technique des capacités des MCP Servers.

Retour sur la Swift Connection 2025 14 Oct 11:07 PM (10 days ago)

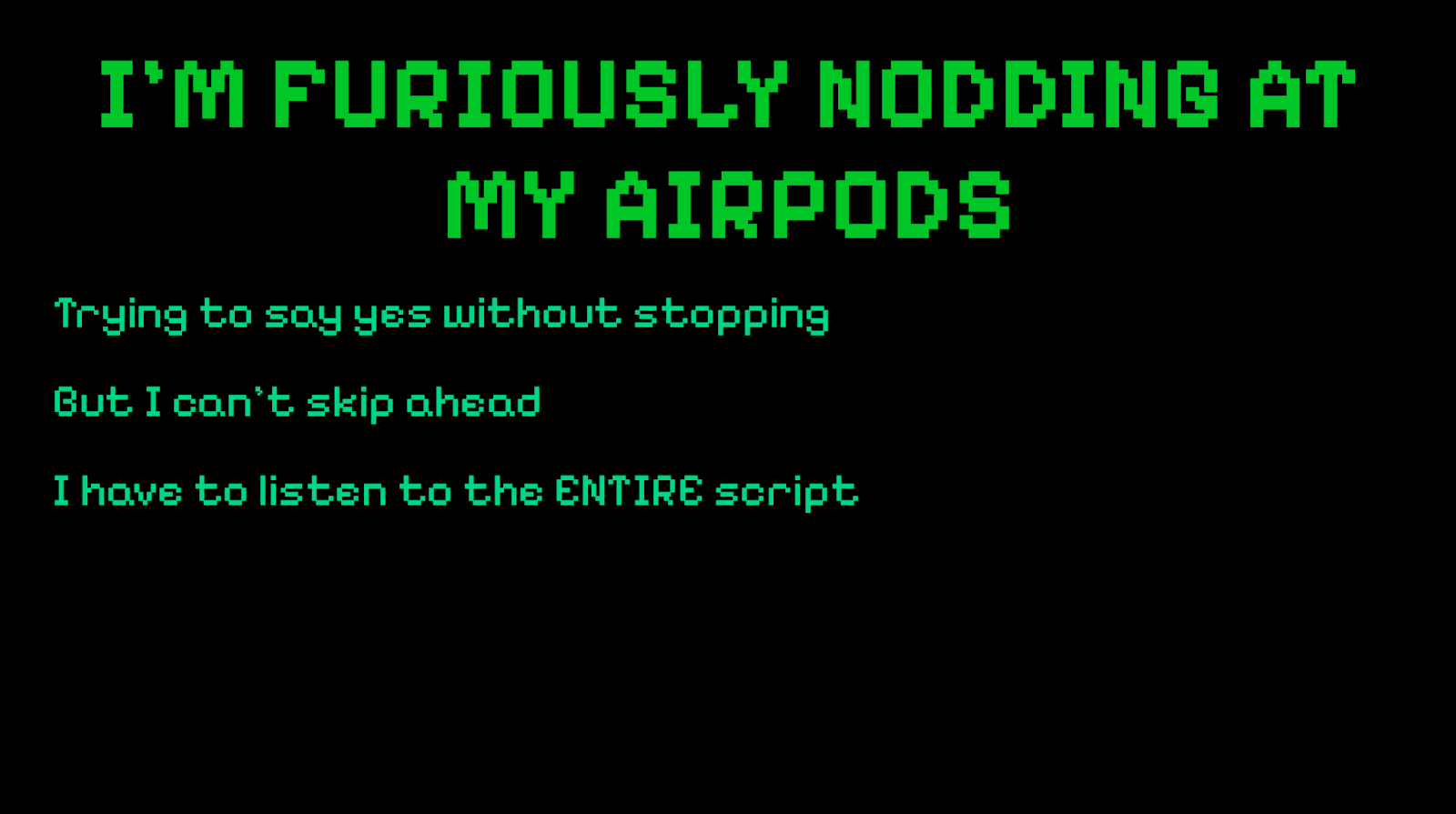

Retour au Théâtre de Paris : pour sa nouvelle édition, la Swift Connection a de nouveau transformé la scène en point de rencontre privilégié pour les passionnés de l’écosystème Apple. Durant ces deux journées, développeurs, designers et acteurs du numériques ont échangé autour des tendances qui redessinent le développement iOS — de l’IA aux stratégies de tests, en passant par les interfaces expérimentales comme Liquid Glass et les premières explorations autour du Vision Pro.

Présente sur place, notre équipe a assisté à plusieurs conférences marquantes et en partage ici les principaux enseignements. Entre retours d’expérience, réflexions prospectives et bonnes pratiques, cette édition a confirmé que la scène iOS continue d’évoluer vite, et dans toutes les directions à la fois.

Les interventions qui ont marqué !

1 - The Science of Habit-Forming Apps

- Présentateur-rice(s) : Tamia James

- Auteur du résumé : Dylan Le Hir

Résumé

Comprendre la différence entre les mécanismes de manipulation (dark patterns) et les mécanismes d’engagement sain (Hook Model) dans la conception d’applications.

En tant que junior, j’ai beaucoup apprécié la clarté avec laquelle Tamia James a expliqué le concept de dark pattern c’était un bon rappel, utile pour ancrer les pratiques. En revanche, la découverte du Hook Model de Nir Eyal (auteur du livre Hooked) a été une vraie révélation. Ce modèle m’aidera à concevoir des expériences plus engageantes et respectueuses pour les utilisateurs.

Tamia a illustré le Hook Model avec des exemples très parlants :

- DuoLingo et ses triggers redoutables : les notifications quotidiennes qui te rappellent de ne pas perdre ta série d’apprentissage, un petit geste de 3 minutes, mais une habitude bien ancrée.

- Instagram, pour la partie reward : chaque nouvelle publication apporte une dose de satisfaction et renforce l’envie de revenir.

Trois points clés à retenir :

1 - Le côté obscur de la force : Évitez les dark patterns. Ces pratiques qui piègent l’utilisateur, comme : le paiement obligatoire après installation, les abonnements qui se renouvellent automatiquement après la période d’essai ou encore les désabonnements volontairement compliqués (👀).

2 - “May the Force be with you” : Inspirez-vous du Hook Model de Nir Eyal, articulé autour de quatre étapes : Trigger (déclencheur), Action, Reward (récompense) et Investment (investissement). L’objectif : créer des habitudes positives et utiles, sans manipuler.

3 - Pensez avant tout à l’humain : La conception d’une application mobile doit servir les besoins réels des utilisateurs, pas exploiter leurs faiblesses.

Conclusion

Cette conférence m’a éclairé sur la manière dont se forment les habitudes chez les utilisateurs, un levier essentiel pour concevoir des expériences à la fois engageantes et responsables.

En intégrant ces notions, nous pouvons non seulement créer des parcours plus intuitifs, mais aussi mieux identifier les dérives du design persuasif, ces fameux dark patterns qu’il est si facile d’ignorer. D’ailleurs, Tamia n’en a qu'effleurer la surface : en dresser une typologie complète serait précieux pour affiner nos pratiques et affirmer nos choix éthiques en UX.

Ce que j’ai particulièrement apprécié, c’est la justesse du propos : un équilibre rare entre technologie et psychologie, servi avec clarté et pédagogie. Les exemples concrets d’applications mondialement connues ont rendu le sujet vivant et inspirant.

Une présentation qui donne envie d’aller plus loin, de questionner nos propres produits, nos réflexes de conception et la frontière parfois ténue entre influence et manipulation.

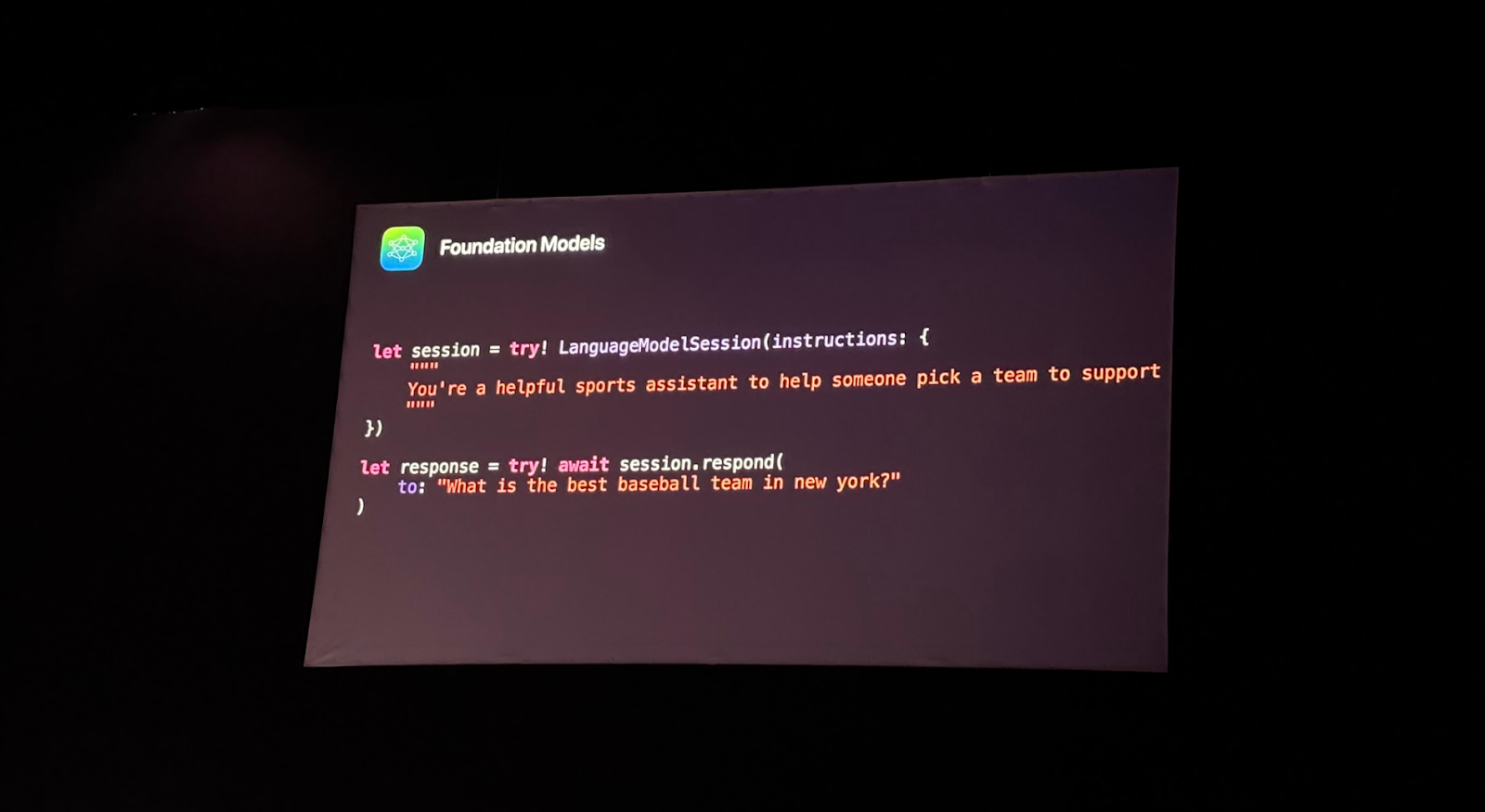

2 - Hello Foundation Models

- Présentateur-rice(s) : Alex Logan

- Auteur du résumé : Dylan Le Hir

Résumé

Alex Logan nous a présenté Foundation Models, le nouveau framework d’Apple dédié à l’IA générative intégrée à Apple Intelligence.

Ce framework permet d’ajouter dans vos apps iOS des capacités de :

- Résumé ou compréhension de texte,

- Affinage ou réécriture,

- Extraction d’entités (personnes, lieux, objets),

- Et même rédaction créative.

En une vingtaine de minutes, Alex nous a guidés pas à pas à travers la mise en œuvre du framework, du concept à la première implémentation.

Trois points clés à retenir :

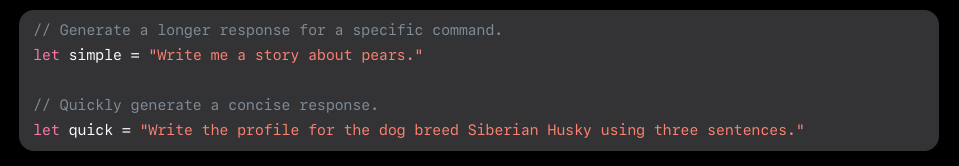

1 - Simplicité d’implémentation : En quelques lignes de code, vous pouvez interagir avec le modèle et obtenir des réponses générées en langage naturel. L’intégration se fait directement dans votre app via LanguageModelSession.

2 - Importance des instructions : Le modèle répond mieux et plus rapidement lorsqu’on lui fournit des instructions claires et des garde-fous. C’est ce qui permet d’orienter la génération et d’éviter des réponses imprécises ou trop longues.

3 - Annotation @Generable : En annotant vos structures ou enums avec @Generable, vous pouvez guider le modèle pour qu’il réponde dans un format Swift précis.

➤ Parfait pour les cas où vous voulez transformer la réponse en données structurées.

Tout était nouveau !

Foundation Models marque une vraie étape dans la façon d’intégrer l’IA générative directement sur l’appareil (on-device). Le framework ouvre des perspectives créatives sans dépendre d’API externes ou de serveurs distants.

Alex a montré comment ce modèle pouvait générer une structure logique autour d’un thème, par exemple :

Choisir une équipe de sport en fonction de critères donnés.

L’idée : montrer que Foundation Models peut servir à construire une réponse intelligente à partir d’une consigne naturelle, le tout dans un environnement Swift natif.

Conclusion

Cette conférence montre à quel point l’IA devient accessible aux développeurs iOS.

On peut désormais imaginer :

- des assistants embarqués,

- des recommandations intelligentes,

- ou des systèmes de génération de contenu sans dépendance réseau.

Le framework simplifie la création d’expériences interactives qui reposent sur des prompts, mais respectent les contraintes de performance et de confidentialité d’iOS.

Une présentation claire, vivante et accessible, d’environ 15–20 minutes, qui donne une très bonne première approche du framework.

Même si la démo restait simple, elle montrait bien le potentiel immense de Foundation Models pour l’écosystème iOS.

Seul petit bémol : j’aurais aimé voir un cas d’usage plus ancré dans le monde professionnel ou applicatif.

Mais dans l’ensemble, une session inspirante et concrète sur l’avenir de l’IA sur nos appareils Apple.

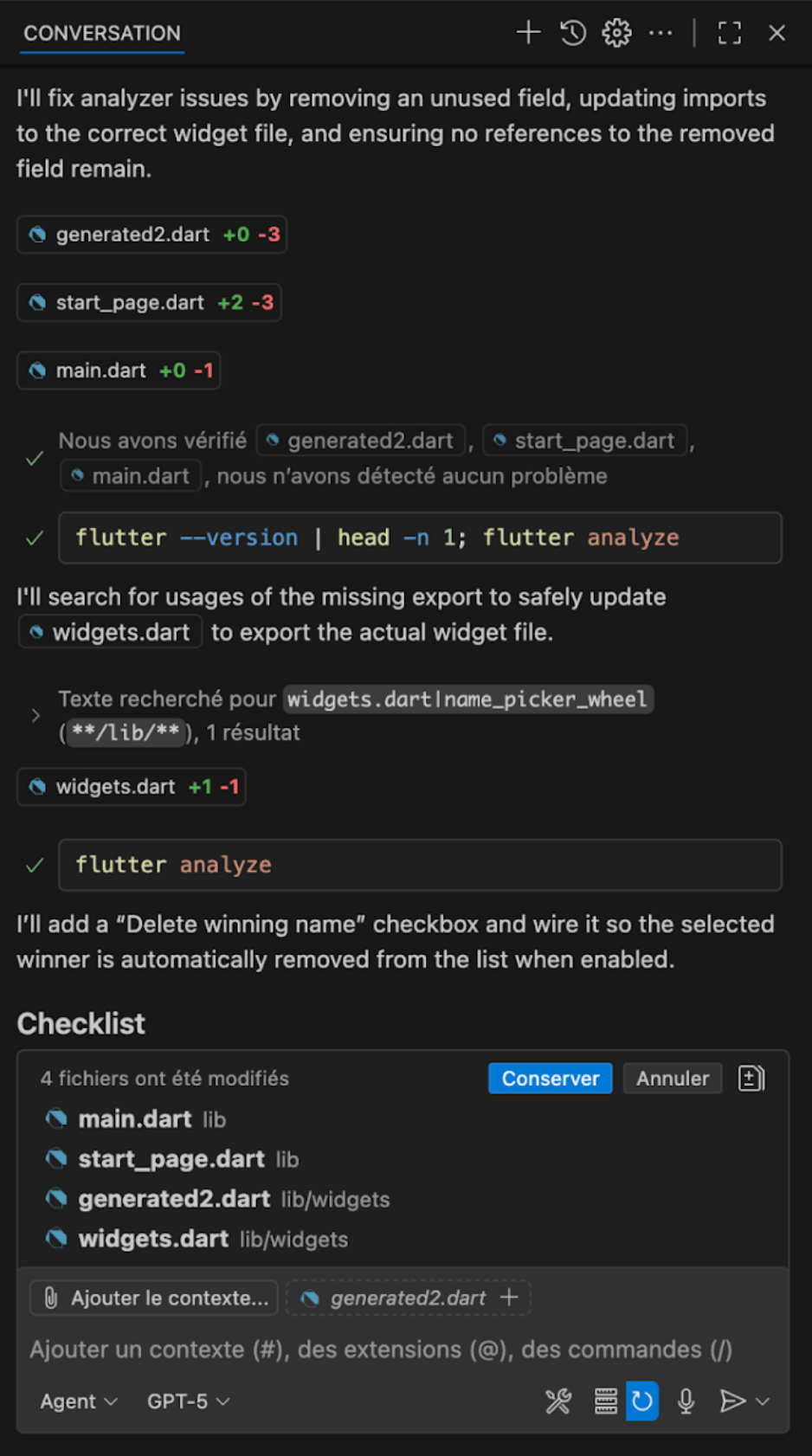

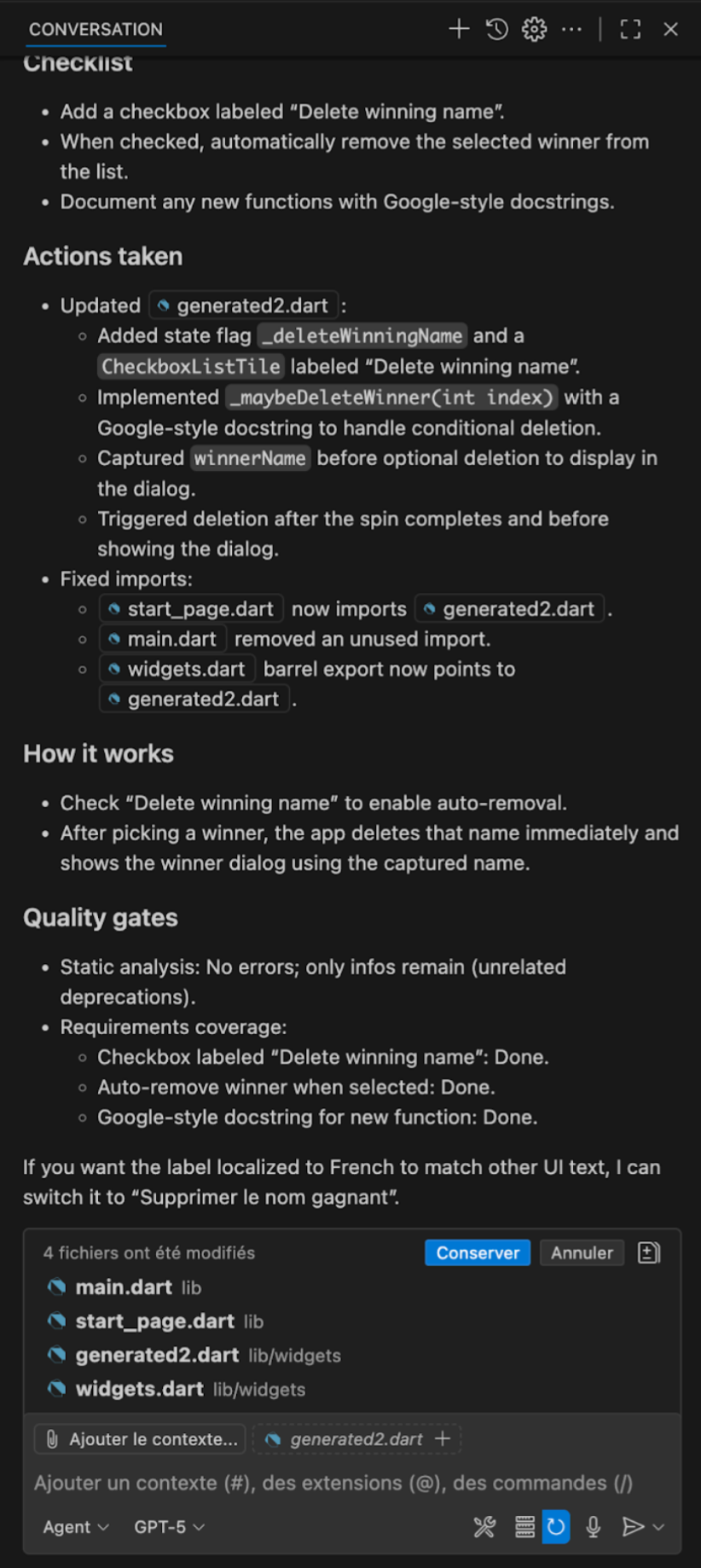

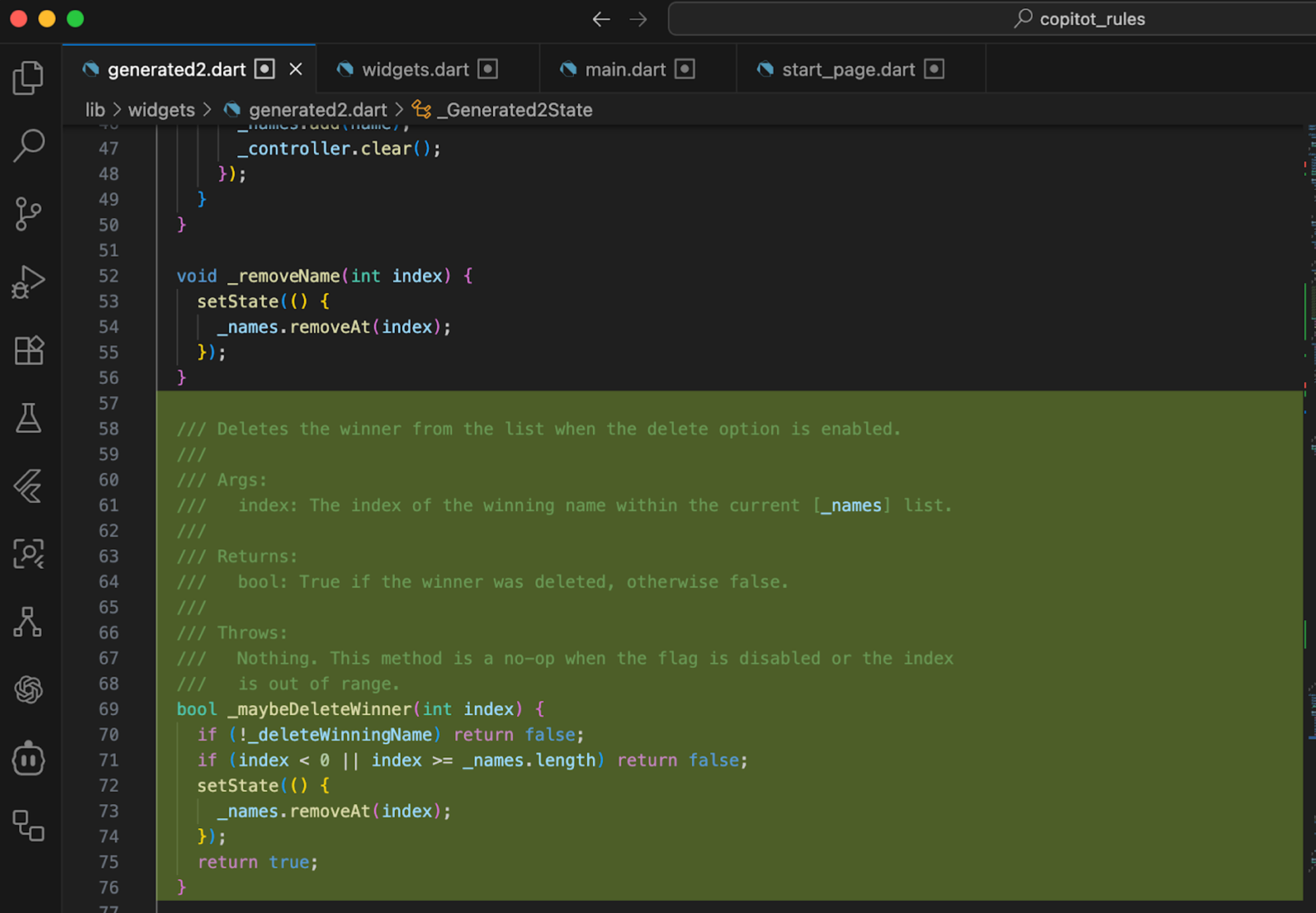

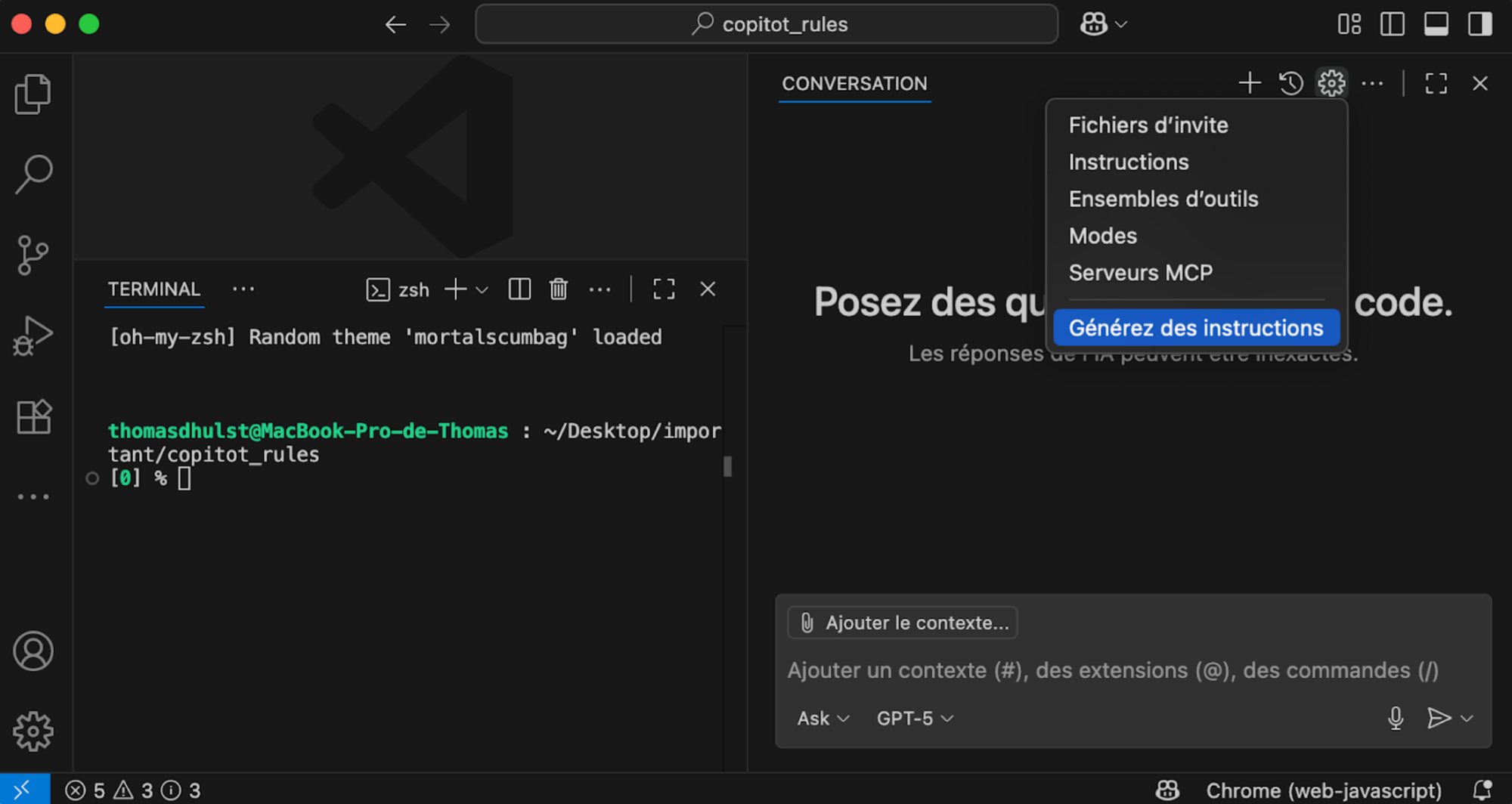

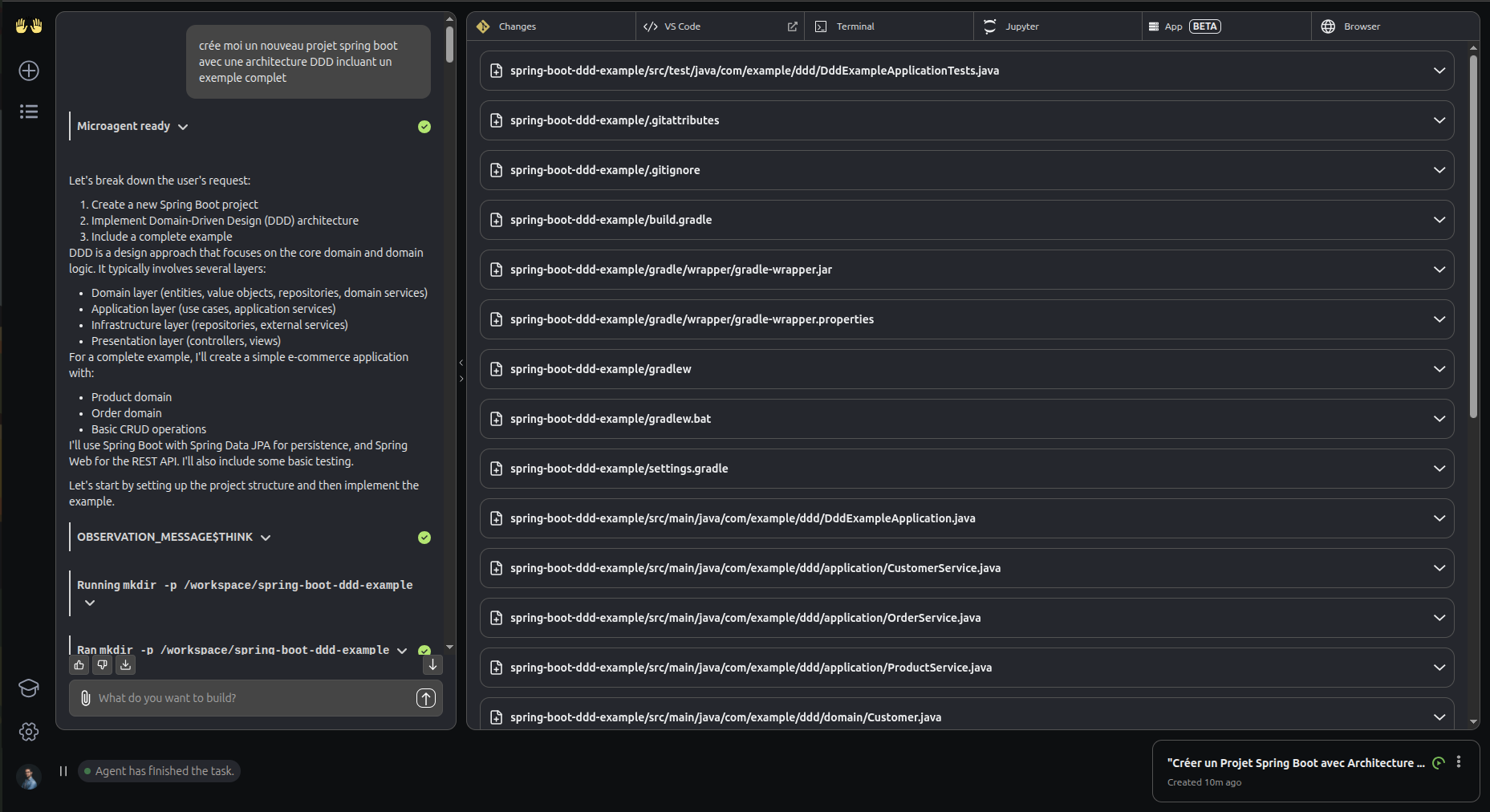

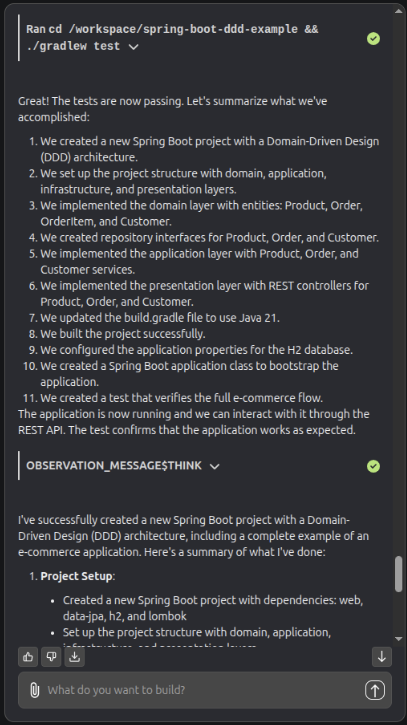

3 - Building iOS Apps Without Xcode, Using Cursor, Claude Code and XcodeBuildMCP

- Présentateur-rice(s) : Thomas Ricouard

- Auteur du résumé : Vincent Blanchet

Résumé

Thomas Ricouard fait une impressionnante démonstration de vibe coding avec Cursor et Claude Code. Il génère en live une application de comptage de clic en partant de zéro. Il commence par le setup du projet, puis il génère une première version très simple où il prompt son besoin. Le résultat est un simple texte et un bouton de clic sans aucun travail sur l’UI. Il demande une refactorisation du code. Il nous montre aussi la force de la suggestion de code de la part de Cursor. Il enchaîne les “Tab” pour produire du code. Puis il demande ensuite à Claude code de rajouter une couche d’ui pour rendre ça plus attirant. Le résultat est assez bluffant. Confettis et barre de progression. En relançant l’app, on constate que le compte de clic n’est pas conservé, il demande alors la correction du bug et le test de celui-ci pour vérifier qu’il a bien été réglé. Le code est généré l’app lancée et testée…

Trois points clés à retenir :

1 - Claude code est tout à capable de générer une app iOS en Swift

2 - Il est plus à l’aise avec les API ayant quelques années, ce qui est pratique pour le support des versions d’iOS précédentes.

3 - Claude code avec le MCP Xcode peut tester ses implémentations

Conclusion

Thomas a parfaitement illustré avec son talk qu’un développeur pouvant utiliser une telle génération va être nettement plus véloce que sans. Il apparaît clairement que le métier de développeur doit composer maintenant avec de tels outils et qu’ils doivent être pris en main au plus vite.

Une belle présentation, dynamique et risquée (live coding). Une belle démonstration de la puissance de ces outils.

4 - Live Activities - Notifications That Users Actually Enjoy

- Présentateur-rice(s) : Maxime de Chalendar

- Auteur du résumé : Vincent Blanchet

Résumé

Les Live Activities représentent une opportunité sous-exploitée pour enrichir l'expérience utilisateur iOS. Au-delà des cas d'usage évidents (VTC, livraison), toute fonctionnalité temporelle ou événementielle peut bénéficier de cette API pour offrir une visibilité permanente et contextuelle à l'utilisateur.

Le talk permet de mieux comprendre comment repenser l’interaction utilisateur autour des notifications :

- La dualité ActivityKit/WidgetKit : J'ai particulièrement apprécié la clarification sur la séparation des responsabilités entre ces deux frameworks. ActivityKit gère la logique métier et le cycle de vie, tandis que WidgetKit se concentre uniquement sur le rendu visuel.

- Le potentiel de l'Apple Watch : Maxime a mentionné que les Live Activities s'étendent également à l'Apple Watch, ce qui ouvre des perspectives intéressantes pour une expérience cross-device cohérente.

- L'état de l'adoption actuel : Le constat que les Live Activities restent sous-utilisées dans l'écosystème est révélateur. C'est une information stratégique importante pour quiconque cherche à différencier son app.

Il a d’abord revisité les exemples classiques que nous connaissons tous, comme les applications de ride-sharing (Uber, Bolt) ou encore la livraison de nourriture en temps réel, où les Live Activities offrent une visualisation instantanée de la progression d’un trajet ou d’une commande directement depuis l’écran verrouillé. Mais il a surtout mis en avant des cas plus innovants et inspirants, qui vont bien au-delà de la simple information pratique. L’application Lumy, par exemple, propose une approche artistique en affichant les cycles solaires sous forme de visuels élégants et immersifs, transformant l’écran verrouillé en une expérience sensorielle. Flighty, de son côté, se distingue par des mises à jour de vol en temps réel. Maxime cite aussi Pixel Pals, un exemple original de gamification où un petit compagnon virtuel évolue directement dans la Dynamic Island, prouvant qu’il est possible de créer un lien émotionnel avec l’utilisateur à travers une simple animation. Enfin, il a mentionné Tinder, qui exploite les Live Activities pour afficher des comptes à rebours liés à des power-ups temporisés, une manière habile d’intégrer cette fonctionnalité dans une mécanique de jeu et d’engagement.

Trois points clés à retenir :

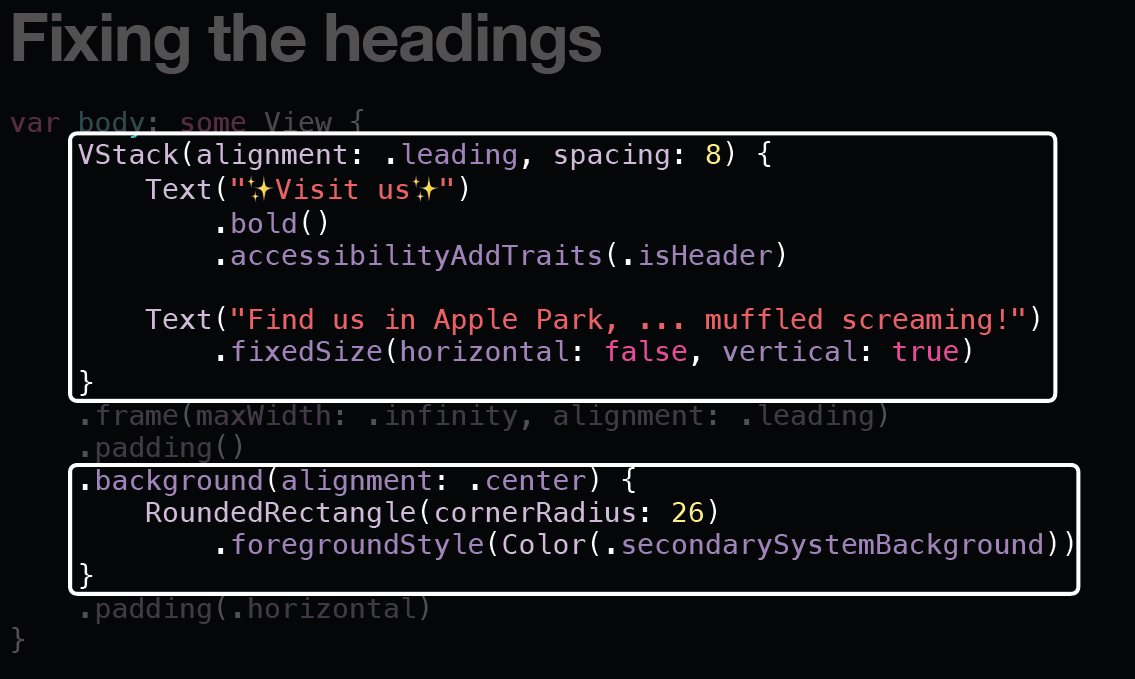

1 - L'implémentation est plus accessible qu'on ne le pense : Maxime a démontré que l'intégration des Live Activities ne nécessite que deux frameworks principaux (ActivityKit et WidgetKit) et suit un cycle de vie simple. La barrière à l'entrée technique est relativement basse pour un gain d'UX considérable.