Große Sprachmodelle (Large Language Models): Was Sie wissen sollten 7:00 AM (12 hours ago)

Große Sprachmodelle – oft LLMs (Large Language Models) genannt – sind KI-Systeme, die auf gigantischen Textmengen trainiert werden, um menschliche Sprache zu verstehen und selbst zu erzeugen. Man könnte sich vorstellen, dass ein LLM wie eine unfassbar große Bibliothek funktioniert, in der es alle Bücher und Artikel “liest” und lernt, wie Menschen schreiben. So ist ein solches Modell in der Lage, Dokumente zusammenzufassen, Fragen zu beantworten, Textvorschläge zu machen oder ganze Dialoge zu führen – und das oft ohne zusätzliche. Zum Beispiel finden Sie KI-basierte Chatbots im Kundenservice, automatische Übersetzungsdienste oder Textassistenten im Alltag, die auf dieser Technologie basieren. Diese LLMs arbeiten “out of the box”, können viele Aufgaben erfüllen, für die früher Spezialtools nötig waren.

Wie funktionieren LLMs technisch?

Im Kern sind LLMs tiefe neuronale Netze (Deep Learning). Sie bestehen aus mehreren Schichten künstlicher Neuronen und nutzen Beispiele, Beispiele, Beispiele: Sie werden mit Milliarden von Textworten trainiert. Dabei zerlegen sie jeden Satz in kleinste Einheiten, sogenannte Token, die etwa einem Wort oder Wortteil entsprechen. Ein LLM merkt sich dabei oft extrem lange Textabschnitte – beim aktuellen GPT-4o-Modell sind das bis zu rund 128.000 Tokens gleichzeitig im “Arbeitsgedächtnis”. Je mehr Parameter („Gewichte“) und Trainingsdaten ein Modell hat, desto besser kann es grammatikalische Strukturen, Wortverknüpfungen oder sogar komplexe Zusammenhänge erfassen.

Außerdem sind viele moderne LLMs multimodal: Sie verarbeiten nicht nur Text, sondern auch Bilder, Audio oder Videos. Das heißt, ein LLM kann beispielsweise auf einer Bildunterschrift-Beschreibung basierend Text generieren oder umgekehrt aus Worten ein Bildkonzept erstellen. Manche Modelle nutzen inzwischen sogar Agentenkonzepte wie die sogenannte Gedankenkette (Chain-of-Thought), um in mehreren Schritten ein Problem zu durchdenken. Kurzum: Große Sprachmodelle sind echte Alleskönner im Bereich natürlicher Sprache – tief vernetzte KI-Systeme, die lernen, Muster in menschlicher Kommunikation zu erkennen und zu reproduzieren.

Aktuelle LLM-Modelle und Marktüberblick

Auf dem Markt tummeln sich inzwischen zahlreiche LLMs – vergleichbar mit vielen Automarken im Straßenbild. Bekannte Vertreter sind etwa GPT-4/5 von OpenAI (bekannt durch ChatGPT), PaLM 2/Gemini von Google (DeepMind) und LLaMA 2/3 von Meta. Dazu kommen spezialisierte Modelle wie Anthropics Claude, xAI’s Grok, deutsche Beiträge wie Aleph Alpha und neuere offene Modelle von Anbietern wie Mistral AI oder Cohere. Jedes dieser Modelle hat eigene Stärken – einige sind besonders gut im Beantworten von Dialogfragen, andere im logischen Schlussfolgern oder Umgang mit Bildern. Wie Fraunhofer IESE erläutert, gilt daher: Man muss je nach Aufgabenstellung die Vor- und Nachteile genau abwägen, um das passende LLM auszuwählen.

Beispiel: GPT-4o (OpenAI) ist höchst “multimodal” und extrem leistungsfähig, während Open-Source-Varianten (etwa von Mistral AI) kostenfrei anpassbar sind. Neuere Ansätze wie Mixture-of-Experts (MoE) verteilen Rechenlast auf spezialisierte Untermodelle, um effizienter zu arbeiten. Auch Verfahren wie LoRA- oder PEFT-Feintuning ermöglichen es heute, große Modelle auf bestimmte Fachgebiete zu trimmen. Die Landkarte der LLMs ist dynamisch: Täglich erscheinen Updates – bleiben Sie also flexibel und prüfen Sie neue Entwicklungen, bevor Sie sich festlegen.

Anwendungsfälle in der Praxis

Große Sprachmodelle finden quer durch die Wirtschaft bereits vielfältige Anwendungen:

Kundenservice & Chatbots: KI-Chatbots beantworten rund um die Uhr Fragen von Kunden. Viele hunderttausend Anfragen werden bereits von Sprach-KIs bearbeitet. LLMs können dank Personalisierung sogar den Tonfall anpassen und standardisierte Problemlösungen anbieten.

Dokumentenverarbeitung: LLMs fassen lange Berichte oder Verträge zusammen und extrahieren Kernaussagen. In der Industrie werden sie z.B. für die Vertragsanalyse im Einkauf oder das Generieren von Wartungsanleitungen eingesetzt.

Software- und Prozessunterstützung: Entwickler nutzen LLMs als “Autokorrektur” für Programmcode oder zur Erstellung von Dokumentation. In der Fertigung helfen sie bei der Fehlersuche (Debugging) und indem sie Fachwissen für maschinelle Abläufe strukturieren.

Wissensmanagement: Große Datenmengen – etwa Kundenmails oder Handbücher – lassen sich automatisch durchforsten. LLMs erstellen dabei Wissensdatenbanken, auf die Mitarbeiter per Frage zugreifen können.

Marketing & Content: Texte für Webseiten, Social Media oder Produktbeschreibungen schreibt man mit KI-Unterstützung schneller. LLMs generieren auch Ideenskizzen oder kreative Impulse für Kampagnen.

Übersetzung & Lokalisierung: Moderne LLMs übersetzen qualitativ hochwertige Texte in viele Sprachen und eignen sich für internationale Kommunikation.

Alltagsbeispiele finden sich in vielen Branchen: Banken verwenden LLMs für Compliance-Prüfungen, Logistikfirmen für Sendungsverfolgungen via Chatbot, und IT-Betriebe zur Automatisierung von Ticket-Beantwortungen. Die größte Ersparnis liegt oft darin, dass Mitarbeitende repetitive Schreib- und Sucharbeit abgeben können – das steigert Effizienz und kreative Freiräume.

LLMs für KMU, Vereine und Selbständige

Große Sprachmodelle sind nicht nur etwas für Konzerne: KMU, Vereine oder Soloselbständige profitieren mindestens genauso. Gerade kleine Betriebe ohne eigene KI-Abteilungen können auf bestehende LLM-Dienste zurückgreifen. Beispielsweise bietet die Deutsche Telekom gemeinsam mit Partnern spezielle LLMs (mehrsprachig, u.a. Deutsch) für die Telekommunikationsbranche an– ein Ansatz, der auch andere mittelständische Firmen inspiriert.

In der Praxis kann ein lokaler Handwerksbetrieb ein LLM zum Ausformulieren von Angeboten oder Kunden-E-Mails nutzen. Ein Sportverein könnte einen FAQ-Chatbot für Mitglieder einrichten, der Unklarheiten zum Training oder der Anmeldung beantwortet. Selbständige Journalisten und Texter setzen KI-Tools oft ein, um Entwürfe zu erstellen oder umfangreiche Recherchen zu vereinfachen.

Viele Anbieter stellen Cloud-APIs (z.B. OpenAI, Azure, AWS, Google Cloud) bereit, sodass keinerlei Infrastruktur nötig ist. Open-Source-Modelle (etwa von Mistral oder bei Hugging Face) lassen sich sogar kostenlos nutzen und lokal betreiben – was gerade für Kostenbewusste sehr. Wichtig dabei: Holen Sie sich bei Bedarf eine kleine Schulung ins Haus oder testen Sie kostenloses Webinar-Angebote – so ein KI-Coach hilft, dass KI-Versuch nicht im Chaos endet. Unabhängig von der Branche gilt: Wer Einstiegshürden überwindet, gewinnt. Denn wo früher viel manuelle Schreib- und Lese-Arbeit war, können Sie mit LLMs Zeit sparen und sich aufs Wesentliche konzentrieren.

Chancen und Grenzen (Mythen und Realitäten)

Achtung, kein “Allerheilmittel”! Große Sprachmodelle klingen fantastisch, aber sie haben klare Grenzen. Sie erzeugen zwar menschlich klingenden Text, doch sie “verstehen” die Inhalte nicht so wie wir. Oft basieren ihre Antworten nur auf gelernten Mustern aus Daten. Das kann dazu führen, dass ein LLM gelegentlich „halluziniert“ – also plausibel klingenden, aber falschen Unsinn erfindet. Ein häufiger Mythos ist, dass KI immer korrekt ist – ganz im Gegenteil muss man ihre Resultate genau prüfen.

Auch logische Schlussfolgerungen sind für LLMs ein Problem. Sie ziehen keine echten kausalen Verbindungen, und Faktentreue ist nicht garantiert. Ein Modell mag zum Beispiel nach Trainingsdaten “glauben”, dass XYZ stimmt, auch wenn sich die Fakten geändert haben. Deshalb sollten Sie LLM-Antworten nicht ohne Kontrolle übernehmen. Ein weiterer Punkt: Datenschutz und Ethik. Bei Telekom wurde etwa streng pseudonymisiert getrackt, welche Kundendaten ins KI-Training fließen. Auch Sie sollten darauf achten, keine sensiblen Firmen- oder Personendaten ungefiltert in eine KI zu geben – viele Anbieter geben dafür klare Warnungen aus.

Typische Irrtümer auf einen Blick:

“LLM kann alles” – Nein. Sie können viele Spracheaufgaben gut lösen, aber sie sind noch meilenweit davon entfernt, echte Intelligenz oder moralische Urteilsfähigkeit zu besitzen.

“KI macht teure Hochleistungshardware nötig” – Ein Großteil der LLM-Arbeit läuft heute in der Cloud, auch kleinere Firmen können per API zuschalten. Lokale Versionen sind oft schlank genug für normale PCs.

“Versteht die KI mich wirklich?” – LLMs sind oft schlecht darin, kulturelle Feinheiten oder Humor zu erfassen. Sie können zwar witzig antworten, aber das ist nur statistisch gelernt, nicht echt “Empathie”.

Unterm Strich gilt: LLMs sind starke Helfer, aber keine eigenständigen Kreatoren. Betrachten Sie sie als superschnelle Schreibassistenten mit Statistik im Rücken – faszinierend, aber eben “nur” Computerprogramme.

LMM´s und SEO

SEO (Suchmaschinenoptimierung) und LLMs (Large Language Models) überschneiden sich zunehmend an einem entscheidenden Punkt: dem Verständnis und der Aufbereitung von Inhalten für Maschinen. Während SEO ursprünglich darauf abzielte, Webseiten für Algorithmen wie Google Crawler besser auffindbar zu machen, verlangen moderne KI-Systeme nun zusätzlich semantisch präzise, kontextreiche Inhalte. LLMs analysieren dabei nicht nur Keywords, sondern ganze Bedeutungsräume – sie „verstehen“ also eher, worum es in einem Text geht. Das verändert, wie Inhalte strukturiert und formuliert werden sollten, um sowohl im klassischen Ranking als auch in KI-generierten Antworten präsent zu sein.

Ein weiterer Schnittpunkt liegt in der Sichtbarkeit in sogenannten KI-Antwortsystemen – etwa wenn Nutzer Fragen in Chatbots oder in der Google-KI-Suche (Search Generative Experience) eingeben. LLMs ziehen Informationen aus öffentlich zugänglichen Webseiten, wobei strukturierte, konsistente und gut markierte Inhalte bevorzugt werden. Wer also seine Seiten mit klarem Fokus, sauberem HTML, llms.txt-Dateien und semantischen Daten (wie JSON-LD) ausstattet, liefert den KI-Systemen genau das „Futter“, das sie benötigen, um eine Marke oder Dienstleistung korrekt und prominent zu nennen – ganz unabhängig vom klassischen SEO-Ranking.

Nicht zuletzt fließen LLMs auch direkt in die SEO-Tools und -Strategien selbst ein: KI-gestützte Keyword-Analysen, Content-Briefings oder Snippet-Optimierungen basieren zunehmend auf Sprachmodellen. SEO und LLMs verschmelzen damit auf zwei Ebenen: Einerseits müssen Inhalte so gestaltet sein, dass sie von KI verstanden und wiedergegeben werden können. Andererseits helfen LLMs dabei, genau solche Inhalte effizient und zielgerichtet zu erstellen. Wer das strategisch nutzt, verschafft sich einen spürbaren Vorsprung – sowohl in der Suchmaschine als auch in der KI-gestützten Wahrnehmung.

Ausblick: Was kommt als Nächstes?

Die Entwicklung bei LLMs steht erst am Anfang. In Kürze rechnen Experten mit noch größeren Modellen, längeren Kontextfenstern (vielleicht bald über 1 Million Tokens), und noch ausgefeilteren Agentenfunktionen. Schon jetzt forschen Entwickler daran, KI-Modelle eigene Ideen durchdenken zu lassen. Techniken wie Chain-of-Thought erlauben es LLMs schon heute, Probleme Schritt für Schritt zu lösen.

Vielleicht steht uns bald ein echter „Aha-Effekt“ ins Haus, wenn KIs komplexe Projekte selbständig skizzieren – etwa ein Marketingkonzept oder ein Fachgutachten, komplett mit Quellen-Checks. Gerade Open-Source-Communitys treiben parallel neue Modelle voran: Wer weiß, vielleicht erschafft gerade jemand in Europa ein KI-System, das speziell für unsere Sprache besonders gut ist. Auch die Kombination von LLM mit Bild- oder Video-KI (Multimodalität) wird weiterwachsen – schon bald könnten Sie einfach ein Foto hochladen und das LLM generiert automatisch den passenden Werbetext dazu.

Eines ist sicher: Bleiben Sie neugierig! Wenn Sie die Chancen richtig anpacken (und ihre Grenzen beachten), können LLMs Ihnen viel Arbeit abnehmen. Im Endeffekt werden wir alle in absehbarer Zukunft mit LLMs zusammenarbeiten – seien Sie dabei vorn dabei statt nur abwartend zuzuschauen.

Der Beitrag Große Sprachmodelle (Large Language Models): Was Sie wissen sollten erschien zuerst auf Austrianweb Suchmaschinenoptimierung.

Von der Garage zum Online-Shop: Wie gute Etiketten kleinen Händlern helfen, professionell zu wirken 7 Sep 6:51 AM (last month)

Unerwarteter Anfang: Ein Marmeladenglas und die große Wirkung

Vielleicht erinnern Sie sich an die Gründer-Geschichten von Amazon oder Apple – auch die haben mal in einer Garage angefangen. Aber lassen Sie uns kleiner denken: Ein Glas selbstgemachter Himbeermarmelade, verkauft am Straßenrand. Schmeckt fantastisch. Nur – ohne Etikett wirkt es wie ein Mitbringsel von der Nachbarin. Mit einem sauber gedruckten Label, Logo, Nährwertangaben und einem QR-Code zum Online-Shop? Plötzlich wirkt das Glas wie ein Produkt, das auch im Feinkostregal bestehen könnte.

Genau hier liegt der Unterschied: Etiketten sind für kleine Händler nicht nur „Aufkleber“, sie sind Visitenkarte, Vertrauensanker und manchmal sogar Eintrittskarte in die große Online-Welt.

Warum Etiketten für kleine Händler so entscheidend sind

Die meisten Gründer unterschätzen das Thema. „Solange der Inhalt gut ist, wird sich schon jemand finden.“ Falsch gedacht. Kunden entscheiden in Sekundenbruchteilen, ob sie ein Produkt als professionell wahrnehmen oder nicht.

Erster Eindruck zählt: Ein verschwommen gedrucktes Etikett schreit „Hobbyprojekt“. Ein klares, strukturiertes Label signalisiert Seriosität.

Vertrauen entsteht durch Details: Pflichtangaben wie Inhaltsstoffe oder Herstelleradresse machen das Produkt nachvollziehbar – und schützen Sie vor Abmahnungen.

Markenbildung beginnt mit Wiedererkennbarkeit: Ein einheitliches Design, das sich auf allen Produkten durchzieht, prägt sich beim Kunden ein.

„Etiketten für kleine Online-Händler“ – unterschätzter Gamechanger

Wenn Sie einen kleinen Etsy-Shop betreiben, auf Märkten verkaufen oder über Amazon FBA starten – das Etikett ist Ihr stiller Verkäufer. In den Suchmaschinen taucht dieses Thema kaum auf, doch gerade hier entscheidet sich oft, ob ein Kunde erneut bestellt oder nur einmal probiert.

Vom Garagenprodukt zum E-Commerce-Hit: praktische Beispiele

- Kaffee-Rösterei im Kleinstformat: Mit einem Standarddrucker sehen die Beutel billig aus. Mit matten, wasserfesten Etiketten wirken sie sofort hochwertig – und halten auch beim Versand.

- Handgemachte Seifen: Ohne klare Angabe zu Inhaltsstoffen droht nicht nur Misstrauen, sondern auch Ärger mit der Kosmetikverordnung.

- Craft-Bier oder Limonade: Ein QR-Code auf dem Etikett, der zur Brau-Geschichte führt, schafft Kundenbindung und hebt Sie von der Massenware ab.

Typische Fehler kleiner Händler – und wie man sie vermeidet

- Handschriftliche Labels: Wirkt persönlich, aber nicht skalierbar. Ab 50 Produkten wirkt es unprofessionell.

- Falsche Klebstoffe: Billige Etiketten lösen sich im Kühlschrank oder bei Feuchtigkeit – ein No-Go.

- Unleserliche Schriftarten: Verschnörkelte Schriften sehen hübsch aus, aber wenn der Kunde die Sorte nicht erkennt, war’s das.

Unklare Markenbotschaft: Einmal bunt, einmal minimalistisch – ohne einheitliche Linie geht der Wiedererkennungswert verloren.

Etikettendrucker als Erfolgsfaktor

Viele Einsteiger scheuen die Investition in einen eigenen Etikettendrucker für kleine Händler. Doch die Vorteile liegen auf der Hand:

- Flexibilität: Heute drucken Sie 10 Etiketten für die Testreihe, morgen 500 Stück für den Markt.

- Professionalität: Thermotransferdrucker liefern langlebige, wasser- und kratzfeste Labels.

- Kosteneffizienz: Statt ständig externe Druckereien zu beauftragen, produzieren Sie kleine Chargen selbst – ohne lange Lieferzeiten.

Rechtliche Aspekte, die oft übersehen werden

In den gängigen Google-Artikeln findet man zwar Hinweise auf „Design“ und „Marketing“, doch rechtliche Vorgaben kommen oft zu kurz. Für kleine Händler sind diese aber existenziell.

- Lebensmittelkennzeichnung: Zutatenliste, Nährwertangaben, Mindesthaltbarkeitsdatum – Pflicht.

- Kosmetik & Pflegeprodukte: INCI-Bezeichnungen, Herstelleradresse, Chargennummer.

- Textilien: Materialzusammensetzung nach EU-Verordnung.

Fehlt nur eine dieser Angaben, drohen Abmahnungen. Und das kann für ein junges Unternehmen schnell das Aus bedeuten.

Psychologie der Etiketten: Warum Kunden kaufen (oder nicht)

Ein sauber gestaltetes Etikett vermittelt: Hier hat jemand Sorgfalt investiert. Das wirkt unbewusst auf den Kunden – er überträgt diese Professionalität auf das Produkt selbst.

Interessant: Studien zeigen, dass Kunden 20–30 % mehr für ein Produkt bezahlen, wenn die Verpackung hochwertig wirkt. Für kleine Händler ist das ein enormer Hebel.

„Etiketten drucken für kleine Shops“ – mit Automatisierung zum Wachstum

Was selten thematisiert wird: Ab einem gewissen Punkt wächst ein Geschäft schneller, als man denkt. Plötzlich stapeln sich die Bestellungen, und handgeklebte Labels kosten Stunden. Hier hilft:

- Integration von Etikettendruckern in Shop-Systeme (z. B. Shopify oder WooCommerce).

- Automatischer Etikettendruck für Versandlabels, gekoppelt an Bestellbestätigungen.

- Barcode-gestützte Lagerverwaltung, die selbst bei 200 Produkten noch den Überblick wahrt.

Nachhaltigkeit als zusätzlicher Vorteil

Gerade kleine Händler können durch bewusste Etikettenwahl punkten:

- Recyclingpapier und lösungsmittelfreie Farben.

- Wiederverwendbare Verpackung mit ablösbaren Etiketten.

- Hinweis auf Nachhaltigkeit direkt auf dem Label („Etikett aus 100 % Recyclingpapier“).

Das kommt bei umweltbewussten Käufern an – und ist ein Storytelling-Element, das große Konzerne oft nicht authentisch rüberbringen.

Fazit: Kleine Händler, große Wirkung

Ein Etikett ist kein Detail. Es ist oft der Unterschied zwischen „Hobbyprojekt aus der Garage“ und „ernstzunehmendem Online-Shop“.

Wer früh in gute Etiketten und den passenden Etikettendrucker investiert, baut nicht nur Vertrauen auf, sondern schafft eine Basis, die mit dem Geschäft mitwächst.

Vielleicht ist es nur ein Stück Papier mit Klebstoff. Aber in Wahrheit ist es das, was Ihr Produkt sichtbar macht, begreifbar macht, glaubwürdig macht.

Sie suchen qualitativ hochwertige Etiketten?

Bei uns sind Sie genau richtig! Auf unserer Druckartikel Übersicht finden Sie unter anderem folgendes:

1. Einzeln ausgestanzte Etiketten / Sticker

Individuelle Form und Größe, Vielfalt an Materialien und Formen. Perfekt für individuelle Produktlabels oder Sticker-Designs.

2. Etiketten auf Bögen (Stickerbögen)

Formate: rund, quadratisch, rechteckig oder Freiform. Materialvarianten: Papier, Kunststofffolie (transparent, weiß, silber), Textil. Optionen für Weißdruck, spiegelverkehrten Druck, 4c-Digitaldruck.

3. Etiketten auf Rollen (Rollenetiketten)

Papieretiketten, Kunststoffetiketten, entfernbare Etiketten, Neonpapier, wiederbeschreibbare Etiketten. Geeignet für Weinflaschen, Lebensmittelverpackungen, Textiletiketten, Adressetiketten.

4. Veredelte Etiketten

Veredelungsmöglichkeiten: kratzfester Lack, Gold- oder Silberfolie. Materialien: Weiß/transparente Polypropylenfolie, gestrichenes Papier, Satin-Papier, Betulla Verge (luxuriös strukturiert).

5. Etiketten für Kosmetik- und Körperpflege

Material: Kunststofffolie oder Papierkleber. Veredelung: UV-Lack (glänzend oder matt). Speziell geeignet für Kosmetikartikel.

6. Flaschenetiketten

Formen: drei Standardformen + freie Kontur. Material: Kunststofffolie oder Papierkleber. Fett- und ölresistent – ideal für Getränke, Marmelade, etc.

7. Lebensmitteletiketten

Veredelung: UV-Lack, glänzend oder matt. Fett- und ölresistent, geeignet für Glas-, Alu- oder Plastikverpackungen.

8. Allgemeine Papieretiketten

Verschiedene Papierklebervarianten mit oder ohne Lackierung. Einsatz auf Glas-, Plastik- oder Pappverpackungen.

9. Textiletiketten / Stoffetiketten

Formen: quadratisch, rund, rechteckig oder Freiform. Material: Acetatseide. Einsatz als Namensschilder oder zur Textilkennzeichnung.

10. Kunststoffetiketten

Material: verschiedene Kunststofffolien. Eigenschaften: UV- und kratzbeständig – für Innen- und Außenbereiche.

11. Entfernbare Etiketten

Material: Kunststofffolie. Rückstandslos entfernbar – ideal bei temporären Anwendungen oder wechselnden Einsatzorten.

12. Aufkleber & Sticker inkl. 3D-Doming

Varianten: Kunststoff oder Papier. Formen: Rechteck, Kreis oder Kontur. Optionen: 3D-Effekt-Aufkleber, PVC-frei, wetterbeständig, Schutzfolierung (glänzend/matt), bestellbar ab 1 Stück.

13. Refix – elektrostatische Folienetiketten

Material: 125 µm Polyesterfolie. Eigenschaften: haftet elektrostatisch auf glatten Flächen wie Glas oder Metall, wiederverwendbar, rückstandsfrei entfernbar, komplett recycelbar, UV- und kratzfest.

Kategorien im Überblick

| Etikettentyp | Besonderheiten / typische Einsatzgebiete |

|---|---|

| Einzeln ausgestanzte Etiketten | Individuelle Formen & Größen, Sticker für vieles mehr |

| Etiketten auf Bögen | Vielfältige Materialien, Weißdruck, spiegelverkehrt, A4-Bogen |

| Etiketten auf Rollen | Große Mengen, diverse Materialien, Anwendungen für Wein, Lebensmittel, Textilien |

| Veredelte Etiketten | Hochwertige Veredelung mit Lack, Gold-/Silberfolie |

| Kosmetik-Etiketten | UV-Lack veredelt, passend für Kosmetikverpackungen |

| Flaschenetiketten | Fett-/ölresistent, individuelle Konturen möglich |

| Lebensmitteletiketten | Für robuste Verpackungen, UV-Schutz, hohe Beständigkeit |

| Allgemeine Papieretiketten | Universell einsetzbar auf diversen Oberflächen |

| Textil-/Stoffetiketten | Für Bekleidung, Namensschilder |

| Kunststoffetiketten | Outdoor geeignet, langlebig und robust |

| Entfernbare Etiketten | Temporär, rückstandsfrei ablösbar |

| Aufkleber & 3D-Sticker | Dekorativ, wetterfest, diverse Materialien und Formen |

| Refix elektrostatische Etiketten | Wiederverwendbar, haftet ohne Kleber, ideal für saisonale Anwendungen |

Der Beitrag Von der Garage zum Online-Shop: Wie gute Etiketten kleinen Händlern helfen, professionell zu wirken erschien zuerst auf Austrianweb Suchmaschinenoptimierung.

Überblick über aktuelle Datenschutzgesetze und deren Auswirkungen auf Marketingstrategien 4 Sep 5:24 AM (last month)

Ihre neueste Marketingkampagne läuft auf Hochtouren – doch plötzlich steht die Frage im Raum: Dürfen Sie all diese Daten eigentlich nutzen? Datenschutz ist längst kein Nischenthema mehr. Im digitalen Marketing hat sich in den letzten Jahren enorm viel getan, und zwar nicht nur wegen der DSGVO. Tatsächlich prägen neue Datenschutzgesetze die Marketinglandschaft mehr denn je und stellen Marketing-Strateg:innen vor große Herausforderungen. Ein bisschen mulmig? Verständlich. Schließlich möchte niemand in Teufels Küche kommen, weil eine Werbeaktion gegen Datenschutzrichtlinien verstößt. Aber keine Sorge: Mit dem richtigen Überblick lässt sich das scheinbar trockene Regelwerk meistern – und vielleicht sogar zu Ihrem Vorteil nutzen.

Wandel im Datenschutz: Warum Marketing aufhorchen muss

Über Nacht hat sich das Blatt gewendet: Wo früher Daten in Hülle und Fülle gesammelt wurden, ziehen heute strengere Datenschutzgesetze die Zügel an. Spätestens seit die EU-Datenschutz-Grundverordnung (DSGVO) 2018 in Kraft trat, ist Datenschutz das A und O im Marketing. Die DSGVO brachte eine europaweite Reform mit hohen Bußgeldern (bis zu 20 Millionen Euro oder 4 % des globalen Umsatzes) und gilt für alle, die personenbezogene Daten von EU-Bürgern verarbeiten. Und die Folgen? Nun, die Debatten um Consent und Cookies reißen seitdem nicht ab. Unternehmen mussten begreifen, dass aktives Einwilligen der Nutzer zur neuen Norm geworden ist – spätestens nach gerichtlichen Entscheidungen blieb „praktisch kein Platz mehr für andere Lösungen“ als das Opt-in-Modell.

Doch die DSGVO war erst der Anfang. Im Kielwasser dieser Verordnung steigt das Datenbewusstsein der Öffentlichkeit: Datenschutzbehörden sind hellhörig und kontrollieren mittlerweile vermehrt, wie Unternehmen Einwilligungen einholen – insbesondere beim Tracking und Profiling.

Kurzum: Die Luft für laxe Datenschutzpraktiken wird dünn. Wer heute Marketing betreibt – ob im B2C- oder B2B-Bereich – muss Datenschutz nicht nur kennen, sondern leben. Andernfalls kann es teuer werden und das Firmenimage leiden. Datenschutz ist damit von der lästigen Pflicht zur echten Compliance-Säule geworden, die über Erfolg oder Misserfolg von Marketingstrategien mitentscheidet.

Wichtige Datenschutzgesetze im Überblick

Ein Netzwerk aus Daten auf der Weltkugel – Datenschutzgesetze greifen global ineinander und beeinflussen Marketingstrategien.

Im Datenschutz-Dschungel 2024 stehen Marketer vor gleich mehreren relevanten Gesetzen und Regelwerken. Ein Überblick über die wichtigsten aktuellen Datenschutzgesetze und -vorgaben und was sie bedeuten:

EU-DSGVO: Der Goldstandard des Datenschutzes

Die EU-Datenschutz-Grundverordnung (DSGVO) ist nach wie vor das Herzstück. Sie vereinheitlicht die Regeln zum Umgang mit personenbezogenen Daten in allen EU-Mitgliedstaaten. Personenbezogene Daten? Darunter fällt praktisch alles, was einen Menschen identifizieren kann – von Name, E-Mail und Telefonnummer bis hin zu IP-Adresse oder Cookie-ID.

Die DSGVO basiert auf Grundprinzipien wie Rechtmäßigkeit, Transparenz, Datenminimierung und Zweckbindung. Grob gesagt: Alles ist verboten, außer es ist ausdrücklich erlaubt.

Unternehmen dürfen Daten nur verarbeiten, wenn eine Rechtsgrundlage vorliegt – etwa zur Vertragserfüllung, berechtigtes Interesse oder am häufigsten: eine explizite Einwilligung der Betroffenen.

Für Marketer bedeutet das: Vorbei die Zeiten vorab angekreuzter Newsletter-Häkchen. Nutzer müssen jetzt aktiv „Ja“ sagen – sei es beim Newsletter-Abonnement, beim Setzen von Cookies oder beim Tracking. Die DSGVO stärkt zudem die Rechte der Verbraucher: Recht auf Auskunft, Berichtigung, Löschung etc..

Jede Person kann verlangen zu wissen, welche Daten über sie gespeichert sind, und sogar deren Löschung fordern. Für Unternehmen heißt das Transparenz schaffen und notfalls auch mal Daten löschen, statt sie ewig zu horten. Gerade das Recht auf Löschung („Recht auf Vergessenwerden“) zwingt Marketingabteilungen zum Umdenken: Daten von Leads oder ehemaligen Kunden dürfen nicht endlos auf Halde liegen.

Nicht zuletzt hat die DSGVO eine enorme extraterritoriale Wirkung: Auch Firmen außerhalb der EU müssen sie einhalten, wenn sie EU-Bürger datenmäßig anvisieren. Das erklärt, warum amerikanische Konzerne plötzlich ihre Datenschutzrichtlinien angepasst haben und wieso international oft vom “GDPR” (General Data Protection Regulation) die Rede ist. Und aufgepasst: Die Behörden meinen es ernst. Verstoße werden mit empfindlichen Strafen geahndet – man denke nur an die Milliardenstrafen für Meta/Facebook & Co. Vertrauen ist gut, Compliance ist besser.

Nationale Gesetze: TTDSG/TDDDG und Co. – Cookie-Regeln auf Länderebene

Neben der großen DSGVO gibt es weitere Gesetze, die speziell im Marketing-Alltag wichtig sind. Ein prominentes Beispiel ist das Thema Cookies. Hier kommt die ePrivacy-Richtlinie ins Spiel, die von EU-Ländern ins nationale Recht umgesetzt wurde. In Deutschland galt seit Dezember 2021 das Telekommunikation-Telemedien-Datenschutz-Gesetz (TTDSG), das klarstellte: Ohne Einwilligung keine nicht-notwendigen Cookies.

Cookie-Banner wurden dadurch faktisch Pflicht. Und falls Sie dachten, mehr Banner gehen nicht: Zum 14. Mai 2024 wurde das TTDSG vom Telekommunikation-Digitale-Dienste-Datenschutz-Gesetz (TDDDG) abgelöst.

Dieses neue Gesetz weitet den Schutz sogar noch aus. Es schützt die Privatsphäre aller Endeinrichtungen, also letztlich aller Geräte von Nutzern – und das sowohl für personenbezogene als auch nicht-personenbezogene Informationen.

Kurz gesagt: Jegliches Speichern oder Auslesen von Informationen auf dem Gerät des Nutzers (Stichwort Cookies, Local Storage, Device-Fingerprinting) ist nur erlaubt, wenn entweder eine Einwilligung vorliegt oder eine der engen Ausnahmen greift.

Für Marketer bedeutet das TDDDG konkret: Tracking-Tools wie Google Analytics, personalisierte Werbung mittels Cookies oder Social-Media-Plugins dürfen nur mit aktivem Opt-in genutzt werden, außer sie sind technisch unbedingt erforderlich.

Wer also Online-Marketing in Deutschland betreibt, kommt um ein sauberes Consent-Management nicht herum. Ähnliche Gesetze gelten im Prinzip überall in der EU – in Österreich zum Beispiel durch Anpassungen im Telekommunikationsgesetz, in anderen Ländern teils durch separate E-Privacy-Gesetze. Der große Wurf, die EU-ePrivacy-Verordnung, lässt zwar immer noch auf sich warten, aber de facto hat Deutschland mit dem TDDDG schon umgesetzt, was die EU anstrebt: nämlich echte Wahlfreiheit für Nutzer und weniger Cookie-Banner-Chaos (man hofft es zumindest).

Fun Fact: Ein erklärtes Ziel der kommenden EU-Regelung ist es sogar, die nervigen Cookie-Banner abzuschaffen und ins Browser-Setting zu verlagern. Ob das gelingt? Abwarten – noch surfen wir im Banner-Dschungel.

Datenschutz weltweit: Von Kalifornien bis zur Schweiz

Datenschutz ist kein rein europäisches Thema. Weltweit ziehen Staaten nach, was für international agierende Unternehmen wichtig ist. In den USA gibt es zwar kein DSGVO-Äquivalent auf Bundesebene, aber Bundesstaaten wie Kalifornien preschen voran. Dort gilt seit 2020 der California Consumer Privacy Act (CCPA), seit 2023 verschärft durch die CPRA. Ähnlich wie die DSGVO gibt der kalifornische Datenschutz Verbrauchern Rechte über ihre Daten (Auskunft, Löschung, Opt-out vom Verkauf der Daten). Bekannt wurde ein Fall, in dem der Kosmetikriese Sephora eine Strafe zahlen musste, weil er ohne ausreichende Hinweise Nutzerdaten an Werbenetzwerke und Analytics-Dienste weitergab – ein deutliches Signal, dass auch jenseits des Atlantiks ernst gemacht wird. Und ja, selbst Japan erhielt kürzlich einen Weckruf: Ein japanisches Unternehmen wurde wegen DSGVO-Verstoßes zur Kasse gebeten. Die Botschaft: Datenschutz ist global im Kommen.

Auch Schweizer Unternehmen mussten 2023 aufhorchen: Zum 1. September 2023 trat das revidierte Datenschutzgesetz revDSG in Kraft.

Dieses neue Schweizer DSG ist stark an die DSGVO angelehnt, erhöht aber teils die Anforderungen. So gelten nun auch dort erweiterte Informationspflichten, und Konzepte wie Privacy by Design und Privacy by Default sind ausdrücklich vorgeschrieben. Für das Marketing in der Schweiz heißt das z.B.: Double Opt-in für Newsletter ist Pflicht, ein klares Widerspruchsrecht der Empfänger ebenso.

Tracking-Pixel in Mails? Nur mit vorheriger Einwilligung.

Und wer dachte, als ausländische Firma sei man aus dem Schneider, irrt – das revDSG gilt auch für Unternehmen außerhalb der Schweiz, sofern sie den Schweizer Markt bedienen.

Die Überraschung kam vielleicht nicht so laut wie bei der DSGVO, aber die Auswirkungen sind ähnlich: Marketingabteilungen müssen Abläufe überprüfen, Consent einholen und Mitarbeiter schulen.

Fazit dieser Rundschau: Ob DSGVO, TTDSG/TDDDG, revDSG, CCPA oder andere – die Tendenz ist klar. Überall entstehen strenge Datenschutzgesetze, die Marketingstrategien beeinflussen. Marketer müssen in jedem Zielmarkt die Spielregeln kennen. Das klingt erstmal kompliziert (ist es zuweilen auch), aber es zahlt sich aus: Wer Datenschutz global ernst nimmt, punktet bei Kunden mit Vertrauen und vermeidet teure Ausrutscher.

Auswirkungen auf Marketingstrategien: Was ändert sich?

Angesichts dieser Datenschutz-Offensive bleibt natürlich die Frage: Was bedeutet das konkret für Ihre Marketingstrategie? Müssen wir jetzt Marketing ohne Daten machen? Ganz so dramatisch ist es nicht. Aber einfach weitermachen wie bisher – das funktioniert definitiv nicht mehr. Datenschutzgesetze haben deutliche Auswirkungen auf alle Bereiche des Marketings, von E-Mail-Kampagnen über Web-Analytics bis hin zur Werbung in sozialen Medien. Hier ein Überblick, wo es hakt und wie man gegensteuern kann:

E-Mail-Marketing: Nur noch mit Permission und Mehrwert

E-Mail-Marketing ist ein Klassiker, aber durch DSGVO & Co. wurden die Regeln verschärft. „Double Opt-in“ ist heute der Goldstandard: Empfänger müssen aktiv zustimmen und ihre Adresse bestätigen, bevor sie Newsletter erhalten.

Vergessen Sie Kauf von Mailinglisten – solche Praktiken sind ein No-Go. Stattdessen heißt es: Qualität statt Quantität. Marketer müssen Empfänger überzeugen, freiwillig ihre Daten zu geben. Das gelingt etwa mit klarem Mehrwert, personalisierten Inhalten und transparenter Kommunikation. Ein vorbildliches Beispiel: Klare Consent-Banner im Newsletter-Abo („Ja, ich will Infos per E-Mail“) und eine Bestätigungsmail, die der Nutzer nochmals aktiv bestätigt. Klingt aufwendig? Vielleicht. Doch es stärkt das Vertrauen und sorgt für engagierte Leser. Studien deuten an, dass sauber eingeholte Einwilligungen das Vertrauen in die Marke fördern – und was bringt mehr, als Abonnenten, die wirklich lesen wollen, was Sie schicken?

Zudem fordert die DSGVO Datenminimierung: Sammeln Sie im Formular wirklich nur die Infos, die Sie benötigen. Eine E-Mail-Adresse und ein Name reichen meist. Jede zusätzliche Pflichtfrage schreckt ab und könnte im Ernstfall hinterfragt werden. Und achten Sie auf Abmeldemöglichkeiten in jeder Mail (das verlangen übrigens neben der DSGVO auch Gesetze gegen unlauteren Wettbewerb). Ein häufiger Irrtum ist, dass B2B-E-Mail-Marketing weniger streng sei. Doch Vorsicht: Auch die geschäftliche E-Mail-Adresse Max.Mustermann@firma.de ist personenbezogen – der Schutz gilt also gleichermaßen. Lediglich im Wettbewerbsrecht gibt es in manchen Ländern Erleichterungen für B2B (z.B. dürfen in Deutschland unter bestimmten Bedingungen Bestandskunden-Newsletter ohne neue Einwilligung versandt werden).

Dennoch: auf Einwilligung und klaren Opt-out sollte man auch im B2B nicht verzichten. Alles andere wäre ein Tanz auf dünnem Eis.

Web-Tracking und Analytics: Die Ära der Cookie-Einwilligung

Web-Analytics, Personalisierung, Retargeting – wir Marketingtreibende lieben unsere Daten. Doch die Gesetzeslage bremst hier am deutlichsten. Früher konnte man frohen Mutes Google Analytics oder Facebook Pixel einbauen und munter tracken, wer die Website besucht. Heute gilt: Tracking nur mit Zustimmung. Cookie-Banner sind allgegenwärtig und viele Nutzer klicken lieber auf „Ablehnen“ als auf „Akzeptieren“. Das Ergebnis? Lücken in den Daten, weniger granulare Insights. Marketer stehen vor der Frage: Wie analysieren wir unsere Kampagnen, wenn 30%, 40% oder mehr der Besucher nicht getrackt werden dürfen?

Eine Antwort liegt in datenschutzfreundlichen Alternativen. Es gibt Tools, die anonymisierte Statistiken liefern oder Daten nur noch serverseitig erheben, um den Nutzer zu schützen. Oder man setzt auf Lösungen „Made in EU“, die keine Daten in Drittstaaten schicken (Stichwort Schrems II – das EuGH-Urteil, das den Datentransfer in die USA erschwert hat). Tatsächlich haben einige Unternehmen reagiert und nutzen selbst gehostete Analytics oder Dienste wie Matomo/Piwik Pro, die versprechen DSGVO-konform zu sein. Die deutschen Aufsichtsbehörden betonen, dass alle Informationen, die einen Nutzer identifizierbar machen können – selbst pseudonyme IDs – dem Datenschutz unterliegen.

Das bedeutet praktisch: einwilligungsfreies Tracking ist nur bei wirklich anonymen Daten zulässig (wo kein Personenbezug mehr herstellbar ist).

Wie also Marketing betreiben? Kontextuelles Targeting erlebt eine Renaissance. Anstatt Nutzer über Cookies zu verfolgen, schaltet man Werbung basierend auf dem Kontext der Website (so wie in alten Printzeiten: Autowerbung im Auto-Magazin). Auch First-Party-Daten werden entscheidend: Daten, die Sie selbst direkt vom Kunden mit dessen Einwilligung erhalten haben (z.B. via Kundenkonto oder Umfragen), sind Gold wert. Unternehmen bauen verstärkt eigene CRM-Datenbanken auf und nutzen diese, anstatt sich auf Third-Party-Cookies von Werbenetzwerken zu verlassen.

Ein weiterer Trend sind sogenannte Data Clean Rooms – eine technisch komplexe, aber spannende Lösung: Zwei Parteien (z.B. Werbekunde und Publisher) laden ihre First-Party-Daten in eine geschützte Umgebung hoch, wo sie zusammengeführt und analysiert werden, ohne dass personenbezogene Rohdaten ausgetauscht werden. So kann man gemeinsame Schnittmengen für Kampagnen finden, ohne die Privatsphäre zu verletzen. Klingt futuristisch? Mag sein, aber in Zeiten, in denen Third-Party-Cookies vor dem Aus stehen (Stichwort: Google will sie in Chrome demnächst abschaffen), suchen Marketer händeringend nach neuen Wegen. Datenschutzgesetze zwingen uns hier letztlich zu Innovation. Und wer früh umdenkt, hat einen Vorteil.

Online-Werbung und Social Media: Personalisierung unter Vorbehalt

Personalisierte Online-Werbung ist Fluch und Segen zugleich. Einerseits bringen zielgerichtete Ads bessere Conversion Rates, andererseits sind sie datenschutzrechtlich ein Minenfeld. Unter DSGVO & Co. benötigt Behavioral Advertising (also Werbung basierend auf Surfprofilen) in der Regel eine Einwilligung oder eine sehr sorgfältige Interessenabwägung. Die DSGVO erlaubt zwar Direktmarketing auf Basis berechtigter Interessen, aber nur solange die Schutzinteressen der Nutzer nicht überwiegen.

Übersetzt: Wenn ein Nutzer voraussichtlich mit einer bestimmten Werbung rechnet und sie als wenig eingriffsintensiv wahrnimmt, kann es okay sein.

Doch wo genau diese Grenze liegt, ist oft unklar.

Viele Unternehmen gehen deshalb auf Nummer sicher und fragen lieber nach Consent, bevor sie etwa personalisierte Anzeigen ausspielen. Plattformen wie Facebook haben ihr System umgestellt – Werbetreibende müssen nun selbst sicherstellen, dass sie die nötige Erlaubnis haben, etwa um Custom Audiences (Kundenlisten bei Facebook) zu nutzen.

Für Social-Media-Pixel (Facebook Pixel, LinkedIn Insight Tag etc.) gilt: ohne Opt-in läuft nichts. Einige Webseiten bieten deshalb anfangs eine reduzierte Seite ohne Tracking an und aktivieren erst nach Zustimmung die Social-Media-Integrationen.

Ein Nebeneffekt: Influencer-Marketing und Content-Marketing erfahren Aufwind. Warum? Weil diese Strategien oft mit weniger personenbezogenen Daten auskommen. Wenn ein Influencer Ihr Produkt vorstellt, müssen Sie keine Liste an personenbezogenen Daten verarbeiten – die Botschaft wird breit gestreut und trifft im Idealfall die richtigen Personen durch den passenden Kanal. Natürlich sollte man auch hier vertraglich regeln, dass Influencer geltende Werbekennzeichnungs-Pflichten etc. einhalten, aber aus reiner Datenschutz-Sicht ist es weniger heikel als klassisches Tracking. B2B-Unternehmen zum Beispiel fragen sich, ob sich Influencer-Marketing im B2B lohnt – aber das ist ein Thema für sich (Spoiler: mit authentischen Branchenexperten kann es funktionieren, aber auch hier immer auf Datenschutz beim Umgang mit Community-Daten achten!).

Kurzum: Online-Werbung ist noch möglich, aber sie braucht einen Privacy-fokussierten Ansatz. Transparenz wird großgeschrieben – Nutzer müssen klar informiert werden, warum sie welche Werbung sehen und wie sie widersprechen können.

Außerdem sollten Werbestrategien Plan B parat haben: etwa sofort auf kontextuelle Ads umschalten, falls Tracking-Einwilligungen ausbleiben. Unternehmen, die flexibel sind und den Datenschutz respektieren, werden weniger Streuverluste haben als solche, die starr auf alten Methoden beharren und dabei einen Großteil der Zielgruppe aufgrund von Opt-Outs verlieren.

Datenmanagement und CRM: Weniger ist mehr

Häufig unterschätzt, aber enorm wichtig: Datenhygiene und Prozessanpassungen im Hintergrund. Marketingstrategien stützen sich auf Datenbanken – etwa von Kunden, Leads, Website-Besuchern. Durch die Datenschutzgesetze sind Datenqualität und Minimierung entscheidend. Fragen Sie sich bei jedem Feld in Ihrem CRM: Brauche ich diese Information wirklich für meine Marketingzwecke? Wenn nicht, weg damit. Zum einen dürfen nur für definierte Zwecke Daten gesammelt werden (Zweckbindung), zum anderen reduziert das auch das Risiko bei Datenschutzverletzungen. Weniger Daten = weniger Angriffsfläche.

Zudem verlangen die Gesetze Rechenschaftspflicht: Sie müssen jederzeit nachweisen können, dass Sie gesetzeskonform handeln.

Im Marketing heißt das z.B., nachweisen zu können, wann und wie ein Kunde seine Newsletter-Einwilligung gegeben hat. Dafür haben viele Firmen Consent-Management-Plattformen (CMPs) eingeführt, die Einwilligungen einholen, dokumentieren und Nutzern auch ermöglichen, sie zu widerrufen. Solche CMPs sind im modernen Marketing-Stack fast schon Pflicht und helfen, den Überblick zu behalten. Kein Wunder, dass diese Tools boomen.

Eine weitere Baustelle: Löschkonzepte. Die DSGVO verlangt, Daten nicht länger als nötig zu speichern. Marketing muss daher definieren, wann z.B. ein Lead, der sich 2 Jahre nicht gemeldet hat, gelöscht oder anonymisiert wird. Auch Backups und alte Excel-Listen voller Daten gehören auf den Prüfstand – hier schlummern gern vergessene Datenschätze, die zum Datenschutz-Risiko werden. Unternehmen tun gut daran, regelmäßige Daten-Audits durchzuführen: Welche Daten haben wir, wo kommen sie her, wer hat Zugriff, und sind alle Einwilligungen noch aktuell?

Diese Fragen klingen nicht spannend, aber sie sind die Grundlage für datenschutzkonformes Agieren.

Last but not least: Teamwork zwischen Marketing und Datenschutzabteilung. Falls Ihr Unternehmen einen Datenschutzbeauftragten hat, beziehen Sie ihn frühzeitig ein, wenn neue Kampagnen oder Tools geplant sind. Das verhindert, dass man am Ende viel Geld in ein Projekt steckt, das so gar nicht umsetzbar ist. Die Devise lautet: Datenschutz nicht als Show-Stopper sehen, sondern als Qualitätssiegel. Wenn Ihre Kampagne alle Datenschutz-Haken kriegt, können Sie sie mit ruhigem Gewissen fahren – und das gute Gefühl überträgt sich letztlich auch auf die Kundenbeziehung.

Häufige Irrtümer: Was Marketer oft falsch verstehen

Trotz aller Informationen gibt es ein paar Dauerirrtümer, die sich im Marketing halten. Räumen wir damit auf:

„B2B-Daten fallen nicht unter Datenschutz.“

Doch, tun sie. Auch Ansprechpartner in Unternehmen sind Menschen mit persönlichen Daten. Es gibt im Datenschutzrecht keine generelle Ausnahme für B2B. Jede E-Mail-Adresse und Telefonnummer, die eine Person beziehbar macht, unterliegt dem Schutz. Der Unterschied liegt allenfalls im UWG (Wettbewerbsrecht), nicht im Datenschutz. Trugschluss enttarnt!

„Wenn Daten öffentlich sind, darf ich sie nutzen.“ – Viele glauben, was im Internet steht (z.B. LinkedIn-Profile oder Branchenverzeichnisse), dürfe man frei fürs Marketing verwenden. Falsch: Auch öffentlich einsehbare Daten sind personenbezogen und ihre Nutzung braucht eine Rechtsgrundlage. Nur weil Herr X seine Telefonnummer ins Web gestellt hat, heißt das nicht, dass er unverlangt Werbeanrufe schätzt.

„Einmal Einwilligung, immer gültig.“

Einwilligungen sind kein Freifahrtschein für alle Ewigkeit. Nutzer können sie jederzeit widerrufen. Außerdem können Einwilligungen „verfallen“, wenn sie zu lange zurückliegen ohne Verwendung. Best Practice: Holen Sie eine neue Zustimmung ein, wenn Sie jemanden jahrelang nicht kontaktiert haben – oder verzichten Sie lieber ganz. Nichts ist peinlicher, als einen Empfänger anzuschreiben, der sich nicht mehr erinnert und sich beschwert.

„Kleine Unternehmen haben nichts zu befürchten.“

Oft gehört: „Uns kennt doch keiner, die Behörde wird sich um uns nicht scheren.“ Darauf sollte man nicht wetten. Zwar waren viele der ganz großen Bußgelder bei Konzernen, aber auch KMUs und Selbständige wurden schon abgemahnt oder mit Strafzahlungen belegt.

Zudem: Kunden und Wettbewerber achten ebenfalls auf Datenschutz. Ein Verstoß kann über Umwege ans Licht kommen (z.B. ein verärgerter Empfänger meldet einen Spam-Newsletter). Und gerade im deutschsprachigen Raum gibt es die Abmahnkultur – Mitbewerber könnten Datenschutzverstöße als unlauteren Wettbewerb abmahnen. Also bitte: auch als „Kleiner“ das Thema ernst nehmen.

„Datenschutz ruinert Marketing-Erfolg.“

Hier steckt ein Körnchen Wahrheit: Ja, kurzfristig erschwert Datenschutz manche altbewährte Taktik. Aber langfristig profitieren Sie. Warum? Weil vertrauenswürdiges Marketing Kunden bindet. Eine Umfrage nach der anderen zeigt, dass Verbraucher sensibel auf den Umgang mit ihren Daten reagieren. Wer offen und fair agiert, gewinnt an Reputation. Datenschutz kann so gesehen zum USP werden – ein Qualitätsmerkmal, das Sie vom Wettbewerb abhebt, der vielleicht noch grenzwertige Methoden nutzt. Außerdem zwingt der Druck zu kreativeren Strategien: Bessere Inhalte, innovativere Werbeansätze, neue Technologien. Datenschutz ist kein Marketing-Killer, sondern ein Game-Changer, der die Spielregeln neu definiert.

Praktische Tipps für datenschutzkonformes Marketing

Nachdem wir die Theorie und ein paar Stolperfallen kennen, hier konkrete Tipps, wie Sie Ihre Marketingstrategie datenschutzfreundlich gestalten – ohne dabei Ihre Ziele aus den Augen zu verlieren:

- Transparenz first: Sagen Sie Ihren Nutzern klipp und klar, was Sie mit ihren Daten vorhaben. Eine gut verständliche Datenschutzerklärung und klare Hinweise („Wir nutzen Ihre E-Mail für XY, Sie können sich jederzeit abmelden“) schaffen Vertrauen.

Verstecken Sie nichts im Kleingedruckten – das kommt sowieso raus. - Consent-Management nutzen: Integrieren Sie eine Consent-Management-Plattform (CMP) auf Ihrer Website. Sie erleichtert das Einholen, Verwalten und Nachweisen von Einwilligungen.

- Achten Sie darauf, dass Nutzer dort ihre Einstellungen auch nachträglich ändern können (z.B. Cookies abwählen). Das zeigt, dass Sie ihre Kontrolle respektieren.

- Datenhaushalt aufräumen: Führen Sie ein Daten-Inventar. Wissen Sie, wo überall personenbezogene Daten liegen? Erstellen Sie eine Liste aller Tools und Datenbanken, die Sie fürs Marketing nutzen (Newsletter-Tool, CRM, Analytics, Ad-Plattformen, etc.). Löschen Sie Altlasten und konsolidieren Sie Daten, wo möglich. Und ganz wichtig: Löschen nach Plan. Richten Sie automatische Routinen ein, um veraltete Leads oder inaktive Kontakte nach einer definierten Zeit zu entfernen.

- Privacy by Design umsetzen: Bei neuen Kampagnen oder Tools denken Sie Datenschutz von Anfang an mit. Wählen Sie z.B. Standard-Einstellungen datenschutzfreundlich (keine vorangekreuzten Häkchen; Tracking erstmal aus bis Opt-in kommt – genau das meint Privacy by Default). Wenn Sie eine neue Marketing-Software evaluieren, schauen Sie, ob sie DSGVO-konform ist und wo die Daten gehostet werden. Im Zweifel lieber einen europäischen Anbieter wählen.

- Schulungen und Verantwortlichkeiten: Sensibilisieren Sie Ihr Marketing-Team. Jeder, der mit Kundendaten arbeitet, sollte die Grundlagen kennen. Machen Sie klipp und klar, wer im Team für Datenschutzfragen zuständig ist (intern oder eben der externe Datenschutzbeauftragte). So entstehen bei Unsicherheiten keine Alleingänge, sondern man holt Rat ein. Ein informierter Mitarbeiter macht weniger Fehler – und Fehler im Datenschutz können teuer werden.

- Kreative Alternativen nutzen: Entwickeln Sie Marketingideen, die ohne intensive personenbezogene Daten auskommen. Zum Beispiel Content-Marketing: Ein guter Blogartikel (so wie dieser hier

) kann potenzielle Kunden anlocken, ohne dass man sie vorher tracken musste. Oder veranstalten Sie Webinare/Events, bei denen die Teilnehmer freiwillig ihre Daten dalassen, weil der Content überzeugt. Je mehr der Nutzer aus eigenem Antrieb kommt, desto weniger müssen Sie ihm hinterherlaufen – und datenschutzrechtlich ist das unbedenklicher.

) kann potenzielle Kunden anlocken, ohne dass man sie vorher tracken musste. Oder veranstalten Sie Webinare/Events, bei denen die Teilnehmer freiwillig ihre Daten dalassen, weil der Content überzeugt. Je mehr der Nutzer aus eigenem Antrieb kommt, desto weniger müssen Sie ihm hinterherlaufen – und datenschutzrechtlich ist das unbedenklicher. - Monitoring und Anpassung: Datenschutzgesetze entwickeln sich weiter. Bleiben Sie am Ball: Abonnieren Sie Newsletter zu rechtlichen Entwicklungen (etwa von IHKs oder Datenschutzblogs). Führen Sie jährlich einen Privacy-Check Ihrer Marketingaktivitäten durch. Fragen Sie sich: Gibt es neue Gesetze (z.B. eine ePrivacy-Verordnung irgendwann), neue Urteile oder Behörden-Trends, die uns betreffen? So können Sie Änderungen proaktiv in Ihre Strategie einbauen, bevor es andere tun.

DSGVO und Barrierefreiheit: Zwei Welten, ein gemeinsames Ziel

Auf den ersten Blick scheinen Datenschutz und Barrierefreiheit zwei getrennte Baustellen zu sein. Die DSGVO schützt persönliche Daten, während neue Gesetze wie das Barrierefreiheitsstärkungsgesetz (BFSG) oder der European Accessibility Act (EAA) digitale Angebote für Menschen mit Einschränkungen zugänglich machen sollen. Doch wer genauer hinsieht, erkennt: Beide Rechtsbereiche haben eine überraschend enge Verbindung.

Wo sich Datenschutz und Barrierefreiheit überschneiden

- Cookie-Banner: Nach DSGVO Pflicht – nach Barrierefreiheitsrecht müssen sie auch für Screenreader, Tastaturbedienung und Menschen mit Sehschwäche nutzbar sein.

- Formulare: Newsletter-Anmeldungen brauchen eine klare Einwilligung (DSGVO), gleichzeitig korrekte Beschriftungen und einfache Navigation (Barrierefreiheit).

- Selbstbedienungsportale: DSGVO gibt Nutzern Rechte wie Auskunft oder Löschung. Damit diese Rechte praktisch genutzt werden können, müssen die Portale barrierefrei gestaltet sein.

- Datenschutzerklärungen: DSGVO fordert Verständlichkeit. Barrierefreiheitsgesetze legen zusätzlich Wert auf leichte Sprache, Vorlesefunktionen oder kontrastreiche Darstellung.

Mehr als nur Pflicht: Ein Wettbewerbsvorteil

Wer Datenschutz und Barrierefreiheit gemeinsam denkt, schafft nicht nur Rechtssicherheit, sondern auch Vertrauen. Nutzer spüren sofort, ob ein Unternehmen Rücksicht auf ihre Privatsphäre nimmt und niemanden ausschließt. Das Ergebnis: höhere Akzeptanz, bessere Nutzererfahrung und ein klarer Imagegewinn.

DSGVO und Barrierefreiheit sind keine getrennten Welten, sondern zwei Seiten derselben Medaille. Zusammen sorgen sie dafür, dass digitale Angebote wirklich gerecht, sicher und zugänglich sind – für alle.

Schlussgedanken: Datenschutz als Chance begreifen

Vielleicht haben Sie beim Lesen gemerkt: Datenschutz im Marketing ist zwar komplex, aber kein unüberwindbares Hindernis. Im Gegenteil – wer es clever anstellt, kann aus der Not eine Tugend machen. Ja, wir Marketer mussten umdenken. Von der bequemen Datenflut-Party hin zu einem bewussteren, respektvolleren Umgang mit Informationen. Doch dieser Wandel bringt auch Vorteile: höhere Datenqualität, mehr Vertrauen bei Kunden, langfristig effektivere Kampagnen. Die aktuellen Datenschutzgesetze zwingen uns, genauer hinzuschauen und unsere Marketingstrategien gründlicher zu planen. Einfach blind Ads schalten oder Massenmails versenden war gestern. Heute gewinnt durchdachtes Marketing, das Kreativität mit Compliance vereint.

Natürlich, es wird immer etwas Spannung bleiben zwischen Datenhunger und Datenschutz. Konsumenten wollen personalisierte Erlebnisse, aber keine Überwachung. Unternehmen wollen erfolgreiche Werbung, aber keine Skandale. Die Kunst liegt darin, die Balance zu finden. Unternehmen, die diese Balance meistern, profitieren doppelt: Sie vermeiden rechtliche Risiken und profilieren sich als vertrauenswürdige Marke. Vielleicht ist das ja die wichtigste Erkenntnis: Datenschutz und Marketing sind kein Widerspruch, sondern können Hand in Hand gehen. Es lohnt sich also, das Thema nicht nur juristisch abzuhaken, sondern strategisch in den Vordergrund zu rücken.

Am Ende des Tages steht der Mensch im Mittelpunkt – der Kunde, dessen Daten wir nutzen möchten. Behandeln wir diese Daten mit Respekt, dann danken es uns die Kunden mit Loyalität. Und das ist doch das ultimative Ziel jeder Marketingstrategie, oder? In diesem Sinne: Datenschutz ist gekommen, um zu bleiben. Machen wir das Beste draus – für Ihre Kunden, für Ihr Marketing und für ein Internet, in dem Privatsphäre und Personalisierung im Einklang möglich sind.

FAQ – Datenschutzgesetze und Marketingstrategien

Warum sind Datenschutzgesetze für Marketingstrategien so wichtig?

Datenschutzgesetze wie die DSGVO oder das neue TDDDG geben klare Regeln vor, wie personenbezogene Daten erhoben, gespeichert und genutzt werden dürfen. Für Marketer bedeutet das: Jede Werbemaßnahme, die Daten betrifft – von E-Mail-Marketing über Cookies bis hin zu Social Ads – muss gesetzeskonform gestaltet sein. Verstöße können nicht nur teuer werden, sondern auch das Vertrauen der Kunden dauerhaft schädigen.

Welche Daten fallen eigentlich unter „personenbezogene Daten“?

Viele unterschätzen, wie breit dieser Begriff gefasst ist. Neben klassischen Daten wie Name, Adresse oder Telefonnummer gelten auch IP-Adressen, Cookie-IDs, Standortdaten oder sogar Kundenpräferenzen als personenbezogen. Selbst eine geschäftliche E-Mail-Adresse („vorname.nachname@firma.de

“) ist geschützt.

Darf ich für Marketingzwecke einfach E-Mail-Adressen kaufen?

Nein. Der Kauf oder Tausch von Adresslisten ist in der Regel unzulässig. Nach DSGVO ist eine gültige Einwilligung der betroffenen Person erforderlich. Zudem riskieren Sie hohe Abmelderaten und Imageschäden. Empfehlenswerter ist der Aufbau einer eigenen, qualitativ hochwertigen Verteilerliste über Double-Opt-in.

Wie wirkt sich das TDDDG (Nachfolger des TTDSG) auf Cookie-Banner aus?

Das TDDDG schreibt seit 2024 vor, dass Informationen auf Endgeräten (z. B. Cookies, Local Storage) nur mit Einwilligung des Nutzers gespeichert oder ausgelesen werden dürfen – außer sie sind technisch notwendig. Das bedeutet: Ohne ein korrektes Consent-Management-System geht es praktisch nicht mehr.

Ist B2B-Marketing von Datenschutzregelungen weniger betroffen?

Ein weit verbreiteter Irrtum. Auch im B2B-Bereich sind personenbezogene Daten geschützt. Zwar gibt es kleine Unterschiede im Wettbewerbsrecht, aber grundsätzlich gilt: Jede personenbezogene Information, die Sie verarbeiten, unterliegt den Datenschutzgesetzen – egal ob im B2C- oder B2B-Kontext.

Welche Strafen drohen bei Verstößen gegen die DSGVO?

Die DSGVO sieht Bußgelder von bis zu 20 Millionen Euro oder 4 % des weltweiten Jahresumsatzes vor – je nachdem, welcher Betrag höher ist. Selbst kleine Unternehmen wurden bereits zu fünfstelligen Summen verurteilt. Neben Geldstrafen droht vor allem Reputationsverlust.

Was bedeutet „Privacy by Design“ im Marketing?

„Privacy by Design“ heißt, dass Datenschutz von Beginn an in Kampagnen und Tools eingebaut wird. Praktisch bedeutet das: Standardeinstellungen sind datensparsam, Opt-ins werden klar eingeholt, unnötige Felder in Formularen werden weggelassen und Datenflüsse regelmäßig überprüft.

Welche Alternativen gibt es, wenn Nutzer Cookies ablehnen?

Kontextuelles Targeting ist eine datenschutzfreundliche Lösung: Werbung wird anhand des Seiteninhalts geschaltet, nicht anhand des Nutzerprofils. Zudem gewinnen First-Party-Daten (selbst erhobene Daten mit Einwilligung) stark an Bedeutung. Moderne Ansätze wie Data Clean Rooms ermöglichen Kooperationen ohne direkte Weitergabe von Rohdaten.

Muss ich meine alten Kundendaten löschen?

Ja, wenn sie keinen Zweck mehr erfüllen. Die DSGVO schreibt vor, dass Daten nur so lange gespeichert werden dürfen, wie sie für den ursprünglichen Zweck benötigt werden. Haben Sie beispielsweise seit Jahren keinen Kontakt mehr zu einem Lead, sollten Sie die Daten löschen oder anonymisieren.

Sind Newsletter-Tracking-Pixel noch erlaubt?

Nur mit Einwilligung. Das heimliche Öffnungs-Tracking per unsichtbarem Pixel ist nicht mehr zulässig. Sie müssen Ihre Empfänger darüber informieren und deren Zustimmung einholen, wenn Sie diese Form des Trackings einsetzen möchten.

Gilt die DSGVO auch für Unternehmen außerhalb Europas?

Ja. Sobald ein Unternehmen Daten von EU-Bürgern verarbeitet oder Marketing in der EU betreibt, greift die DSGVO – unabhängig vom Firmensitz. Deshalb haben viele internationale Konzerne ihre Datenschutzstandards angepasst.

Wie kann Datenschutz im Marketing als Vorteil genutzt werden?

Transparenz schafft Vertrauen. Unternehmen, die offen kommunizieren, welche Daten sie erheben und warum, wirken seriös und kundenorientiert. Ein klarer Datenschutzansatz kann sogar zum Wettbewerbsvorteil werden – gerade in Märkten, in denen Verbraucher sensibel auf ihre Daten achten.

Quellenangaben

- Heise Online – DSGVO: Überblick und Grundlagen

https://www.heise.de/thema/DSGVO - Bitkom – Datenschutzgrundverordnung: Wichtige Regelungen für Unternehmen

https://www.bitkom.org/Themen/Datenschutz/DSGVO - Datenschutzkonferenz (DSK) – Orientierungshilfe für Anbieter von Telemedien

https://www.datenschutzkonferenz-online.de/ - Handelsblatt – Was das neue Datenschutzgesetz (TDDDG) bedeutet

https://www.handelsblatt.com/ - Datenschutz.org – TTDSG: Cookie-Regelungen in Deutschland

https://www.datenschutz.org/ttdsg/ - CMS Law – EU ePrivacy-Verordnung: Stand und Auswirkungen

https://cms.law/de/deu/publication/eprivacy-verordnung - CNIL (Frankreich) – Cookie-Richtlinien & DSGVO

https://www.cnil.fr/ - Bitkom – Consent Management und Tracking unter der DSGVO

https://www.bitkom.org/Presse/Presseinformation/Consent-Management - Bundesbeauftragter für den Datenschutz (BfDI) – Informationspflichten und Rechte

https://www.bfdi.bund.de/ - Datenschutzgesetz Schweiz (revDSG) – Übersicht

https://www.edoeb.admin.ch/edoeb/de/home/datenschutz/gesetzgebung/revDSG.html - Handelszeitung – Neues Schweizer Datenschutzgesetz 2023: Was Unternehmen beachten müssen

https://www.handelszeitung.ch/ - CNBC – California fines Sephora $1.2 million for privacy violations under CCPA

https://www.cnbc.com/

Der Beitrag Überblick über aktuelle Datenschutzgesetze und deren Auswirkungen auf Marketingstrategien erschien zuerst auf Austrianweb Suchmaschinenoptimierung.

Deine Website bringt keine Kunden? Die häufigsten DIY-Fehler – und wie Austrianweb.at sie für dich löst 28 Jul 3:07 AM (2 months ago)

Du hast deine Website selbst erstellt, aber sie bringt kaum Besucher oder Kunden?

Statt gefunden zu werden, versinkt deine Seite irgendwo auf Seite 8 von Google? Keine Sorge: Damit bist du nicht allein.

Viele Selbstständige, Kleinunternehmen und Vereine erstellen ihre Homepage mit WordPress, Baukastensystemen oder sogar per HTML – aber die Technik und das Marketing dahinter werden oft unterschätzt.

In diesem Artikel zeigen wir dir die häufigsten Probleme von selbst erstellten Webseiten – und wie Austrianweb.at sie schnell, günstig und unkompliziert für dich löst.

Warum deine Website ohne Wartung zur Zeitbombe wird

„Ich habe meine Seite online – mehr brauche ich nicht.“

Das glauben viele. Doch genau hier beginnt die technische Verantwortung.

Die typischen Wartungsprobleme:

- keine regelmäßigen Sicherheits-Updates

- fehlende Backups bei Datenverlust

- langsame Ladezeiten durch nicht optimierte Bilder

- veraltete Plugins → Hackerangriff möglich

Ohne Wartung riskierst du Datenverlust, Angriffe oder fehlerhafte Darstellungen auf Mobilgeräten.

Austrianweb hilft:

Wir übernehmen die komplette Webseitenwartung, installieren automatisierte Backups, halten alles sicher und aktuell – du musst dich um nichts mehr kümmern.

Du hast keine Kunden? Ohne Strategie kein Erfolg.

Design allein bringt keine Anfragen.

Wenn deine Website keine klare Sprache spricht, nicht auf deine Zielgruppe eingeht oder ohne Konzept aufgebaut wurde, ist sie nur ein digitales Poster – kein Verkaufstool.

Häufige Fehler:

- Keine klare Zielgruppenansprache

- Fehlende Call-to-Actions (z. B. „Jetzt buchen“)

- Keine Inhalte, die Vertrauen aufbauen

Beispiel:

„Anna betreibt ein Kosmetikstudio in Niederösterreich. Sie hatte ihre Seite selbst gemacht – doch die Anfragen blieben aus. Wir analysierten ihren Auftritt, optimierten die Texte, bauten einen Online-Kalender ein – heute ist sie über Monate ausgebucht.“

Austrianweb hilft:

Wir erstellen mit dir eine Marketingstrategie, optimieren deine Inhalte oder übernehmen die gesamte Content-Erstellung – abgestimmt auf deine Kunden.

Google findet dich nicht? So löst du das SEO-Problem.

Ohne SEO ist deine Seite wie ein Geschäft im Hinterhof – keiner sieht’s.

Die häufigsten DIY-Fehler:

- keine oder falsche Meta-Titel & Beschreibungen

- unstrukturierte Inhalte ohne Keywords

- fehlende interne Verlinkung

- keine Ladezeit-Optimierung → Google straft ab

- Viele DIY-Seiten sind technisch nicht lesbar für Suchmaschinen.

Austrianweb hilft:

- kostenlose SEO-Erstanalyse

- gezielte Optimierung von Struktur, Ladezeiten, Texten & Technik

- optional: laufende SEO-Betreuung

Deine Seite sieht am Handy schrecklich aus?

Über 70 % der Webseitenaufrufe kommen heute über Mobilgeräte.

Wenn deine Seite nicht responsive ist, verlierst du Besucher – und potenzielle Kunden.

Häufige Probleme:

- Design „zerbricht“ auf kleinen Bildschirmen

- Texte sind unleserlich

- Buttons zu klein oder unbedienbar

Austrianweb hilft:

Wir machen deine Seite 100 % mobilfreundlich, verbessern die Usability und optimieren das Look & Feel auf allen Geräten.

DSGVO, Cookie-Banner & Impressum: Ist deine Website abmahnsicher?

Viele DIY-Webseiten verstoßen unbeabsichtigt gegen die DSGVO – und riskieren teure Abmahnungen.

- Kein oder falscher Cookie-Hinweis

- Fehlende Datenschutzerklärung

- Impressum unvollständig

Austrianweb hilft:

Wir prüfen deine Seite rechtlich (in Kooperation mit Rechtspartnern), integrieren rechtssichere Banner, Texte und sorgen für ein sauberes Impressum.

Barrierefreies Webdesign – bald Pflicht für viele Unternehmen

Ab 2025 gilt für viele Websites in Österreich und der EU: Barrierefreiheit ist kein “Nice to Have” mehr – sondern gesetzlich vorgeschrieben.

Was steckt dahinter?

Mit dem Barrierefreiheitsgesetz (BaFG) setzt Österreich die EU-Richtlinie 2019/882 („European Accessibility Act“) um. Das betrifft nicht nur Behörden, sondern auch private Unternehmen, insbesondere wenn sie Produkte oder Dienstleistungen online anbieten – also fast jede Firmenwebsite, jedes Buchungssystem, jeden Webshop.

Häufige Barrierefreiheitsprobleme:

- Keine Vorlesefunktion oder Tastaturnavigation

- Schlechter Farbkontrast

- Keine Alternativtexte für Bilder (Screenreader)

- Formulare sind nicht zugänglich

- Inhalte sind nicht logisch strukturiert

Das Ergebnis: Menschen mit Sehbehinderung, motorischen Einschränkungen oder kognitiven Hürden können deine Website nicht nutzen – was nicht nur unsozial ist, sondern auch gegen geltendes Recht verstoßen kann.

Unsere Angebote – maßgeschneidert für Selbstständige & KMU

Bei uns bekommst du Transparenz, Handschlagqualität und faire Preise:

Wartungspaket

Updates, Backups, Sicherheit

Content- & Marketingpaket

Zielgruppenanalyse, Textoptimierung, Strategie

SEO-Service

technisches SEO, Keyword-Analyse, Ladezeiten

DSGVO-Check

Impressum, Cookies, Datenschutzerklärung

Fazit: Mach aus deiner Website wieder ein Kundenmagnet!

Ob Wartung, SEO, Marketing oder Sicherheit:

Du musst das nicht selbst machen. Wir bei Austrianweb.at übernehmen das für dich – unkompliziert, kompetent und leistbar.

Kostenloser Service:

Jetzt kostenlose Website-Analyse anfordern

Innerhalb von 48 Stunden bekommst du einen Bericht mit konkreten Empfehlungen.

Kontakt:

Austrianweb.at – Deine Webagentur mit Handschlagqualität

office@austrianweb.at

+4369919238168

www.austrianweb.at

Österreichweit im Einsatz – persönlich, digital & unkompliziert

Der Beitrag Deine Website bringt keine Kunden? Die häufigsten DIY-Fehler – und wie Austrianweb.at sie für dich löst erschien zuerst auf Austrianweb Suchmaschinenoptimierung.

Googles neues KI-Feature: Antworten direkt im Suchergebnis 7 Apr 3:54 AM (6 months ago)

Google revolutioniert erneut die Suche: Mit einem neuen KI-Feature beantwortet Google viele Suchanfragen jetzt direkt auf der Ergebnisseite – ohne dass Sie zuerst auf einen externen Link klicken müssen. Dieses Feature, das zunächst in den USA getestet wurde, wird seit Anfang 2025 auch im deutschsprachigen Raum ausgerollt. Als Austrianweb verfolgen wir diese Entwicklung genau. In diesem Artikel erklären wir Ihnen, was es mit den KI-generierten Antworten („Übersicht mit KI“) auf sich hat, welche Vorteile es für Ihre Website haben kann, dort erwähnt zu werden, und was Sie als Websitebetreiber oder SEO-Agentur tun können, um in diesen KI-Antworten aufzutauchen.

Was ist das neue KI-Feature und wofür ist es gedacht?

Google reagiert auf komplexere Suchanfragen nun oft mit einer KI-generierten Antwort, die prominent oberhalb der üblichen Suchergebnisse angezeigt wird. Dieses Feld wird als „Übersicht mit KI“ gekennzeichnet und bündelt Informationen aus verschiedenen Quellen, um die Frage des Nutzers direkt zu beantworten. Statt einer reinen Linkliste erhält der Nutzer also eine ausformulierte Antwort, die von Googles generativer KI zusammengestellt wurde. Wichtig: Google blendet dabei weiterhin Verlinkungen ein – meist in Form von Quellenhinweisen oder kleinen „Weiterlesen“-Links innerhalb der KI-Antwort. Es wirkt jedoch so, als habe Google selbst die Frage auf der eigenen Seite beantwortet.

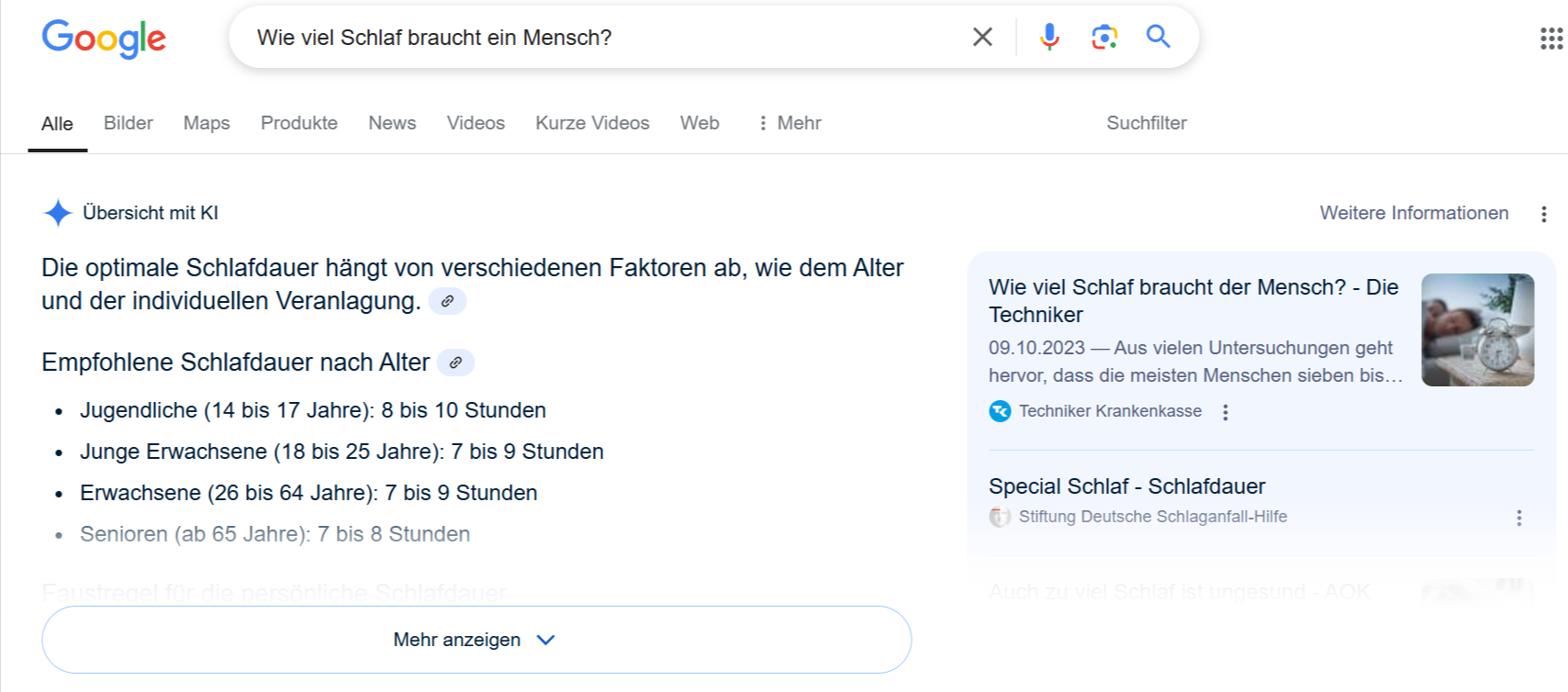

Beispiel einer KI-generierten Antwort in der Google-Suche (“Übersicht mit KI”): Hier wird die Frage „Wie viel Schlaf braucht ein Mensch?“ direkt in der Suche beantwortet. Die KI fasst Erkenntnisse aus mehreren Quellen zusammen und listet empfohlene Schlafdauer nach Alter auf. Nutzer können auf „Mehr anzeigen“ klicken, um die vollständige KI-Antwort zu sehen.

Google macht transparent, dass es sich um eine KI-Antwort handelt – das Feld trägt den Hinweis „Übersicht mit KI“ und am Ende steht oft der Zusatz „Generative KI ist experimentell“, um zu signalisieren, dass diese Antworten auch Fehler enthalten können. Bevor die KI-Antwort erscheint, sieht man einen kurzen Ladehinweis („Generieren…“), da der Inhalt in Echtzeit erstellt wird. Aktuell erhalten nur angemeldete Google-Nutzer ab 18 Jahren diese KI-Ergebnisse zu sehen, und auch nicht bei jeder Suchanfrage. Laut Google werden KI-Übersichten nur dann angezeigt, wenn die KI-Antwort voraussichtlich besonders hilfreich ist. Bei einfachen Suchen (z.B. eine Wetteranfrage) erscheint keine KI-Box, wohl aber bei komplexen Fragen oder Problemen, für die eine ausführliche Erklärung nützlich ist. So bekommt man etwa für die Frage „Wie kann ich ein PDF bearbeiten?“ oder „Welche Blumen kann ich jetzt im Garten pflanzen?“ direkt eine Schritt-für-Schritt-Anleitung von der KI präsentiert. Die KI greift dabei auf mehrere Quellen gleichzeitig zu: Durchschnittlich fließen Informationen von rund fünf unterschiedlichen Webseiten in eine generative Antwort ein. Über und unter der KI-Box blendet Google zudem Feedback-Buttons (Daumen hoch/runter) ein, mit denen Nutzer die Nützlichkeit der Antwort bewerten können.

Zusammengefasst ist dieses neue Feature dazu gedacht, Nutzeranfragen schneller und direkt zu beantworten. Google möchte Suchenden damit einen schnellen Überblick geben, ohne dass sie mühsam mehrere Websites durchforsten müssen. Gerade bei umfangreichen Fragestellungen kann die KI mehrere Infos kombinieren (und sogar unterschiedliche Perspektiven oder aktuelle Quellen einbeziehen) und dem Nutzer in Sekundenbruchteilen eine kompakte, kontextreiche Antwort liefern. Für Nutzer bedeutet das ein Zeitgewinn und oft eine bequemere Suche. Für Website-Betreiber und SEOs stellt sich jedoch die Frage: Was bringt es meiner Website, wenn sie in so einer KI-Antwort als Quelle dient?

Wie Sie als Nutzer von Googles KI-Antworten profitieren – und wie Sie bessere Ergebnisse erhalten

Nicht nur Webseitenbetreiber, auch ganz normale Suchende können von der neuen KI-Funktion profitieren. Denn Googles KI-Übersicht macht es deutlich einfacher, sich schnell und umfassend über ein Thema zu informieren – ohne lange durch verschiedene Webseiten klicken zu müssen.

Vorteile für Suchende:

- Schnellere Orientierung: Statt sich durch 5 oder 6 Links zu klicken, bekommen Sie mit einem Blick eine kompakte, gut strukturierte Zusammenfassung. Gerade bei komplexeren Fragen (z. B. „Was ist der Unterschied zwischen ETFs und Aktien?“) spart das viel Zeit.

- Mehrere Perspektiven in einer Antwort: Die KI zieht Informationen aus verschiedenen Quellen und verknüpft sie sinnvoll. So erhalten Sie nicht nur eine einseitige Erklärung, sondern oft mehrere Sichtweisen oder Varianten einer Lösung.

- Schritt-für-Schritt-Anleitungen: Bei vielen Fragen, die eine Handlung erfordern („Wie entferne ich Schimmel im Bad?“ oder „Wie bewerbe ich mich richtig?“), erstellt die KI konkrete Schrittlisten oder Anleitungen. Das ist besonders hilfreich, wenn man etwas direkt umsetzen möchte.

- Verständlichere Formulierungen: Die Antworten der KI sind oft in einfacher Sprache formuliert. Fachbegriffe werden erklärt, Sätze sind kürzer, die Struktur ist übersichtlich. Dadurch wird auch komplizierter Stoff leichter verständlich – ideal für alle, die kein Expertenwissen haben.

- Hinweise auf weiterführende Inhalte: Auch wenn die Antwort direkt in der Suche erscheint, können Sie bei Bedarf über Links auf tiefergehende Informationen zugreifen. Die KI verlinkt meist mehrere Quellen direkt im Text, die Sie mit einem Klick aufrufen können.

Wie Sie die besten KI-Antworten erhalten – Tipps für clevere Suchanfragen

Auch wenn die KI einiges automatisch erkennt, können Sie als Nutzer durch clevere Formulierungen gezielt bessere Ergebnisse auslösen. Hier ein paar Tipps:

Stellen Sie konkrete Fragen

Je klarer Ihre Frage, desto hilfreicher die Antwort. Statt „Schlaf“ lieber fragen:

„Wie viele Stunden Schlaf braucht ein Erwachsener pro Nacht?“

Die KI erkennt dann besser, was genau Sie wissen möchten, und gibt eine direkte Antwort.

Verwenden Sie Alltagsformulierung oder „Wie“-Fragen

Formulierungen wie „Wie kann ich…“, „Was ist…“ oder „Welche Vorteile hat…“ triggern oft besonders detaillierte Antworten.

Beispiel:

„Wie wechselt man eine Fahrradkette?“ liefert eine Schritt-für-Schritt-Anleitung – während „Fahrradkette wechseln“ nur allgemeine Links bringt.

Nutzen Sie vollständige Sätze

Auch wenn man es gewohnt ist, in Stichwörtern zu suchen, versteht die KI ganze Sätze oft besser.

Statt „Kühlschrank stinkt“ lieber: „Was kann ich tun, wenn mein Kühlschrank unangenehm riecht?“

Fragen Sie nach Alternativen oder Vergleichen

Die KI kann auch Vor- und Nachteile gegenüberstellen.

„Was ist besser: Mietwohnung oder Eigentum?“

„Welche Alternativen gibt es zu Photoshop?“

Verwenden Sie Zusatzbegriffe für mehr Kontext

Wenn Sie auf bestimmte Kriterien Wert legen, nennen Sie diese direkt.

„Laptop kaufen für Fotobearbeitung unter 1000 Euro“

„Kamera für Anfänger mit guter Videoqualität“

Klicken Sie auf „Mehr anzeigen“

Oft zeigt Google zuerst nur den Anfang der KI-Antwort. Mit einem Klick auf „Mehr anzeigen“ öffnet sich der vollständige Text – oft mit deutlich mehr Infos und zusätzlichen Quellen.

Fazit für Suchende:

Googles neue KI-Funktion kann Ihnen dabei helfen, schneller, gezielter und verständlicher Antworten auf Ihre Fragen zu finden. Besonders wenn Sie komplexe Themen recherchieren oder praktische Lösungen suchen, sparen Sie mit der „Übersicht mit KI“ viel Zeit. Nutzen Sie das Feature aktiv, indem Sie präzise und vollständige Fragen stellen – dann wird die KI Ihnen mit intelligenten, gut sortierten Informationen zur Seite stehen.

Wenn Sie auf der Suche nach einem effizienteren Sucherlebnis sind, ist dieses neue Feature definitiv ein echter Fortschritt. Probieren Sie es aus – und wenn Sie wissen wollen, wie Ihre Website auch Teil dieser Antworten wird, stehen wir von Austrianweb Ihnen gerne beratend zur Seite

Was bringt es einer Website, in den KI-Antworten erwähnt zu werden?

Wenn die Inhalte Ihrer Website von Google’s KI aufgegriffen und in der Antwort angezeigt werden, kann Ihnen das – trotz potenziell weniger direkter Klicks – einige handfeste Vorteile bieten:

- Höhere Sichtbarkeit: Ihre Marke bzw. Website erscheint ganz oben auf der Suchergebnisseite, eingebettet in die KI-Antwort. Da die KI-Ergebnisse oberhalb aller organischen Listings platziert sind, erhält Ihre Seite automatisch mehr Aufmerksamkeit als ein normaler Suchtreffer weiter unten. Selbst wenn der Nutzer nicht sofort klickt, nimmt er Ihren Namen als Teil der Lösung wahr. Diese Präsenz steigert die Reichweite Ihrer Inhalte und kann dazu führen, dass Nutzer sich Ihre Seite merken.

- Autorität und Vertrauen: Als Quellenangabe in einer KI-Antwort genannt zu werden, verleiht Ihrer Website Glaubwürdigkeit. Google wählt für diese Antworten bevorzugt „vertrauenswürdige Websites mit qualitativem Inhalt“, die bestimmte Qualitätsrichtlinien erfüllen. Erscheint Ihre Seite dort, signalisiert das den Nutzern, dass Ihre Inhalte fundiert und zuverlässig sind. Das kann Ihre Reputation als Experte in Ihrem Themengebiet stärken. Langfristig profitieren Expertise und Autorität Ihrer Marke davon, wenn Sie regelmäßig in solchen Antworten auftauchen.

- Chancen auf Klicks und Traffic: Auf den ersten Blick könnte man denken, dass Nutzer gar nicht mehr auf Websites klicken, wenn Google alles schon beantwortet. Tatsächlich zeigen frühe Analysen, dass generative Antworten die Gesamt-Klickrate reduzieren können. Aber: Wenn Ihre Seite in der KI-Box als Quelle auftaucht, haben Sie immer noch eine greifbare Chance auf einen Klick – nämlich dann, wenn der Nutzer mehr Details möchte oder der KI-Ausschnitt ihn neugierig macht. Ihre Seite wird in der Antwort oft als kleiner Link oder als Teil eines „Mehr Informationen“-Buttons angezeigt. Viele Nutzer klicken diese an, um die Originalquelle zu lesen, vor allem bei komplexen Themen. Insofern kann Ihre Klickrate relativ zu Wettbewerbern steigen, wenn Sie statt auf Position 5 oder 6 im normalen Ranking nun als eine von wenigen Quellen ganz oben sichtbar sind. Es gilt: Besser in der KI-Antwort vertreten sein, als komplett darunter zu verschwinden.

- Neue Chancen für kleinere Websites: Interessanterweise zieht die KI nicht nur die allerersten Google-Ergebnisse heran. Eine Untersuchung fand heraus, dass fast die Hälfte der Quellen für KI-Antworten von Domains stammen, die nicht in den Top-50 der organischen Suchergebnisse standen. Die KI fischt sich also gezielt sehr relevante Info-Brocken aus dem Web, selbst wenn die entsprechende Seite kein Top-Ranking hat. Für Sie bedeutet das: Auch wenn Ihre Website bisher in den Suchergebnissen weniger sichtbar war, können Sie durch gute Inhalte in einer KI-Antwort plötzlich Präsenz erhalten. Dieses Feature eröffnet neuen oder spezialisierten Seiten eine Gelegenheit, neben großen Konkurrenten zu erscheinen – gewissermaßen eine neue Ebene der Sichtbarkeit.

Natürlich gibt es auch die Kehrseite: Wenn Google vieles schon selbst beantwortet, könnten insgesamt weniger Nutzer direkt auf Websites durchklicken. Einige Experten befürchten deutliche Traffic-Verluste im zweistelligen Prozentbereich. Doch gerade deshalb ist es umso wichtiger, mit den eigenen Inhalten Teil der KI-Ergebnisse zu sein. So sichern Sie sich ein Stück vom Kuchen, statt in der unsichtbaren zweiten Ergebnishälfte zu verschwinden. Zudem bleibt abzuwarten, wie Nutzer mit diesen KI-Überblicken umgehen – oft werden tiefergehende Informationen weiterhin die Quellen benötigen. Insgesamt kann eine Erwähnung in der KI-Antwort Ihrer Seite also mehr Nutzen als Schaden bringen: Sie steigert Sichtbarkeit und wahrgenommene Autorität und hält die Chance auf Traffic aufrecht, während Seiten, die nicht auftauchen, an Reichweite verlieren könnten.

Was müssen Websites tun, um in den KI-Antworten berücksichtigt zu werden?

Die entscheidende Frage für SEO lautet nun: Wie schafft man es, dass die eigene Website von Googles KI als Quelle ausgewählt wird? Google selbst hat betont, dass klassisches „gutes“ SEO auch für die KI-Auswahl die Basis ist – es gelten also weiterhin die üblichen Suchrichtlinien (Google’s Search Essentials). Sie müssen keinen speziellen „KI-Feed“ einreichen oder dergleichen. Dennoch gibt es konkrete Strategien, um Ihre Chancen zu erhöhen, in KI-generierten Antworten aufzutauchen. Im Folgenden haben wir die wichtigsten Maßnahmen und Optimierungstipps zusammengestellt, von technischen Voraussetzungen bis Content-Strategie:

Technische Optimierung sicherstellen: Sorgen Sie dafür, dass Ihre Website technisch einwandfrei von Google erfasst werden kann. Eine saubere Crawlability (robots.txt und Meta-Tags erlauben das Indexieren der wesentlichen Inhalte) und schnelle Ladezeiten sind Grundvoraussetzung. Achten Sie auf Mobilfreundlichkeit und eine sichere Verbindung (HTTPS). Diese technischen SEO-Grundlagen beeinflussen zwar indirekt die KI-Übernahme, sind aber die Basis dafür, dass Google Ihre Inhalte überhaupt in Betracht zieht. Wenn Ihre Seite für den Crawler unzugänglich oder sehr langsam ist, sinken die Chancen, von der KI berücksichtigt zu werden, erheblich.

Klare, prägnante Antworten im Text bieten: Passen Sie Ihre Content-Aufbereitung an, damit Google daraus leicht eine Antwort ziehen kann. Eine bewährte Taktik ist es, schon am Anfang einer Seite die Kernfrage direkt und knapp zu beantworten – quasi als Zusammenfassung. Diese einleitenden Absätze oder Bulletpoints sollten die Suchanfrage präzise aufgreifen. Durch solche prägnanten Info-Blöcke erleichtern Sie es der KI, Ihre Seite als Quelle zu wählen. Schreiben Sie also nutzerzentriert: Überlegen Sie, welche Frage der Nutzer stellt, und beantworten Sie sie möglichst direkt und verständlich (natürlich ohne wichtige Details auszulassen).